第6章 多媒体基础知识

多媒体是对多种媒体的融合,是能够同时采集、处理、编辑、存储和展示两个或以上不同类型信息媒体的技术,这些信息媒体包括文字、声音、图形、图像、动画和活动影像等。本章主要介绍多媒体声音、图形图像、动画与视频、多媒体网络及多媒体计算机方面的基础知识。

6.1 多媒体的基本概念

6.1.1 多媒体基本概念

媒体(Media)通常包括两方面的含义:一是指信息的物理载体(即存储和传递信息的实体),如手册、磁盘、光盘、磁带以及相关的播放设备等;二是指承载信息的载体,即信息的表现形式(或者说传播形式),如文字、声音、图像、动画和视频等,即CCITT定义的存储媒体和表示媒体。

1.媒体的分类

表示媒体又可以分为三种类型:视觉类媒体(位图图像、矢量图形、图表、符号、视频和动画)、听觉类媒体(音响、语音和音乐)和触觉类媒体(点、位置跟踪;力反馈与运动反馈)。视觉和听觉类媒体是信息传播的内容,触觉类媒体是实现人机交互的手段。

媒体的概念范围相当广泛,按照国际电话电报咨询委员会(Consultative Committee on International Telephone and Telegraph, CCITT)的定义,媒体可以归类如下。

(1)感觉媒体(Perception Medium)。指直接作用于人的感觉器官,使人产生直接感觉的媒体。如引起听觉反应的声音,引起视觉反应的图像等。

(2)表示媒体(representation Medium)。指传输感觉媒体的中介媒体,即用于数据交换的编码。如图像编码(JPEG、MPEG)、文本编码(ASCII、GB2312)和声音编码等。

(3)表现媒体(Presentation Medium)。指进行信息输入和输出的媒体。如键盘、鼠标、扫描仪、话筒和摄像机等为输入媒体;显示器、打印机和喇叭等为输出媒体。

(4)存储媒体(Storage Medium)。指用于存储表示媒体的物理介质,如硬盘、软盘、磁盘、光盘、ROM及RAM等。

(5)传输媒体(Transmission Medium)。指传输表示媒体的物理介质,如电缆、光缆和电磁波等。

为了使不同的媒体能够有机地连接起来,往往按照实际需要建立一种链接机制或结构,把这种链接机制或结构称为超媒体(HyperMedia)。在计算机中,超媒体是一个信息存储和检索系统,它把文字、图形、图像、动画、声音和视频等媒体集成为一个相关的基本信息系统。通常,如果信息主要是以文字的形式表示,那么称为超文本;如果还包含有图形、影视、动画、音乐或其他媒体,一般称为超媒体。因特网的WWW应用是超媒体技术的最好例子。

2.多媒体的特征

在计算机领域中,“多媒体”常常被当作为“多媒体技术”的同义词。多媒体技术就是指利用计算机技术把文本、图形、图像、声音、动画和电视等多种媒体综合起来,使多种信息建立逻辑连接,并能对它们进行获取、压缩、加工处理、存储,集成为一个具有交互性的系统。多媒体技术的内涵和范围极其广泛,所涉及的技术也极为广泛,其主要特性如下。

(1)多样性。主要表现在信息媒体的多样化。多样性使得计算机处理的信息空间范围扩大,不再局限于数值、文本或特殊对待的图形和图像,可以借助于视觉、听觉和触觉等多感觉形式实现信息的接收、产生和交流。

(2)集成性。主要表现在多媒体信息(文字、图形、图像、语音和视频等信息)的集成和操作这些媒体信息的软件和设备的集成。多媒体信息的集成是将各种信息媒体按照一定的数据模型和组织结构集成为一个有机的整体。操作媒体信息的软件和设备的集成是将与多媒体相关的各种硬件和软件集成为一个理想的环境,使得充分共享和操作使用多媒体信息。

(3)交互性。这是多媒体应用有别于传统信息交流媒体的主要特点之一。传统信息交流媒体只能单向地、被动地传播信息,而多媒体技术引入交互性后则可实现人对信息的主动选择、使用、加工和控制。通过交互与反馈,达到更加有效地控制和使用信息,为人们提供发挥创造力的环境,增强了人们的参与感,同时也为多媒体技术应用开辟了更加广阔的领域。

(4)非线性。多媒体技术的非线性特点将改变人们传统循序性的读写模式。以往人们读写方式大都采用章、节、页的框架,循序渐进地获取知识,而多媒体技术将借助超文本链接的方法,把内容以一种更灵活、更具变化的方式呈现给读者。

(5)实时性。是指在人的感官系统允许的情况下进行多媒体处理和交互。当人们给出操作命令时,相应的多媒体信息都能够得到实时控制。

(6)信息使用的方便性。用户可以按照自己的需要、兴趣、任务要求、偏爱和认知特点来使用信息,获取图、文、声等信息表现形式。

(7)信息结构的动态性。用户可以按照自己的目的和认知特征重新组织信息,即增加、删除或修改节点,重新建立链接等。

6.1.2 虚拟现实基本概念

虚拟现实(virtual reality, VR)将是继多媒体、计算机网络之后,最具有应用前景的一种技术。它可应用于建模与仿真、科学计算可视化、设计与规划、教育与训练、医学、艺术与娱乐等方面。虚拟现实技术是一项综合的技术,涉及计算机科学、电子学、心理学、计算机图形学、人机接口技术、传感技术及人工智能技术等。这种技术的特点在于,运用计算机对现实世界进行全面仿真,创建与现实社会类似的环境,通过多种传感设备使用户“投入”到该环境中,实现用户与该环境直接进行自然交互。

1.虚拟现实技术的主要特征

虚拟现实是将现实世界的多维信息映射到计算机的数字空间生成相应的虚拟世界,主要包括基本模型构建、空间跟踪、声音定位、视觉跟踪和视点感应等关键技术。其主要特征有如下三个方面。

(1)多感知。就是说除了一般计算机所具有的视觉感知外,还有听觉感知、力觉感知、触觉感知、运动感知,甚至包括味觉感知和嗅觉感知等。理想的虚拟现实就是应该具有人所具有的感知功能。

(2)沉浸(又称临场感)。是指用户感到作为主角存在于模拟环境中的真实程度。理想的模拟环境应该达到使用户难以分辨真假的程度。

(3)交互。是指用户对模拟环境内物体的可操作程度和从环境得到反馈的自然程度(包括实时性)。例如,用户可以用手去直接抓取环境中的物体,这时手有握着东西的感觉,并可以感觉物体的重量,视场中的物体也随着手的移动而移动。

在虚拟环境中获取视觉、听觉、力觉和触觉等感官认知等关键技术,是保证虚拟世界中的事物所产生的各种刺激以尽可能自然的方式反馈给用户。

(1)视觉感知。虚拟环境中大部分具有一定形状的物体或现象,可以通过多种途径使用户产生真实感很强的视觉感知。CRT显示器、大屏幕投影、多方位电子墙、立体眼镜和头盔显示器(HMD)等是VR系统中常见的显示设备。不同的头盔显示器具有不同的显示技术,根据光学图像被提供的方式,头盔显示设备可分为投影式和直视式。

(2)听觉感知。听觉是仅次于视觉的感知途径,虚拟环境的声音效果,可以弥补视觉效果的不足,增强环境逼真度。用户所感受的三维立体声音,有助于用户在操作中对声音定位。

(3)力觉和触觉感知。能否让参与者产生“沉浸”感的关键因素之一是参与者能否在操纵虚拟物体的同时,感受到虚拟物体的反作用力,从而产生触觉和力觉感知。例如,当用手扳动虚拟驾驶系统的汽车档位杆时,手能感觉到档位杆的震动和松紧。力觉感知主要由计算机通过力反馈手套、力反馈操纵杆对手指产生运动阻尼,从而使用户感受到作用力的方向和大小。

2.虚拟现实技术的分类

虚拟现实技术出现了多样化的发展趋势,虚拟实现技术不仅仅是指那些戴着头盔和手套等技术,而且还应该包括一切与之有关的具有自然模拟、逼真体验的技术与方法,它的根本目标就是达到真实体验和基于自然技能的人机交互。能够达到或者部分达到这样目标的系统就称为虚拟现实系统。根据用户参与VR的不同形式以及沉浸的程度不同,可以把各种类型的虚拟现实技术大致划分为4类。

(1)桌面虚拟现实。桌面虚拟现实利用个人计算机和低级工作站进行仿真,将计算机的屏幕作为用户观察虚拟境界的一个窗口。通过各种输入设备实现与虚拟现实世界的充分交互,这些外部设备包括鼠标、追踪球和力矩球等。它要求参与者使用输入设备,通过计算机屏幕观察360°范围内的虚拟境界,并操纵其中的物体,但这时参与者缺少完全的沉浸,因为它仍然会受到周围现实环境的干扰。桌面虚拟现实的最大特点是缺乏真实的现实体验,但是成本也相对较低,因而,应用比较广泛。常见的桌面虚拟现实技术有基于静态图像的虚拟现实(QuickTimeVR)、虚拟现实造型语言(VRML)、桌面三维虚拟现实和MUD等。

(2)完全沉浸的虚拟现实。高级虚拟现实系统提供完全沉浸的体验,使用户有一种置身于虚拟境界之中的感觉。它利用头盔式显示器或其他传感设备,把参与者的视觉、听觉和其他感觉封闭起来,并提供一个新的、虚拟的感觉空间,利用位置跟踪器、数据手套、其他手控输入设备和声音等使得参与者产生一种身临其境、全心投入和沉浸其中的感觉。常见的沉浸式系统有:基于头盔式显示器的系统、投影式虚拟现实系统、远程存在系统等。

(3)增强现实性的虚拟现实。增强现实性的虚拟现实不仅是利用虚拟现实技术来模拟现实世界、仿真现实世界,而且要利用它来增强参与者对真实环境的感受,也就是增强现实中无法感知或不方便的感受。

(4)分布式虚拟现实。分布式虚拟现实系统是基于网络的虚拟环境,在这个环境中,位于不同物理环境位置的多个用户或多个虚拟环境通过网络相联结,或者多个用户同时参加一个虚拟现实环境,通过计算机与其他用户进行交互,并共享信息。在分布式虚拟现实系统中,多个用户可通过网络对同一虚拟世界进行观察和操作,以达到协同工作的目的。

6.2 声音

6.2.1 基本概念

1.声音信号

声音是通过空气传播的一种连续的波,称为声波。声波在时间和幅度上都是连续的模拟信号,通常称为模拟声音(音频)信号。

1)声音的感觉

人们对声音的感觉主要有音量、音调和音色三个指标。

(1)音量(也称响度)。声音的强弱程度,取决于声音波形的幅度,即取决于振幅的大小和强弱。

(2)音调。人对声音频率的感觉表现为音调的高低,取决于声波的基频。基频越低,给人的感觉越低沉,频率高则声音尖锐。

(3)音色。由混入基音(基波)的泛音(谐波)所决定,每种声音又都有其固定的频率和不同音强的泛音,从而使得它们具有特殊的音色效果。人们能够分辨具有相同音高的钢琴和小号声音,就是因为它们具有不同的音色。一个声波上的谐波越丰富,音色越好。

声音信号由许多频率不同的信号组成,人耳能听到的音频信号(audio)的频率范围是20~20kHz。可听声包括如下种类。

● 话音(也称语音)。人的说话声,频率范围通常为300~3400Hz。

● 音乐。由乐器演奏形成(规范的符号化声音),其带宽可达到20~20kHz。

● 其他声音。如风声、雨声、鸟叫声和汽车鸣笛声等,它们起着效果声或噪声的作用,其带宽范围也是20~20kHz。

声音信号的两个基本参数是幅度和频率。幅度是指声波的振幅,通常用动态范围表示,一般用分贝(dB)为单位来计量。频率是指声波每秒钟变化的次数,用Hz表示。人们把频率小于20Hz的声波信号称为亚音信号(也称次音信号);频率范围为20Hz~20kHz的声波信号称为音频信号;高于20kHz的信号称为超音频信号(也称超声波)。

2)声音信号的数字化

声音信号是一种模拟信号,计算机要对它进行处理,必须将它转换成为数字声音信号,即用二进制数字的编码形式来表示声音。最基本的声音信号数字化方法是取样-量化法,它分成如下三个步骤。

(1)采样。采样是把时间连续的模拟信号转换成时间离散、幅度连续的信号。在某些特定的时刻获取声音信号幅值叫做采样,由这些特定时刻采样得到的信号称为离散时间信号。一般都是每隔相等的一小段时间采样一次,为了不产生失真,采样频率不应低于声音信号最高频率的两倍。因此,语音信号的采样频率一般为8kHz,音乐信号的采样频率则应在40kHz以上。采样频率越高,可恢复的声音信号分量越丰富,其声音的保真度越好。

(2)量化。量化处理是把在幅度上连续取值(模拟量)的每一个样本转换为离散值(数字量)表示,因此量化过程有时也称为A/D转换(模数转换)。量化后的样本是用二进制数来表示的,二进制数位数的多少反映了度量声音波形幅度的精度,称为量化精度,也称为量化分辨率。例如,每个声音样本若用16位(2字节)表示,则声音样本的取值范围是0~65536,精度是1/65536;若只用8位(1字节)表示,则样本的取值范围是0~255,精度是1/256。量化精度越高,声音的质量越好,需要的存储空间也越多;量化精度越低,声音的质量越差,而需要的存储空间越少。

(3)编码。经过采样和量化处理后的声音信号已经是数字形式了,但为了便于计算机的存储、处理和传输,还必须按照一定的要求进行数据压缩和编码,即选择某一种或者几种方法对它进行数据压缩,以减少数据量,再按照某种规定的格式将数据组织成为文件。

经过数字化处理之后的数字声音的主要参数如表6-1所示。

表6-1 数字化处理之后的数字声音的主要参数

2.波形声音

波形声音信息是一个用来表示声音振幅的数据序列,它是通过对模拟声音按一定间隔采样获得的幅度值,再经过量化和编码后得到的便于计算机存储和处理的数据格式。声音信号数字化后,其数据传输率(每秒位数)与信号在计算机中的实时传输有直接关系,而其总数据量又与计算机的存储空间有直接关系。未经压缩的数字音频数据传输率可按下式计算:

其中,数据传输率以每秒位(b/s)为单位;采样频率以Hz为单位;量化以位(b)为单位。

波形声音经过数字化后所需占用的存储空间可用如下公式计算:

【例6.1】若语音信号的带宽通常为300~3400Hz,量化精度为8位,单声道输出,计算每秒钟及每小时的数据量。

解:据题意,数字化时的取样频率为8kHz,根据上述公式每秒钟的数据量为:

1小时数字语音的数据量大约是28MB。

【例6.2】若CD(Compact Disc,高密盘)盘片上所存储的立体声高保真数字音乐的带宽为20~20000Hz,采样频率为44.1kHz,量化精度为16位,双声道,计算1小时的数据量。

解:每秒钟的数据量为1411.2kb/s(176.4KB/s),1小时的数据量大约是635MB。

可见,数字波形声音数据量非常大,因此在编码的时候常常要采用压缩的方式来压缩数字数据以减少存储空间和提高传输效率(降低传输带宽)。根据统计分析结果,语音信号中包含有大量的冗余信息,再加上还可以利用人的听觉感知特性,因此,产生了许多能满足实际应用需求的压缩算法。一个好的数据压缩算法通常应能满足下列需求。

(1)压缩倍数高,压缩后的数据率低。

(2)解码后的信号失真小,质量高。

(3)算法简单,执行速度快,延迟时间短。

(4)编码器/解码器的成本低。

3.数字语音压缩方法

数字语音的数据压缩方法很多,从原理上可分为如下三类。

(1)波形编码。这是一种直接对取样、量化后的波形进行压缩处理的方法。例如,脉冲编码调制(PCM)、自适应差分脉冲编码(ADPCM)和子带编码(SBC)等。波形编码的特点是通用性强,不仅适应于数字语音的压缩,而且对所有使用波形表示的数字声音都有效;可获得高质量的语音,但很难达到很高的压缩比。

(2)参数编码(也称为模型编码)。这是一种基于声音生成模型的压缩方法(Production Model-Based Compression),从语音波形信号中提取生成的话音参数,使用这些参数通过话音生成模型重构出话音。例如,线性预测编码(LPC)和声码器(vocoder)等。它的优点是能达到很高的压缩比。缺点是信号源必须已知,受声音生成模型的限制,质量还不理想。

(3)混合编码。波形编码虽然可提供高质量的语音,但数据率比较高,很难低于16kb/s;参数编码的数据率虽然可降低到3kb/s甚至更低,但它的音质根本不能与波形编码相比。混合编码是上述两种方法的结合,它既能达到高的压缩比,又能保证一定的质量,但算法相对复杂一些。例如,码激励线性预测(CELP)和混合激励线性预测(MELP)等。

基于波形的压缩编码方法虽然数据率比较高,但能保证高质量地重建语音,且算法简单、易实现,能较好地保持原有声音的特点,便于编辑处理,在多媒体计算机和多媒体文档中有广泛的应用。

数字语音压缩编码有多种国际标准,如G.711、G.721、G.726、G.727、G.722、G.728、G.729A、G.723.1和IS96(CDMA)等。

数字语音由于频带比较窄,又可以通过语音生成模型进行比较好的模拟,因此经过压缩编码后码率比较低,存储与传输问题不大。而对于有高保真度要求的全频带声音,由于其带宽达到20kHz以上,又有双声道甚至多声道的要求,数据量相当可观,对压缩编码的要求更高。全频带声音的压缩编码方法与数字语音的处理方法不同,它不但依据波形本身的相关性,而且还利用人的听觉系统特性来达到压缩声音的目的,这种压缩编码称为感知声音编码(Perceptual Audio Coding)。在国际标准MPEG中,先后为视频图像伴音的数字宽带声音制定了MPEG-1 Audio、MPEG-2 Audio、MPEG-2AAC和MPEG-4 Audio等多种数据压缩编码的标准。MPEG处理的是10~20000Hz频率范围的声音信号,数据压缩的主要依据是人耳的听觉特性,特别是人耳存在着随声音频率变化的听觉域,以及人耳的听觉掩蔽特性。

4.声音合成

个人计算机和多媒体系统中的声音,除了数字波形声音之外,还有一类是使用符号表示的,由计算机合成的声音,包括语音合成和音乐合成。

1)语音合成

语音合成目前主要指从文本到语音的合成,也称为文语转换。采用文语转换的方法输出语音,应预先建立语音参数数据库、发音规则库等。需要输出语音时,系统按需求先合成语音单元,再按语音学规则或语言学规则连接成自然的语流。文语转换的参数数据库不随发音时间增长而加大,但规则库却随语音质量的要求而增大。语音合成有多方面的应用,例如,海量查询与声讯服务、航班动态查询、电话报税、有声E-mail等,这些业务都需要以准确、清晰的语音通过电话进行操作提示并提供查询结果。一般来说,对合成的语音要求能够做到可听懂、自然、延迟时间短、速度可控制等。

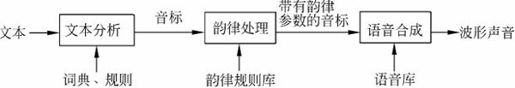

文语转换原理上一般分成两步,第一步先将文字序列转换成音韵序列,第二步再由语音合成器生成语音波形(如图6-1所示)。其中第一步涉及语言学处理,例如分词、字音转换等,以及一整套有效的韵律控制规则;第二步需要使用语音合成技术,能按要求实时合成出高质量的语音流。

图6-1 文语转换过程示意

从合成采用的技术来说,语音合成可分为发音参数合成、声道模型参数合成和波形编辑合成。

(1)发音参数合成。这种方法对人的发音过程进行直接模拟,它定义了唇、舌、声带的相关参数,如开口度、舌高度、舌位置和声带张力等。由这些发音参数估计声道截面积函数,进而计算声波。但由于人发音生理过程复杂,理论计算与物理模拟之间的差异,合成语音的质量目前还不理想。

(2)声道模型参数合成。这种方法基于声道截面积函数或声道谐振特性合成语音,如共振峰合成器、LPC合成器。这类合成器的比特率低,音质适中。为改善音质,发展了混合编码技术,主要手段是改善激励,如码本激励、多脉冲激励和长时预测规则码激励等。这样比特率有所增大,同时音质得到提高。

(3)波形编辑合成。波形编辑合成技术是直接把语音波形数据库中的波形相互拼接在一起,输出连续语流。这种语音合成技术用原始语音波形代替参数,而且这些语音波形取自自然语言的词或句子,它隐含了声调、重音、发音速度的影响,合成的语言清晰自然。其质量普遍高于参数合成。

2)音乐合成

音乐是用乐谱进行描述,由乐器演奏而成的。乐谱的基本组成单元是音符(notes),最基本的音符有7个,所有不同音调的音符少于128个。

音符代表的是音乐,音乐与噪声的区别主要在于它们是否有周期性。音乐的波形随着时间作周期性变化,噪声则不然。音乐的要素有音调、音色、响度和持续时间。音调指声波的基频,基频低,声音低沉;基频高,声音高昂。不同乐器有不同的音色,音色是由声音的频谱决定的。响度即声音的强度。一首乐曲中每一个乐音的持续时间是变化的,从而形成旋律。音乐可以使用电子学原理合成出来(生成相应的波形),各种乐器的音色也可以进行模拟。

5.MIDI

MIDI(Musical Instrument Digital Interface,乐器数字接口),泛指数字音乐的国际标准。MIDI标准规定了电子乐器与计算机之间连接的电缆硬件以及电子乐器之间、乐器与计算机之间传送数据的通信协议的规范;规定了音乐的数字表示,包含音符、定时和乐器指派等规范。由于MIDI标准定义了计算机音乐程序、合成器及其他电子设备交换信息和电子信号的方式,所以可以解决不同电子乐器之间不兼容的问题。

MIDI设备是指符合MIDI规范的设备。通过MIDI接口,不同MIDI设备之间可进行信息交换。带有MIDI接口以及专用的MIDI电缆计算机、合成器和其他MIDI设备连接在一起,即可构成计算机音乐系统。数据由MIDI设备的键盘产生,可通过声音合成器还原为声音。通过计算机可以控制乐器的输出,并能接收、存储和处理经过编码的音乐数据。

MIDI文件是指计算机中用于存储和交换MIDI消息的一种数据文件,它由一系列的MIDI消息组成。它不仅包含着与音乐演奏有关的消息,如音符、速度和表情等,而且还包含了大量与音响有关的控制信息,如声像、效果和均衡等。MIDI文件中包含了多达16个通道的演奏定义,包括每个通道的演奏音符信息,如键、音长、音量和力度(击键时,键达到最低位置的速度)等。标准MIDI文件格式采用的文件扩展名为.mid,它是音序软件的文件交换标准,也是商业音乐作品发行的标准。

MIDI音乐与高保真的波形声音相比,虽然在音质方面还有一些差距,也无法合成出所有各种不同的声音(如语音),且生成的音乐质量与使用的音源硬件有关,但它的数据量极少(比CD-DA少3个数量级,比MP3少2个数量级),又易于编辑修改,还可以与波形声音同时播放。

6.2.2 声音文件格式

数字声音在计算机中存储和处理时,其数据必须以文件的形式进行组织,所选用的文件格式必须得到操作系统和应用软件的支持。如同文本文件一样,在因特网上和各种不同计算机以及应用软件中使用的声音文件格式也互不相同。下面通过声音文件的特征后缀名来逐一介绍。

(1)Wave文件(.WAV)。Microsoft公司的音频文件格式,它来源于对声音模拟波形的采样。用不同的采样频率对声音的模拟波形进行采样可以得到一系列离散的采样点,以不同的量化位数(8位或16位)把这些采样点的值转换成二进制数,然后存入磁盘,这就产生了声音的WAV文件,即波形文件。利用该格式记录的声音文件能够和原声基本一致,质量非常高,但文件数据量大。

(2)Module文件(.MOD)。该格式的文件里存放乐谱和乐曲使用的各种音色样本,具有回放效果明确,音色种类无限等优点。

(3)MPEG文件(.MP3)。现在最流行的声音文件格式,因其压缩率大,在网络可视电话通信方面应用广泛,但和CD唱片相比,音质不能令人非常满意。

(4)RealAudio文件(.RA)。这种格式具有强大的压缩量和极小的失真,它也是为了解决网络传输带宽资源而设计的,因此主要目标是压缩比和容错性,其次才是音质。

(5)MIDI文件(.MID/.RMI)。它是目前较成熟的音乐格式,实际上已经成为一种产业标准,其科学性、兼容性和复杂程度等各方面当然远远超过本文前面介绍的所有标准(除交响乐CD、Unplug CD外,其他CD往往都是利用MIDI制作出来的),General MIDI就是最常见的通行标准。作为音乐工业的数据通信标准,MIDI能指挥各音乐设备的运转,而且具有统一的标准格式,能够模仿原始乐器的各种演奏技巧甚至无法演奏的效果,而且文件的长度非常小。.RMI可以包括图片标记和文本。

(6)Voice文件(.VOC)。Creative公司波形音频文件格式,也是声霸卡(sound blaster)使用的音频文件格式。每个VOC文件由文件头块(header block)和音频数据块(data block)组成。文件头包含一个标识版本号和一个指向数据块起始的指针。数据块分成各种类型的子块。

(7)Sound文件(.SND)。Sound文件是NeXT Computer公司推出的数字声音文件格式,支持压缩。

(8)Audio文件(.AU)。Sun Microsystems公司推出的一种经过压缩的数字声音文件格式,是因特网上常用的声音文件格式。

(9)AIFF文件(.AIF)。Apple计算机的音频文件格式。Windows的Convert工具可以把AIF格式的文件换成Microsoft的WAV格式的文件。

(10)CMF文件(.CMF)。Creative公司的专用音乐格式,与MIDI差不多,音色、效果上有些特色,专用于FM声卡,但其兼容性也很差。

6.3 图形和图像

6.3.1 基础知识

1.基本概念

彩色是创建图像的基础,在计算机上使用彩色没有什么特殊之处,只不过是它有一套特定的记录和处理彩色的技术。因此,要理解图像处理软件中所出现的各种有关彩色的术语,首先要具备基本的彩色理论知识。

彩色是通过光被人们感知的,物体由于内部物质的不同,受光线照射后,产生光的分解现象,一部分光线被吸收,其余的被反射或投射出来,成为人们所见的物体的彩色。所以,彩色和光有密切关系,同时还与被光照射的物体有关,并与观察者有关。

1)色彩三要素

彩色光作用于人眼,使之产生彩色视觉。为了能确切地表示某一彩色光的度量,可以用亮度、色调和色饱和度三个物理量来描述,并称之为色彩三要素。

(1)亮度。亮度是描述光作用于人眼时引起的明暗程度感觉,是指彩色明暗深浅程度。一般来说,对于发光物体,彩色光辐射的功率越大,亮度越高;反之,亮度越低。对于不发光的物体,其亮度取决于吸收或者反射光功率的大小。

(2)色调。色调是指颜色的类别,如红色、绿色、蓝色等不同颜色就是指色调。由光谱分析可知,不同波长的光呈现不同的颜色,人眼看到一种或多种波长的光时所产生的彩色感觉,反映出颜色的类别。某一物体的色调取决于它本身辐射的光谱成分或在光的照射下所反射的光谱成分对人眼刺激的视觉反应。

(3)色饱和度。色饱和度是指某一颜色的深浅程度(或浓度)。对于同一种色调的颜色,其饱和度越高,则颜色越深,如深红、深绿和深蓝等;其饱和度越低,则颜色越淡,如淡红、淡绿和淡黄等。高饱和度的深色光可掺入白色光被冲淡,降为低饱和度的淡色光。因此,色饱和度可认为是某色调的纯色掺入白色光的比例。

2)三基色原理

从理论上讲,任何一种颜色都可以用三种基本颜色按不同比例混合得到。自然界常见的各种颜色光,都可由红(Red)、绿(Green)、蓝(Blue)三种颜色光按不同比例相配而成。同样,绝大多数颜色光也可以分解成红、绿、蓝三种颜色光,这就是色度学中最基本的三基色原理。当然,三基色的选择不是唯一的,可以选择其他三种颜色为三基色。但是,三种颜色必须是相互独立的,即任何一种颜色都不能由其他两种颜色合成。由于人眼对红、绿、蓝这三种颜色光最敏感,因此由这三种颜色相配所得的彩色范围也最广,所以一般都选这三种颜色作为基色。把三种基色光按不同比例相加称之为相加混色,由红、绿、蓝三基色进行相加混色的情况如下。

红色+绿色=黄色

红色+蓝色=品红

绿色+蓝色=青色

红色+绿色+蓝色=白色

红色+青色=绿色+品红=蓝色+黄色=白色

凡是两种色光混合而成白光,则这两种色光互为补色。

3)彩色空间

彩色空间是指彩色图像所使用的颜色描述方法,也称为彩色模型。在PC和多媒体系统中,表示图形和图像的颜色常常涉及不同的彩色空间,如RGB彩色空间、CMY彩色空间和YUV彩色空间等。不同的彩色空间对应不同的应用场合,各有其特点。因此,数字图像的生成、存储、处理及显示时对应不同的彩色空间。从理论上讲,任何一种颜色都可以在上述彩色空间中精确地进行描述。

(1)RGB彩色空间。计算机中的彩色图像一般都用R、G、B分量表示,彩色显示器通过发射出三种不同强度的电子束,使屏幕内侧覆盖的红、绿、蓝荧光材料发光而产生色彩。这种彩色的表示方法称为RGB彩色空间表示法。通过三个分量的不同比例,在显示屏幕可合成任意所需要的颜色。

(2)CMY彩色空间。RGB彩色空间中,不同颜色的光是通过相加混合实现的,而彩色打印的纸张是不能发射光线的,因而彩色打印机就不能采用RGB颜色来打印,它只能使用能够吸收特定的光波而反射其他光波的油墨或颜料来实现。用油墨或颜料进行混合得到的彩色称为相减混色。之所以称为相减混色,是因为减少(吸收)了人眼识别颜色所需要的反射光。根据三基色原理,油墨或颜料的三基色是青(cyan)、品红(magenta)和黄(yellow)。可以用这三种颜色的油墨或颜料按不同比例混合成任何一种由油墨或颜料表现的颜色,这种彩色表示方法称为CMY彩色空间。

(3)YUV彩色空间。在现代彩色电视系统中,通常采用三管彩色摄像机或彩色CCD摄像机,它把摄得的彩色图像信号,经过分色、放大和校正得到R、G、B三基色,再经过矩阵变换得到亮度信号Y、色差信号U(R-Y)和V(B-Y),最后发送端将这三个信号分别进行编码,用同一信道发送出去。这就是常用的YUV彩色空间。电视图像一般都是采用Y、U、V分量表示,即一个亮度分量(Y)和两个色差(U和V)分量表示。由于亮度和色度是分离的,解决了彩色和黑白显示系统的兼容问题,如果只有Y分量而没有U、V分量,那么所表示的图像是黑白灰度图像。

2.计算机中的图形数据表示

在计算机中的图形数据有两种常用的表示形式,一种称为几何图形或矢量图形,简称图形;另一种称为点阵图像或位图图像。

(1)矢量图形。矢量图形是用一系列计算机指令来描述和记录的一幅图的内容,即通过指令描述构成一幅图的所有直线、曲线、圆、圆弧、矩形等图元的位置、维数和形状,也可以用更为复杂的形式表示图像中的曲面、光照、材质等效果。矢量图法实质上是用数学的方式(算法和特征)来描述一幅图形图像,在处理图形图像时根据图元对应的数学表达式进行编辑和处理。在屏幕上显示一幅图形图像时,首先要解释这些指令,然后将描述图形图像的指令转换成屏幕上显示的形状和颜色。编辑矢量图的软件通常称为绘图软件,如适于绘制机械图、电路图的AutoCAD软件等。

(2)位图图像。位图图像是指用像素点来描述的图。图像一般是用摄像机或扫描仪等输入设备捕捉实际场景画面,离散化为空间、亮度、颜色(灰度)的序列值,即把一幅彩色图或灰度图分成许许多多的像素(点),每个像素用若干二进制位来指定该像素的颜色、亮度和属性。位图图像在计算机内存中由一组二进制位组成,这些位定义图像中每个像素点的颜色和亮度。屏幕上一个点也称为一个像素,显示一幅图像时,屏幕上的一个像素也就对应于图像中的某一个点。根据组成图像的像素密度和表示颜色、亮度级别的数目,又可将图像分为二值图(黑白图)和彩色图两大类,彩色图还可以分为真彩色图、伪彩色图等。图像适合于表现比较细腻,层次较多,色彩较丰富,包含大量细节的图像,并可直接、快速地在屏幕上显示出来。

3.图像的获取

将现实世界的景物或物理介质上的图文输入计算机的过程称为图像的获取(capturing)。在多媒体应用中的基本图像可通过不同的方式获得,一般来说,可以直接利用数字图像库的图像;可以利用绘图软件创建图像;可以利用数字转换设备采集图像。

1)利用数字图像库

在CD-ROM光盘和因特网上的图像库中,图像的内容较丰富,图像尺寸和图像深度可选的范围也较广。而且图像的质量完全可以满足一般用户的要求,但图像的内容也许不具备用户的创意设计。用户可根据需要选择已有的图像,或再做进一步的编辑和处理。

2)利用绘图软件创建图像

目前Windows环境的大部分图像编辑软件都具有一定的绘图功能。这些软件大多具有较强的功能和很好的图形用户接口,还可以利用鼠标、画笔及画板来绘制各种图形,并进行彩色、纹理、图案等的填充和加工处理。对于一些小型的图形、图标、按钮等,直接制作很方便,但这不足以描述自然景物和人像。也有一些较专业的绘画软件,通过数字化画板和画笔在屏幕上绘画。这种软件要求绘画者具有一定的美术知识及创意基础。

3)利用数字转换设备采集图像

数字转换设备可以把采集到的图像转换成计算机能够记录和处理的数字图像数据。例如,对印刷品、照片或照相底片等进行扫描,用数字相机或数字摄像机对选定的景物进行拍摄等。从现实世界中获取数字图像所使用的设备通称为图像获取设备。一幅彩色图像可以看做二维连续函数f(x,y),其彩色f是坐标(x,y)的函数,从二维连续函数到离散的矩阵表示,同样包含采样、量化和编码的数字化过程。数字转换设备获取图像的过程实质上是信号扫描和数字化的过程,它的处理步骤大体分为如下三步。

(1)采样。在x,y坐标上对图像进行采样(也称为扫描),类似于声音信号在时间轴上的采样要确定采样频率一样,在图像信号坐标轴上的采样也要确定一个采样间隔,这个间隔即为图像分辨率。有了采样间隔,就可以逐行对原始图像进行扫描。首先设y坐标不变,对x轴按采样间隔得到一行离散的像素点xn及相应的像素值。使y坐标也按采样间隔由小到大变化,就可以得到一个离散的像素矩阵[xn,yn],每个像素点有一个对应的色彩值。简单地说,将一幅画面划分为M×N个网格,每个网格称为一个取样点,用其亮度值来表示。这样,一幅连续的图像就转换为以取样点值组成的一个阵列(矩阵)。

(2)量化。将扫描得到的离散的像素点对应的连续色彩值进行A/D转换(量化),量化的等级参数即为图像深度。这样,像素矩阵中的每个点(xn,yn)都有对应的离散像素值fn。

(3)编码。把离散的像素矩阵按一定方式编成二进制码组。最后,把得到的图像数据按某种图像格式记录在图像文件中。

4.图像的属性

描述一幅图像需要使用图像的属性。图像的属性包含分辨率、像素深度、真/伪彩色、图像的表示法和种类等。

1)分辨率

经常遇到的分辨率有两种,即显示分辨率和图像分辨率。图像分辨率与显示分辨率是两个不同的概念,图像分辨率确定的是组成一幅图像的像素数目,而显示分辨率确定的是显示图像的区域大小。它们之间的关系为:图像分辨率大于显示分辨率时,在屏幕上只能显示部分图像;图像分辨率小于显示分辨率时,图像只占屏幕的一部分。

(1)显示分辨率。显示分辨率是指显示屏上能够显示出的像素数目。例如,显示分辨率为1024×768表示显示屏分成768行(垂直分辨率),每行(水平分辨率)显示1024个像素,整个显示屏就含有796432个显像点。屏幕能够显示的像素越多,说明显示设备的分辨率越高,显示的图像质量越高。

(2)图像分辨率。图像分辨率是指组成一幅图像的像素密度,也是用水平和垂直的像素表示,即用每英寸多少点(dpi)表示数字化图像的大小。例如,用200dpi来扫描一幅2×2.5英寸的彩色照片,那么得到一幅400×500个像素点的图像。它实质上是图像数字化的采样间隔,由它确立组成一幅图像的像素数目。对同样大小的一幅图,如果组成该图的图像像素数目越多,则说明图像的分辨率越高,图像看起来就越逼真;相反,图像显得越粗糙。因此,不同的分辨率会造成不同的图像清晰度。

2)图像深度

图像深度是指存储每个像素所用的位数,它也是用来度量图像的色彩分辨率的。像素深度确定彩色图像的每个像素可能有的颜色数,或者确定灰度图像的每个像素可能有的灰度级数。它决定了彩色图像中可出现的最多颜色数,或灰度图像中的最大灰度等级。如一幅图像的图像深度为b位,则该图像的最多颜色数或灰度级为2b种。显然,表示一个像素颜色的位数越多,它能表达的颜色数或灰度级就越多。例如,只有1个分量的单色图像,若每个像素有8位,则最大灰度数目为28=256。一幅彩色图像的每个像素用R、G、B三个分量表示,若三个分量的像素位数分别为4,4,2,则最大颜色数目为24+4+2=210=1024,就是说像素的深度为10位,每个像素可以是210种颜色中的一种。表示一个像素的位数越多,它能表达的颜色数目就越多,它的深度就越深。

3)真彩色和伪彩色

真彩色(true color)是指组成一幅彩色图像的每个像素值中,有R、G、B三个基色分量,每个基色分量直接决定显示设备的基色强度,这样产生的彩色称为真彩色。例如,用RGB8∶8∶8方式表示一幅彩色图像,也就是R、G、B分量都用8位来表示,可生成的颜色数就是224种,每个像素的颜色就是由其中的数值直接决定的。这样得到的色彩可以反映原图像的真实色彩,一般认为是真彩色。通常,在一些场合把RGB8∶8∶8方式表示的彩色图像称为真彩色图像或全彩色图像。

为了减少彩色图形的存储空间,在生成图像时,对图像中不同色彩进行采样,产生包含各种颜色的颜色表,即彩色查找表。图像中每个像素的颜色不是由三个基色分量的数值直接表达,而是把像素值作为地址索引在彩色查找表中查找这个像素实际的R、G、B分量,将图像的这种颜色表达方式称为伪彩色。需要说明的是,对于这种伪彩色图像的数据除了保存代表像素颜色的索引数据外,还要保存一个色彩查找表(调色板)。彩色查找表可以是一个预先定义的表,也可以是对图像进行优化后产生的色彩表。常用的256色的彩色图像使用了8位的索引,即每个像素占用一个字节。

5.图形图像转换

图形和图像之间在一定的条件下可以转换,如采用光栅化(点阵化)技术可以将图形转换成图像;采用图形跟踪技术可以将图像转换成图形。一般可以通过硬件(输入输出设备)或软件实现图形和图像之间的转换。

(1)图形和图像的硬件转换。一张工程图纸,一般认为它是图形,其实在它被输入计算机以前还不能称为图形或图像,当将它用扫描仪输入到Photoshop,它就变成图像信息(点位图);当用数字化仪将它输入到AutoCAD后,它就变成图形信息(矢量图)。也就是说,同一个对象既可以被作为图形处理,也可以作为图像处理。那么到底哪种过程更有效?要看被处理的对象性质和要达到的处理结果。当然,可以先将它用扫描仪扫进计算机,变成图像信息,再用一定的软件(如Corel-Trace,Photoshop的轮廓跟踪)人工或自动地勾勒出它的轮廓,这个过程称为向量化,也就是图像转换为图形的过程。这个过程必然会丢失许多细节,所以通常适用于工程绘图领域。

(2)图形和图像的软件转换。图形和图像都是以文件的形式存放在计算机存储器中,可以通过应用软件实现文件格式之间的转换,达到图形和图像之间的转换。随着图形和图像处理技术的发展,出现了很多较好的格式转换软件,如CorelDraw软件,它几乎提供所有文件格式之间的转换。转换并不表示可以任意互换,实际上许多转换是不可逆的,转换的次数越多,丢失的信息就越多,特别是图形和图像之间的转化。例如,当将一个BMP格式文件转化为GIF、TIFF等格式时问题还不大,但如果将它转化为DIF等格式时就丢失了许多细节,甚至像一个矩形中间的填充色块,都用几条线表示。

6.图像的压缩编码

扫描生成一幅图像时,实际上就是按一定的图像分辨率和一定的图像深度对模拟图片或照片进行采样,从而生成一幅数字化的图像。图像的图像分辨率越高,图像深度越深,则数字化后的图像效果越逼真,图像数据量越大。如果按照像素点及其深度映射的图像数据大小采样,可用下面的公式估算数据量:

图像数据量=图像的总像素×图像深度/8(B)

其中,图像的总像素为图像的水平方向像素乘以垂直方向像素数。

例如,一幅640×480的256色图像,其文件大小约为:

可见,数字图像的数据量也很大,需要很大的存储空间存储数据图像。更重要的是,在现代通信中,特别是因特网上开展的各种应用中,图像传输速度是一项很重要的指标。以使用拨号接入因特网的家庭用户为例,假设数据传输速度为56kb/s,则理想情况下,传输一幅分辨率为640×480的6.5万色的未经压缩的图像大约需要1~2分钟。因此,采用压缩编码技术,减少图像的数据量是提高网络传输速度的重要手段。

数据压缩可分成两类:有损压缩和无损压缩。

(1)有损压缩。有损压缩方法利用人眼视觉对图像中的某些频率成分不敏感的特性,采用一些高效的有限失真数据压缩算法,允许压缩过程中损失一定的信息。采用有损压缩后的数据进行图像重建时,重建后的图像与原始图像虽有一定的误差,但并不影响人们对图像含义的正确理解。而且换来了较大的压缩比,大幅度减少了图像信息中的冗余信息。

(2)无损压缩。无损压缩利用数据的统计冗余进行压缩,可以保证在数据压缩和还原过程中,图像信息没有损耗或失真,图像还原(解压缩)时可完全恢复,即重建后的图像与原始图像完全相同。例如,在多媒体应用中常用行程长度编码、增量调制编码和霍夫曼编码等。

①行程长度编码(Run-Length Encoding, RLE)。某些图像往往有许多颜色相同的图块。在这些图块中,许多连续的扫描行都具有同一种颜色,或者同一扫描行上有许多连续的像素都具有相同的颜色值。在这些情况下就可以不需要存储每一个像素的颜色值,而仅仅存储一个像素值以及具有相同颜色的像素数目。这种编码称为行程编码。具有同一颜色的连续像素的数目称为行程长度。其压缩率的大小取决于图像本身。如果图像中具有相同颜色的横向色块越大,这样的图像块数目越多,压缩比就越大;反之就越小。

②增量调制编码(delta modulation encoding, DM)。自然图像往往有在比较大的范围内,图像的颜色虽不完全一致,但变化不大的特点。因此,在这些区域中,相邻像素的像素值相差很小,具有很大的相关性。在一幅图像中,除了轮廓特别明显的地方以外,大部分区域都具有这种特点。增量调制编码就利用图像相邻像素值的相关性来压缩每个像素值的位数,以达到减少存储容量的目的。增量调制编码压缩图像时,不存储扫描行上每个像素的实际值,仅存储每一行上第一个像素的实际值。其后,依次存储每一个像素的像素值与前一个像素值之差,即增量值。

③霍夫曼(Huffman)编码。大多数图像常常包含单色的大面积图块,而且某些颜色比其他颜色出现的更频繁,因此可以采用霍夫曼编码方式。霍夫曼编码的基本方法是先对图像数据扫描一遍,计算出各种像素出现的概率,按概率的大小指定不同长度的唯一码字,由此得到一张该图像的霍夫曼码表。编码后的图像数据记录的是每个像素的码字,而码字与实际像素值的对应关系记录在码表中。码表是附在图像文件中的。实际应用中,霍夫曼编码常与其他编码方法结合使用,以获得更大的压缩比。

7.多媒体数据压缩编码的国际标准

计算机中使用的图像压缩编码方法有多种国际标准和工业标准。目前使用相当广泛的编码及压缩标准有JPEG、MPEG和H.261。

(1)JPEG(Joint Photographic Experts Group)。JPEG是一个由ISO和IEC两个组织机构联合组成的专家组,负责制定静态和数字图像数据压缩编码标准,这个专家组地区性的算法称为JPEG算法,并且成为国际上通用的标准,因此又称为JPEG标准。JPEG是一个适用范围很广的静态图像数据压缩标准,既可用于灰度图像又可用于彩色图像。JPEG专家组开发了两种基本的压缩算法,一种是以离散余弦变换(Discrete Cosine Transrorm, DCT)为基础的有损压缩算法,另一种是采用以预测技术为基础的无损压缩算法。使用有损压缩算法时,在压缩比为25∶1的情况下,压缩后还原得到的图像与原始图像相比较,人们难于察觉它们之间的区别,因此得到了广泛的应用。例如,在V-CD和DVD-Video电视图像压缩技术中,就使用JPEG的有损压缩算法来取消同方向上的冗余数据。为了在保证图像质量的前提下进一步提高压缩比,JPEG专家组制定了ISO/IEC 15444 JPEG2000(简称JP2000)标准,这个标准中采用了小波变换(Wavelet)算法。

(2)MPEG(Moving Pictures Experts Group)。MPEG动态图像压缩标准是一个由ISO和IEC两个组织机构联合组成的活动图像专家组,于1990年形成了一个标准草案,将MPEG标准分成两个阶段:第一阶段(MPEG-1)是针对传输率为1~1.5Mb/s的普通电视质量的视频信号的压缩;第二阶段(MPEG-2)的目标则是对每秒30帧的720×572分辨率的视频信号进行压缩。在扩展模式下,MPEG-2可以对分辨率达1440×1152的高清晰度电视(HDTV)的信号进行压缩。MPEG标准分成MPEG视频、MPEG音频和视频音频同步三个部分。1999年发布了MPEG-4多媒体应用标准,目前推出了MPEG-7多媒体内容描述接口标准等。每个新标准的产生都极大地推动了数字视频的发展和更广泛的应用。

(3)H.261。H.261视频通信编码标准是由国际电话电报咨询委员会于1998年提出的电话/会议电视的建议标准,该标准又称为P×64K标准,其中P是取值为1~30的可变参数;P=1或2时支持1/4通用中间格式(Quarter Common Intermediate Format, QCIF)的帧率较低的视频电话传输;P≤6时支持通向中间格式(Common Intermediate Format, CIF)的帧率较高的电视会议数据传输。P×64K视频压缩算法也是一种混合编码方案,即基于DCT的变换编码和带有运动预测差分脉冲编码调制(DPCM)的预测编码方法的混合。在低传输率时(P=1或P=2,即64kb/s或128kb/s),除QCIF外还可以使用亚帧技术,即每间隔一帧(或数帧)处理一帧,压缩比例可达50∶1左右。CCITT推出的H.263标准用于低位速率通信的电视图像编码。

6.3.2 图形、图像文件格式

数字图像在计算机中存储时,其文件格式繁多,下面简单介绍几种常用的文件格式。

(1)BMP文件(.BMP)。Windows操作系统采用的图像文件格式,在Windows环境下运行的所有图像处理软件几乎都支持BMP图像文件格式。它是一种与设备无关的位图格式,目的是为了让Windows能够在任何类型的显示设备上输出所存储的图像。BMP采用位映射存储格式,除了图像深度可选以外,一般不采用其他任何压缩,所以占用的存储空间较大。BMP文件的图像深度可选1位、4位、8位及24位,即有黑白、16色、256色和真彩色之分。

(2)GIF文件(.GIF)。CompuServe公司开发的图像文件格式,它以数据块为单位来存储图像的相关信息。GIF文件格式采用了LZW(Lempel-Ziv Welch)无损压缩算法按扫描行压缩图像数据。它可以在一个文件中存放多幅彩色图像,每一幅图像都由一个图像描述符、可选的局部彩色表和图像数据组成。如果把存储于一个文件中的多幅图像逐幅读出来显示到屏幕上,可以像播放幻灯片那样显示或者构成简单的动画效果。GIF的图像深度为1~8位,即最多支持256种色彩的图像。

GIF文件格式定义了两种数据存储方式,一种是按行连续存储,存储顺序与显示器的显示顺序相同;另一种是按交叉方式存储,由于显示图像需要较长的时间,使用这种方法存放图像数据,用户可以在图像数据全部收到之前浏览这幅图像的全貌,而不觉得等待时间太长。目前,GIF文件格式在HTML文档中得到广泛使用。

(3)TIFF文件(.TIF)。由Aldus和Microsoft公司为扫描仪和桌面出版系统研制开发的一种通用的图像文件格式。TIFF是电子出版CD-ROM中的一个重要的图像文件格式。TIFF格式非常灵活易变,它又定义了4类不同的格式:TIFF-B适用于二值图像;TIFF-G适用于黑白灰度图像;TIFF-P适用于带调色板的彩色图像;TIFF-R适用于RGB真彩图像。无论在视觉上还是其他方面,都能把任何图像编码成二进制形式而不丢失任何属性。

(4)PCX文件(.PCX)。PC Paintbrush(PC画笔)的图像文件格式。PCX的图像深度可选为1位、4位、8位,对应单色、16色及256色,不支持真彩色。PCX文件采用RLE行程编码,文件体中存放的是压缩后的图像数据。因此,将采集到的图像数据写成PCX格式文件时,要对其进行RLE编码;而读取一个PCX文件时,首先要对其进行解码,才能进一步显示和处理。

(5)PNG文件格式。作为GIF的替代品而开发的,它能够避免使用GIF文件所遇到的常见问题。它从GIF那里继承了许多特征,增加了一些GIF文件所没有的特性。用来存储灰度图像时,灰度图像的深度可达16位;存储彩色图像时,彩色图像的深度可达48位。在压缩数据时,它采用了一种在LZ77算法基础上改进的无损压缩算法。

(6)JPEG文件(.JPG)。采用一种有损压缩算法,其压缩比约为5∶1~50∶1,甚至更高。对一幅图像按JPEG格式进行压缩时,可以根据压缩比与压缩效果要求选择压缩质量因子。JPG格式文件的压缩比例很高,非常适用于要处理大量图像的场合,它是一种有损压缩的静态图像文件存储格式,压缩比例可以选择,支持灰度图像、RGB真彩色图像和CMYK真彩色图像。

(7)Targe文件(.TGA)。用于存储彩色图像,可支持任意大小的图像,最高彩色数可达32位。专业图形用户经常使用TGA点阵格式保存具有真实感的三维有光源图像。

(8)WMF文件(.WMF)。只使用在Windows中,它保存的不是点阵信息,而是函数调用信息。它将图像保存为一系列GDI(图形设备接口)的函数调用,在恢复时,应用程序执行源文件(即执行一个个函数调用)在输出设备上画出图像。WMF文件具有设备无关性,文件结构好,但是解码复杂,其效率比较低。

(9)EPS文件(.EPS)。用PostScript语言描述的ASCⅡ图形文件,在PostScript图形打印机上能打印出高品质的图形,能够表示32位图形(图像)。EPS文件格式分为Photoshop EPS格式和标准EPS格式,其中标准EPS格式又可分为图形格式和图像格式。

(10)DIF文件(.DIF)。AutoCAD中的图形,它以ASCII方式存储图像,表现图形在尺寸大小方面十分精确,可以被CorelDraw、3DS等软件调用编辑。

(11)CDR文件(.CDR)。CorelDraw的文件格式,所有CorelDraw应用程序均能使用的图形(图像)文件。

6.4 动画和视频

6.4.1 基础知识

1.基本概念

动画是将静态的图像、图形及图画等按一定时间顺序显示而形成连续的动态画面。从传统意义上说,动画是通过在连续多格的胶片上拍摄一系列画面,并将胶片以一定的速度放映,从而产生动态视觉的技术和艺术。电影放映的标准是每秒放映24帧(画面),每秒遮挡24次,刷新率是每秒48次。一般来说,动画是一种动态生成一系列相关画面的处理方法,其中的每一幅与前一幅略有不同。计算机动画是在传统动画的基础上,使用计算机图形图像技术而迅速发展起来的一门高新技术。计算机动画是采用连续播放静止图像的方法产生景物运动的效果,即使用计算机产生图形、图像运动的技术。计算机动画的原理与传统动画基本相同,只是在传统动画的基础上把计算机技术用于动画的处理和应用,并可以达到传统动画所达不到的效果。动画的内容不仅实体在运动,而且色调、文理、光影效果也可以不断改变。计算机生成的动画不仅可记录在胶片上,而且还可以记录在磁带、磁盘和光盘上,放映时不仅使用计算机显示器显示,而且可以使用电视机屏幕显示以及使用投影仪投影到银幕的方法显示。在多媒体应用中,计算机动画可以十分简单,也可以十分复杂,从某个对象、物体的运动到电视广告、动画片等。

动画的本质是运动。根据运动的控制方式可将计算机动画分为实时动画和逐帧动画两种。实时动画是用算法来实现物体的运动;逐帧动画是在传统动画基础上引申而来的,也即通过一帧一帧显示动画的图像序列而实现运动的效果。根据视觉空间的不同,计算机动画又有二维动画和三维动画之分。

1)实时动画

实时动画采用各种算法来实现运动物体的运动控制。采用的算法有运动学算法、动力学算法、反向运动学算法、反向动力学算法和随机运动算法等。在实时动画中,计算机对输入的数据进行快速处理,并在人眼察觉不到的时间内将结果随时显示出来。实时动画的响应时间与许多因素有关,如动画图像大小、动画图像复杂程度、运算速度快慢(计算机)以及图形的计算是采用软件还是硬件等。

2)矢量动画

矢量动画是由矢量图衍生出的动画形式。矢量图是利用数学函数来记录和表示图形线条、颜色、尺寸和坐标等属性,矢量动画通过各种算法实现各种动画效果,如位移、变形和变色等。也就是说,矢量动画是通过计算机的处理,使矢量图产生运动效果形成的动画。使用矢量动画,可以使一个物体在屏幕上运动,并改变其形状、大小、颜色、透明度、旋转角度以及其他一些属性参数。矢量动画采用实时绘制的方式显示一幅矢量图,当图形放大或缩小时,都保持光滑的线条,不会影响质量,也不会改变文件的容量。

3)二维动画

二维动画是对传统动画的一个改进,它不仅具有模拟传统动画的制作功能,而且可以发挥计算机所特有的功能,如生成的图像可以拷贝、粘贴、翻转、放大缩小、任意移位以及自动计算等。图形、图像技术都是计算机动画处理的基础。图像是指用像素点组成的画面,而图形是指几何形体组成的画面。在二维动画处理中,图像技术有利于绘制实际景物,可用于绘制关键帧、画面叠加、数据生成;图形技术有利于处理线条组成的画面,可用于自动或半自动的中间画面生成。计算机在二维动画中的作用包括输入和编辑关键帧;计算和生成中间帧;定义和显示运动路径;产生特技效果;实现画面与声音的同步;控制运动系列的记录等。二维动画的处理主要包括两个基本步骤:屏幕绘画和动画生成。屏幕绘画主要是使用图像处理软件完成,有时为了自动或半自动生成动画,也采用图形方法来描述画面。动画生成以屏幕绘画的结果(作为关键帧)为基础进行生成处理,最终完成动画创作。

4)三维动画

三维画面中的景物有正面,也有侧面和反面,调整三维空间的视点,能看到不同的内容。二维画面则不然,无论怎么看,画面的内容是不变的。三维与二维动画的区别主要在于采用不同的方法获得动画中的景物运动效果。三维动画的制作过程不同于传统动画制作。根据剧情的要求,首先要建立角色、实物和景物的三维数据模型,再对模型进行光照着色(真实感设计),然后使模型动起来,即模型可以在计算机控制下在三维空间中运动,或近或远,或旋转或移动,或变形或变色等,最后对运动的模型重新生成图像再刷新屏幕,形成运动图像。

建立三维动画物体模型称为造型,也就是在计算机内生成一个具有一定形体的几何模型。在计算机中大致有三种形式来记录一个物体的模型。

(1)线框模型。用线条来描述一个形体,一般包括顶点和棱边。例如,用8条线来描述一个立方体。

(2)表面模型。用面的组合来描述形体,如用6个面来描述一个立方体。

(3)实体模型。任何一个物体都可以分解成若干个基本形体的组合,如一个立方体可以分解为各种形体的组合。这种用基本形体组合物体的模型就是实体模型。

三维动画的处理需要综合使用上述三种模型。一般情况下,先用线框模型进行概念设计,再将线框模型处理成表面模型以方便显示,使用实体模型进行动画处理。同一形体的三种模型可以相互转换。

物体模型只有通过光和色的渲染,才能产生自然界中常见的真实物体效果,这在动画中称为着色(真实感设计)。对物体着色是产生真实感图形图像的重要过程,它涉及到物体的材质、纹理以及照射的光源等方面。

(1)材质。描述任何物体,除了造型以外,还必须有一定的附加特征(属性)来指明它的外在特性。物体的外在特性在很大程度上取决于构成它的材料。一般把材料的性质简称为材质,不同的材质表现出的质感是不同的。材质主要用来说明物体对入射光线作出的反应。一般来说,光线或者被反射、吸收,或者被透射、折射。反射的色光正是该物体呈现的颜色,而透射、折射产生的色光与材质有很大关系。

(2)纹理。纹理是物体表面细节,大多数物体的表面具有纹理。有了纹理可以改变物体的外观,甚至改变其形状。物体的纹理一般分为两种:一种是颜色纹理,如墙面贴纸、陶器上的图案等。颜色纹理取决于物体表面的光学性质。另一种是几何纹理,如人的皮肤、橘子的褶皱等。几何纹理与物体表面的微观几何形状有关。

(3)光源。给一个场景着色时必须知道有关光源的特性,如光源的位置、颜色、亮度和方向等,这些信息要由用户通过照明模型设定。决定光照射到物体表面并形成颜色的方法称为浓淡处理。浓淡处理要用到物体表面的几何材质信息,并对入射光进行考察,从而找出表面反射的色光。在进行浓淡处理时,一般对每个物体表面的每一个点分别进行处理,而且仅考虑来自光源的光照效果,而不考虑来自其他物体发出的光的影响。

三维动画处理的基本目的是控制形体模型的运动,获得运动显示效果。其处理过程中涉及建立线框模型、表面模型和实体模型。此外,一个好的三维动画应用系统能够将形体置于指定的灯光环境中,使形体的色彩在灯光下生成光线反映和阴影效果。运动物体不仅表现为几何位置改变,还带有光、色、受力、碰撞以及物体本身的变形等。动画控制也称为运动模拟。首先,计算机要确定每个物体的位置和相互关系,建立其运动轨迹和速度,选择运动形式(平移、旋转和扭曲等)。然后,需确定物体形体的变态方式和变异速度。光源确定好了以后,调整拍摄的位置、方向、运动轨迹及速度,就可以显示观看画面效果。

三维动画最终要生成一幅幅二维画面,并按一定格式记录下来,这个过程称为动画生成。动画生成后,可以在屏幕上播放,也可以录制在光盘或录像带上。

2.模拟视频

1)模拟视频原理

电视是当代最有影响的多媒体信息传播工具,在综合文、图、声、像等作为信息传播媒体这一点上完全与多媒体系统相同,不同的是电视系统不具备交互性,传播的信号是模拟信号。电视信号记录的是连续的图像或视像以及伴音(声音)信号。电视信号通过光栅扫描的方法显示在荧光屏(屏幕)上,扫描从荧光屏的顶部开始,一行一行地向下扫描,直至荧光屏的最底部,然后返回到顶部,重新开始扫描。这个过程产生的一个有序的图像信号的集合,组成了电视图像中的一幅图像,称为一帧,连续不断的图像序列就形成了动态视频图像。水平扫描线所能分辨出的点数称为水平分辨率,一帧中垂直扫描的行数称为垂直分辨率。一般来说,点越小,线越细,分辨率越高。每秒钟所扫描的帧数就是帧频,一般在每秒25帧时人眼就不会感觉到闪烁。彩色电视系统采用相加混色,使用RGB作为三基色进行配色,产生R、G、B三个输出信号。RGB信号可以分别传输,也可以组合起来传输。根据亮色度原理,任何彩色信号都可以分解为亮度和色度。

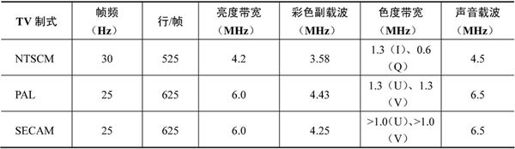

2)彩色电视的制式

电视信号的标准也称为电视的制式,目前世界各地使用的标准不完全相同,制式的区分主要在于其帧频的不同、分辨率的不同、信号带宽及载频的不同、彩色空间的转换关系不同等。世界上现行的彩色电视制式主要有NTSC制、PAL制和SECAM制三种,如表6-2所示。

表6-2 彩色数字电视制式

美国、加拿大、日本、韩国、中国台湾、菲律宾等国家和地区采用NTSCM制式;西德、英国、中国、中国香港、新西兰等国家和地区采用PAL制式;法国、东欧、中东一带采用SECAM制式。

我国电视制式(PAL)采用625行隔行扫描光栅,分两场扫描。行扫描频率为15625Hz,周期为64µs;场扫描频率为50Hz,周期为20ms;帧频是25Hz,周期为40ms。在发送电视信号时,每一行中传送图像的时间是52.2µs,对应行扫描的正程时间,其余的11.8µs不传送图像,对应行扫描的逆程时间加入行消隐信号和行同步信号,这样不影响行扫描发送或显示图像信息。每一场扫描的行数为625/2行,其中25行作场回扫,不传送图像。

采用隔行扫描比采用逐行扫描所占用的信号传输带宽要减少一半,这样有利于信道的利用;有利于信号传输和处理。采用每秒25帧的帧频(25Hz)能以最少的信号容量有效地满足人眼的视觉残留特性。采用50Hz的场频是因为我国的电网频率为50Hz,采用50Hz的场刷新频率可有效地去掉电网信号的干扰。

3.数字视频

视频信息是指活动的、连续的图像序列。一幅图像称为一帧,帧是构成视频信息的基本单元。在多媒体应用系统中,视频以其直观和生动等特点得到广泛的应用。视频与动画一样,是由一幅幅帧序列组成,这些帧以一定的速率播放,使观看者得到连续运动的感觉。计算机的数字视频是基于数字技术的图像显示标准,它能将模拟视频信号输入到计算机进行数字化视频编辑制成数字视频。全屏幕视频是指显示的视频图像充满整个屏幕,能以30帧/秒的速度刷新画面,使画面不会产生闪烁和不连贯的现象。电视机、激光视盘和摄像机等都可提供丰富多彩的模拟视频信号,常常需要把这些信号与计算机图形图像结合在一个共同的空间,通过处理达到最佳的效果,然后输出到计算机的显示器或其他电视设备上。模拟视频信号进入计算机,首先需要解决模拟视频信息的数字化问题。与音频数字化一样,视频数字化的目的是将模拟信号经模数转换和彩色空间变换等过程,转换成计算机可以显示和处理的数字信号。由于电视和计算机的显示机制不同,因此要在计算机上显示视频图像需要作许多处理。例如,电视是隔行扫描,计算机的显示器通常是逐行扫描;电视是亮度(Y)和色度(C)的复合编码,而PC的显示器工作在RGB空间;电视图像的分辨率和显示屏的分辨率各不相同等。这些问题在电视图像数字化过程中都需考虑。一般,对模拟视频信息进行数字化采取如下方式。

(1)先从复合彩色电视图像中分离出彩色分量,然后数字化。目前市场上的大多数电视信号都是复合的全电视信号,如录像带、激光视盘等存储设备上的电视信号。对这类信号的数字化,通常是将其分离成YUV、YIQ或RGB彩色空间的分量信号,然后用三个A/D转换器分别进行数字化。这种方式称为复合数字化。

(2)先对全彩色电视信号数字化,然后在数字域中进行分离,以获得YUV、YIQ或RGB分量信号。用这种方法对电视图像数字化时,只需一个高速A/D转换器。这种方式称为分量数字化。

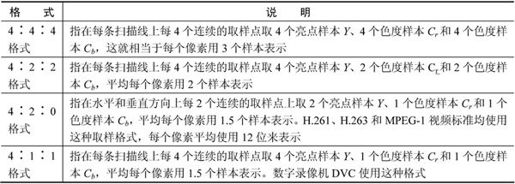

视频信息数字化的过程比声音复杂一些,它是以一幅幅彩色画面为单位进行的。分量数字化方式是较多使用的一种方式。电视信号使用的彩色空间是YUV空间,即每幅彩色画面有亮度(Y)和色度(U、V)三个分量,对这三个分量需分别进行取样和量化,得到一幅数字图像。由于人眼对色度信号的敏感程度远不如对亮度信号那么灵敏,所以色度信号的取样频率可以比亮度信号的取样频率低一些,以减少数字视频的数据量。目前使用的色度信号取样格式如表6-3所示。

表6-3 色度信号取样格式

CCIR601标准推荐使用4∶2∶2格式,并对采样频率、采样结构和彩色空间转换等都做了严格的规定。使用4∶2∶2格式时,亮点样本Y用13.5MHz采样频率,色度样本Cr、Cb用6.75MHz的采样频率。

4.数字视频标准

国际无线电咨询委员会(International Radio Consultative Committee, CCIR)制定的广播级质量数字电视编码标准,即CCIR601标准,为PAL、NTSC和SECAM电视制式之间确定了共同的数字化参数。该标准规定了彩色电视图像转换成数字图像所使用的采样频率、采样结构和彩色空间转换等。这个标准对多媒体的开发和应用十分重要。

(1)采样频率。CCIR为PAL、NTSC和SECAM电视制式制定的共同的电视图像采样频率标准为:采样频率=13.5MHz。

(2)分辨率。PAL和SECAM制式的亮度信号,每一扫描行采集864个样本点;而对于NTSC制式的亮度信号,每一扫描行采集858个样本点。CCIR 601规定对所有制式,每一扫描行的有效样本点数均为720个。

(3)数据量。CCIR 601规定,每个样本点都按8位数字化,即有256个等级。但实际上亮度信号占220级,色度信号占225级,其他位作同步、编码等控制使用。

5.视频压缩编码

数字图像数据的数据量大,而数字视频信息的数据量就更加突出。例如,每帧352×240像素点,图像深度16位的图像,其数据量约为1.3Mb,每秒30帧,其数据量就高达40Mb/s,这么大的数据量无论是传输、存储还是处理,都是极大的负担。为了解决这个问题,必须对数字视频信息进行压缩编码处理。

视频压缩的目标是在尽可能保证视觉效果的前提下减少视频数据率。视频是连续的静态图像,其压缩编码算法与静态图像的压缩编码算法有某些共同之处。但是视频还有其自身的特性,在压缩时必须考虑其运动特性。由于视频信息中各画面内部有很强的信息相关性,相邻画面又有高度的相容性(连贯性),再加上人眼的视觉特性,因此数字视频的数据量可压缩几十倍甚至几百倍。视频信息压缩编码的方法很多,一般在选择或设计视频压缩编码算法时需要掌握一些视频压缩的基本概念。

1)无损压缩与有损压缩

视频压缩中无损和有损压缩的概念与静态图像基本类似。无损压缩是指压缩前和解压缩后的数据完全一致。多数的无损压缩都采用RLE行程编码算法。这种算法特别适合于由计算机生成的图像,它们一般具有连续的色调。但是,无损算法一般对数字视频和自然图像的压缩效果不理想,因为其色调细腻,不具备大块的连续色调。

有损压缩意味着解压缩后的数据与压缩前的数据不一致。在压缩的过程中要丢失一些人眼和人耳所不敏感的图像或声音信息,而且丢失的信息不可恢复。几乎所有高压缩的算法都采用有损压缩,这样才能达到低数据率的目标。丢失的数据率与压缩比有关,压缩比越小,丢失的数据越多,解压缩后的效果一般越差。此外,某些有损压缩算法采用多次重复压缩的方式,这样还会引起额外的数据丢失。

2)帧内和帧间压缩

帧内压缩也称为空间压缩。同一景物表面上各采样点的颜色之间往往存在着连贯性,但是基于离散像素采样来表示景物颜色的方式通常没有利用景物表面颜色的空间连贯性,从而产生了空间冗余。当压缩一帧视频时,仅考虑本帧的数据而不考虑相邻帧之间的冗余信息,这实际上与静态图像压缩类似。由于帧内压缩时各个帧之间没有相互关系,所以压缩后的视频数据仍可以以帧为单位进行编码。帧内压缩一般达不到很高的压缩(很小的压缩比)。

视频具有运动的特性,故还可以采用帧间压缩的方法。采用帧间压缩基于许多视频或动画的连续前后两帧具有很大的相关性,或者说前后两帧信息变化很小的特点。例如,在演示一个球在静态背景前滚动的视频片段中,连续两帧中的大部分图像是基本不变的(背景不变),即连续的视频其相邻帧之间具有冗余信息。根据这一特性,压缩相邻帧之间的冗余就可以进一步提高压缩量,减小压缩比。帧间压缩也称为时间压缩,它通过比较时间轴上不同帧之间的数据进行压缩。帧差值算法是一种典型的时间压缩法,它通过比较本帧与相邻帧之间的差异,仅记录本帧与其相邻帧的差值,这样可以大大减少数据量。例如,如果一段视频不包含大量超常的剧烈运动景象,而是由一帧一帧的正常运动构成,采用这种算法就可以达到很好的效果。

3)对称和不对称编码

对称性是压缩编码的一个关键特征。对称意味着压缩和解压缩占用相同的计算处理能力和时间。对称算法适合实时压缩和传送视频,如视频会议应用就是以采用对称的压缩编码算法为好。而在电子出版和其他多媒体应用中,一般把视频预先压缩处理好,而后再播放,因此可以采用不对称编码。不对称或非对称意味着压缩时需要花费大量的处理能力和时间,而解压缩时则能较好地实时回放,即以不同的速度进行压缩和解压缩。一般地说,压缩一段视频的时间比回放(解压缩)该视频的时间要多得多。例如,压缩3分钟的视频片段可能需要10多分钟的时间,而该片段实时回放只需3分钟。

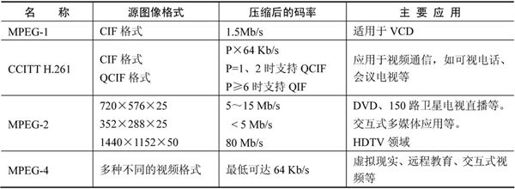

目前,国际标准化组织制定的有关视频(及其伴音)压缩编码的几种标准及其应用范围如表6-4所示。

表6-4 压缩编码的标准

6.4.2 视频文件格式

常用的视频文件格式如下。

(1)GIF文件(.GIF)。GIF(Graphics Interchange Format)是CompuServe公司推出的一种高压缩比的彩色图像文件。GIF格式采用无损压缩方法中效率较高的LZW算法,主要用于图像文件的网络传输。考虑到网络传输的实际情况,GIF图像格式除了一般的逐行显示方式之外,还增加了渐显方式。也就是说,在图像传输过程中,用户可以先看到图像的大致轮廓,然后随着传输过程的继续而逐渐看清图像的细节部分,从而适应了用户的观赏心理。目前因特网上大量采用的彩色动画文件多为GIF格式。

(2)Flic文件(.FLI/.FLC)。Flic是Autodesk公司在其出品的Autodesk Animator/Animator Pro/3D Studio等2D/3D动画制作软件中采用的彩色动画文件格式。其中.FLI是最初的基于320×200分辨率的动画文件格式,.FLC是.FLI的进一步扩展,采用了更高效的数据压缩技术,其分辨率也不再局限于320×200。Flic文件采用行程编码(RLE)算法和Delta算法进行无损的数据压缩,具有较高的数据压缩率。

(3)AVI文件(.AVI)。AVI(Audio Video Interleaved)是Microsoft公司开发的一种符合RIFF文件规范的数字音频与视频文件格式,Windows 95/98、OS/2等多数操作系统直接支持。AVI格式允许视频和音频交错在一起同步播放,支持256色和RLE压缩,但AVI文件并未限定压缩标准。因此,AVI文件格式只是作为控制界面上的标准,不具有兼容性,用不同压缩算法生成的AVI文件,必须使用相同的解压缩算法才能播放出来。AVI文件目前主要应用在多媒体光盘上,用来保存电影、电视等各种影像信息,有时也出现在因特网上,供用户下载、欣赏新影片的片段。

(4)Quick Time文件(.MOV/.QT)。Quick Time是Apple公司开发的一种音频、视频文件格式,用于保存音频和视频信息,具有先进的视频和音频功能,被Apple Mac OS、Windows 95/98/NT等主流平台支持。Quick Time文件支持25位彩色,支持RLE、JPEG等领先的集成压缩技术,提供150多种视频效果,并配有提供了200多种MIDI兼容音响和设备的声音装置。新版本的Quick Time进一步扩展了原有功能,包含了基于Internet应用的关键特性,能够通过Internet提供实时的数字化信息流、工作流与文件回放功能。此外,Quick Time还采用了Quick Time VR(QTVR)技术的虚拟现实技术,用户通过鼠标或键盘的交互式控制,可以观察某一地点周围360°的景象,或者从空间任何角度观察某一物体。Quick Time以其领先的多媒体技术和跨平台特性;较小的存储空间要求;技术细节的独立性以及系统的高度开放性,得到广泛的认可和应用。

(5)MPEG文件(.MPEG/.MPG/.DAT)。MPEG文件格式是运动图像压缩算法的国际标准,它包括MPEG视频、MPEG音频和MPEG系统(视频、音频同步)三个部分。MPEG压缩标准是针对运动图像设计的,其基本方法是单位时间内采集并保存第一帧信息,然后只存储其余帧对第一帧发生变化的部分,从而达到压缩的目的。MPEG的平均压缩比为50∶1,最高可达200∶1,压缩效率非常高,同时图像和音响的质量也非常好,并且在PC上有统一的标准格式,兼容性相当好。

(6)RealVideo文件(.RM)。RealVideo文件是Real Networks公司开发的一种新型流式视频文件格式,它包含在Real Networks公司所制定的音频视频压缩规范RealMideo中,主要用来在低速率的广域网上实时传输活动视频影像,可以根据网络数据传输速率的不同而采用不同的压缩比率,从而实现影像数据的实时传输和实时播放。RealVideo除了可以以普通的视频文件形式播放之外,还可以与RealVideo服务器相配合,在数据传输过程中边下载边播放视频影像,而不必像大多数视频文件那样,必须先下载然后才能播放。

6.5 多媒体网络

计算机网络是将多个计算机连接起来以实现计算机通信以及广泛实现多媒体信息共享,在网络上的分布式与协作操作就不可避免。多媒体空间的合理分布和有效的协作操作将极大地缩小个体与群体、局部与全球的工作差距。超越时空限制、充分利用信息、协同合作、相互交流、节约大量的时间和经费等是多媒体的基本目标。

网络具备传播信息的强大功能,并且在实际生活中扮演了媒体的角色。其次,国内各种机构都已开辟网上传播的新领域,网络报纸杂志、网络广播娱乐、网上教育、电子商务等业务应运而生,因特网逐渐达到了作为大众传播媒体的标准。

6.5.1 超文本与超媒体

1.超文本的概念

超文本是一种文本,与一般的文本文件的差别主要是组织方式不同,它是将文本中遇到的一些相关内容通过链接组织在一起,用户可以很方便地阅览这些相关内容。超文本是一种文本管理技术,它以节点为单位组织信息,在节点与节点之间通过表示它们之间关系的链加以连接,构成特定内容的信息网络。节点、链和网络是超文本所包含的三个基本要素。

(1)节点。超文本中存储信息的单元,由若干个文本信息块(可以是若干屏、窗口、文件或小块信息)组成。节点大小按需要而定。

(2)链。建立不同节点(信息块)之间的联系。每个节点都有若干个指向其他节点或从其他节点指向该节点的指针,该指针称为链。链通常是有向的,即从链源(源节点)指向链宿(目的节点)。链源可以是热字、热区、图元、热点或节点等。一般链宿都是节点。

(3)网络。由节点和链组成的一个非单一、非顺序的非线性网状结构。

文本中的词、短语、图像、声音剪辑或影视剪辑之间的链接,或者其他的文件、超文本文件的链接,称为超链接(热链接)。词、短语、图像、声音剪辑或影视剪辑和其他的文件通常被称为对象或者文档元素,因此超链接是对象之间或者文档元素之间的链接。建立相互链接的这些对象不受空间位置的限制,它们可以在同一个文件内也可以在不同的文件之间,还可以通过因特网与世界上任何一台联网计算机上的文件建立链接关系。

2.超媒体的概念

用超文本方式组织和处理多媒体信息就是超媒体。超媒体不仅包含文字,而且还可以包含图形、图像、动画、声音和影视图像片断,这些媒体之间也是用超链接组织的,而且它们之间的链接也是错综复杂的。超媒体与超文本之间的不同是,超文本主要是以文字的形式表示信息,建立的链接关系主要是文句之间的链接关系。超媒体除使用文本外,还使用图形、图像、动画、声音或影视片断等多种媒体来表示信息,建立的链接关系是图形、图像、动画、声音或影视片断等多种媒体之间的链接关系。

网页是Web站点上的文档。在Web网页上,为了区分有链接关系和没有链接关系的文档元素,对有链接关系的文档元素通常用不同颜色或下划线来表示。

6.5.2 流媒体

流媒体是指在网络中使用流式传输技术的连续时基媒体,而流媒体技术是指把连续的影像和声音信息经过压缩处理之后放到专用的流服务器上,让浏览者一边下载一边观看、收听,而不需要等到整个多媒体文件下载完成就可以即时观看和收听的技术。流媒体融合了多种网络以及音视频技术,在网络中要实现流媒体技术,必须完成流媒体的制作、发布、传播和播放等环节。

(1)流媒体系统通过某种流媒体技术,完成流媒体文件的压缩生成,经过服务器发布,然后在客户端完成流媒体文件的解压播放的整个过程。因此,一个流媒体系统一般由三部分组成:流媒体开发工具,用来生成流式格式的媒体文件;流媒体服务器组件,用来通过网络服务器发布流媒体文件;流媒体播放器,用于客户端对流媒体文件的解压和播放。目前应用比较广泛的流媒体系统主要有Windows Media系统、Real System系统和Quick Time系统等。

(2)流媒体一般采用建立在用户数据报协议之上的实时传输协议和实时流协议(RTP/RTSP)来传输实时的影音数据。RTP是针对多媒体数据流的一种传输协议,它被定义为在一对一或一对多的传输情况下工作,提供时间信息和实现流同步。RTSP定义了一对多的应用程序如何有效地通过IP网络传送多媒体数据。

(3)流式文件格式与多媒体压缩文件有所不同,编码的目的是为了适合在网络环境中边下载边播放。将压缩文件编码成流式文件,还需增加许多附加信息。为了使客户端接收到的数据包可以重新有序地播放,在实际的网络应用环境中,并不包含流媒体数据文件,而是流媒体发布文件,例如.RAM、.ASX等,它们本身不提供压缩格式,也不描述影视数据,其作用是以特定的方式安排影视数据的播放。不同流媒体系统具有不同的流式文件格式,例如,Real System系统具有的文件格式有RM,.RA,.RP和.RT;Windows Media系统具有的文件格式是.ASF和.ASX。

(4)浏览器是通过因特网邮件来识别各种不同的简单文件格式。Web浏览器都是基于HTTP的,HTTP中都内建有MIME。Web浏览器能够通过HTTP中内建的MIME来标记Web上的多媒体文件格式,包括各种流式文件。

(5)媒体播放器是一个应用软件,主要功能是用于播放多种格式的音频、视频序列。可以作为单独的应用程序运行,或作为一个复合文档中的嵌入对象。

多媒体网络技术(Multimedia Networking)在因特网上有很多应用,大致可分成两类:一类是以文本为主的数据通信,包括文件传输、电子邮件、网络新闻和Web等;另一类是以声音和视频图像为主的通信,通常把任何一种声音通信或图像通信的网络应用称为多媒体网络应用。

通常,声音或视频文件放在Web服务器上,由Web服务器通过HTTP把文件传送给用户。也可将声音或视频文件放在声音/视频流式播放服务器(Streaming Server)上,由流式播放服务器通过流放协议把文件传送给用户。流式播放服务器简称流放服务器。

目前声音和视频点播应用还没有完全直接集成到现在的Web浏览器中,所以一般采用媒体播放器来播放声音、音乐、动画和影视。典型的媒体播放器具有解压缩、消除抖动、错误纠正、用户播放控制等功能。现在可以将多媒体应用插件(Plug in)嵌入浏览器内部,与浏览器软件协同工作。这种技术把媒体播放器的用户接口软件放在Web客户端的用户界面上,浏览器在当前Web页面上保留屏幕空间,并且由媒体播放器来管理。客户端可使用多种方法来读取声音和影视文件,其中常见的方法有如下三种。

1)通过Web浏览器把声音/影视文件从Web服务器传送给媒体播放器

客户端读取声音/影视文件的最简方法是将声音/影视文件放到Web服务器上,然后通过浏览器把文件传送给媒体播放器,其过程如下。

(1)Web浏览器与Web服务器建立TCP连接,然后提交HTTP请求,请求传送声音/影视文件。

(2)Web服务器给Web浏览器发送响应请求消息以及请求的声音/影视文件。

(3)Web浏览器检查HTTP响应消息中内容的类型,调用相应的媒体播放器,然后把声音/影视文件或者是指向文件的指针传递给媒体播放器。

(4)媒体播放器播放声音/影视文件。

这种方法,媒体播放器必须通过Web浏览器才能从Web服务器上得到声音/影视文件,需要把整个文件下载到浏览器之后才把它传送给媒体播放器。这样就产生了播放延迟,影响了播放。因此,存在较大的延迟问题。

2)直接把声音/影视文件从Web服务器传送给媒体播放器

采用媒体播放器与Web服务器直接建立链接的方法,可以改进通过Web浏览器产生的延迟。在Web服务器和媒体播放器之间建立直接的TCP连接,可以实现把声音/影视文件直接传送给媒体播放器,其实现方法如下。

(1)用户通过超级链接以请求传送声音/影视文件。

(2)这个超级链接不是直接指向声音/影视文件,而是指向一个播放说明文件,这个文件包含有实际的声音/影视文件的地址(URL)。播放说明文件被封装在HTTP消息中。

(3)Web浏览器接收HTTP响应消息中内容的类型,调用相应的媒体播放器,然后把响应消息中的播放说明文件传送给媒体播放器。

(4)媒体播放器直接与Web服务器建立TCP连接,然后把传送声音/影视文件的HTTP请求消息发送到TCP连接上。

(5)在HTTP响应消息中把声音/影视文件传送给该媒体播放器并开始播放。

这种方法依然使用HTTP传送文件,不容易获得满意的交互性能(用户与Web服务器),如暂停、从头开始播放。

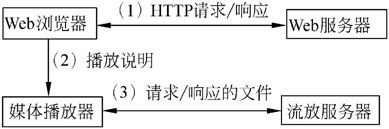

3)通过多媒体流放服务器将声音/影视文件传送给媒体播放器

采用Web服务器和流放服务器,将声音/影视文件直接传送给媒体播放器的方法,Web服务器用于Web页面服务,流放服务器用于声音/影视文件服务。其结构如图6-2所示。采用这种结构,媒体播放器向流放服务器请求传送文件,而不是向Web服务器请求传送文件,媒体播放器和流放服务器之间使用流放协议进行通信,声音/影视文件可以使用UDP(用户数据包协议)直接从流放服务器传送给媒体播放器。

图6-2 声音/影视文件传送给媒体播放器

6.6 多媒体计算机系统

一般的多媒体系统是由多媒体硬件系统和多媒体软件系统组成。也即将多媒体信息和计算机交互式控制相结合,由对媒体信号的获取、生成、存储、处理和传输数字化所组成的一个完整的系统。

通常将具有对多种媒体进行处理能力的计算机称为多媒体计算机(Multimedia Personal Computer, MPC)。随着芯片设计技术的发展,已将多媒体和通信功能集成到了CPU芯片中,形成了专用的多媒体微处理器,使得处理音频和视频就如处理数字和文字一样快捷。为了加快多媒体信息处理的速度,Micro Unity、Philips等公司将媒体处理器与通用的CPU结合,扩展了CPU的多媒体处理和通信功能。Intel公司推出了带有MMX技术的处理器。MMX技术提供了面向多媒体和通信功能的特性,并保持了微处理器的体系结构。另一方面,运用多媒体专用芯片和板卡,集成以PC为中心的组合平台。目前PC的多媒体功能大都通过附加插件和设备实现,如音频卡、视频卡、3D图形卡、网络卡以及CD-ROM驱动器、扫描仪、数码相机等。

6.6.1 多媒体计算机硬件系统

多媒体硬件系统可以看成是在PC的基础上进行了硬件扩充,以适应多媒体信息处理功能的需求。计算机硬件及声像等媒体输入输出设备构成了多媒体硬件平台。

多媒体计算机的主要硬件除了常规的硬件,如主机、软盘驱动器、硬盘驱动器、显示器和打印机之外,还要有音频信息处理硬件、视频信息处理硬件及光盘驱动器等。

(1)音频卡(Sound Card)。又称声卡,用于处理音频信息,它可以把话筒、录音机和电子乐器等输入的声音信息进行模数转换(A/D)、压缩等处理,也可以把经过计算机处理的数字化的声音信号通过还原(解压缩)、数模转换(D/A)后用音箱播放出来,或者用录音设备记录下来。

音频卡的关键技术包括数字音频、音乐合成(FM合成和波形表合面)和MIDI(数字音乐的国际标准,是指乐器数字接口)和音效。数字音频部分具有44.1kHz的采样率,8位以上的分辨率;具有录音和播放声音信号的功能;同时具有压缩采样信号的能力,最常用的压缩方法是自适应脉冲编码调制。数字音频的实现有不同的方法和芯片,大多数采用的是CODEC芯片,它具有硬件压缩功能;部分采用的是DSP+ADC(数字信号处理芯片+A/D转换器)方法,它利用软件的方法压缩数字音频信号。波形表合成使用DSP技术,它要求大容量的ROM,以获得高质量的演奏效果。

(2)视频卡(Video Card)。也称为显示卡,是基于PC的一种多媒体视频信号处理平台,用来支持视频信号的输入与输出。它可以采集视频源、声频源和激光视盘机、录像机、摄像机等设备的信息,经过编辑或特技等处理而产生非常精美的画面。还可以对这些画面进行捕捉、数字化、冻结、存储、压缩和输出等操作。对画面的修整、像素显示调整、缩放功能等都是视频卡支持的标准功能。视频卡可细分为视频捕捉卡、视频处理卡、视频播放卡以及TV编码器等专用卡,其功能是连接摄像机、VCR影碟机、TV等设备,以便获取、处理和表现各种动画和数字化视频媒体。

(3)光盘驱动器。光盘驱动器分为只读光盘驱动器(CD-ROM、DVD-ROM)和可读写光盘驱动器(CD-R、CD-RW),可读写光盘驱动器又称为刻录机。CD-ROM及DVD-ROM光盘驱动器目前是多媒体应用的主要设备,主要用于存储大量的影像、声音、动画、程序数据和高分辨率图像信息。CD-ROM可为多媒体计算机提供650MB的存储容量,DVD-ROM的存储量更大,双面可达17GB。CD-ROM驱动器价格便宜,对广大用户来说已经是必须配置的设备。CD-ROM的速度和兼容性也是重要的技术指标。单倍速(150Kb/s)是播放CD-Audio的最低要求,而十倍速的数据传输率可达1500Kb/s。

(4)扫描仪。扫描仪用于把摄影作品、绘画作品或其他印刷材料上的文字和图像,甚至实物,扫描输入到计算机中,进而对这些图像信息进行加工处理、管理、使用、存储和输出。扫描仪是获取图像的一种较简单的方法,现在已成为较流行的图像输入设备。扫描仪的种类很多,常用的有手持式扫描仪、滚筒式扫描仪和平板式扫描仪等。

(5)光学字符阅读器。光学字符阅读器是一种文字自动输入的设备。它通过扫描或摄像等光学输入方法从纸介质上获取文字的图像信息,利用各种模式识别算法分析文字的形态特征,判断文字的标准编码,并按通用格式存储在文本文件中。

(6)触摸屏。触摸屏是一种随多媒体技术发展而使用的输入设备。当手指点在屏幕上的菜单、图符等图形/图像按钮时,产生触摸信号,该信号经过变换后成为计算机可以处理操作的命令,从而实现人机交互。

(7)数字化仪。数字化仪是一种图形输入设备,它由平板加上连接的手动定位装置组成,主要用于输入地图、气象图等线型图。可以通过手动定位笔方便地获得每个线段的起始坐标,从而实现线型图输入。

(8)操纵杆。操纵杆是一种提供位置信息的输入设备,可支持其他定点输入设备,将它们(数字化仪、光笔等)输入的位置和按键信息提供给应用程序。在多媒体计算机上,操纵杆常用作游戏控制器,用来操纵电子游戏。它可以以模拟信号方式工作,也可以以数字信号方式工作,并可兼容各种游戏模式。

(9)绘图仪、投影仪和激光视盘播放器。绘图仪是一种图形输出设备;投影仪是一种将计算机输出的视频信号投影到幕布上的设备;激光视盘播放器(影碟机)是一种视频播放设备。

6.6.2 多媒体计算机软件系统

多媒体计算机软件系统主要包括多媒体操作系统、多媒体应用软件的开发工具和多媒体应用软件。

1.多媒体操作系统

多媒体操作系统必须具备对多媒体环境下的各个任务进行管理和调度;支持多媒体应用软件运行;对多媒体声像及其他多媒体信息的控制和实时处理;支持多媒体的输入输出及相应的软件接口;对多媒体数据和多媒体设备的管理和控制以及图形用户界面管理等功能。也就是说,它能够像一般操作系统处理文字、图形、文件那样去处理音频、图像、视频等多媒体信息;并能够对CD-ROM驱动器、录像机、MIDI设备、数码相机和扫描仪等各种多媒体设备进行控制和管理。传统计算机所使用的操作系统或多或少地都支持多媒体,例如,Windows 3.1在支持多媒体方面要比DOS强,但它们还不是真正意义上的多媒体操作系统。随着多媒体技术的发展,使得传统的操作系统增加了许多适应多媒体的内容,并研制出具备多媒体功能的操作系统。Apple公司的Quick Time以及当前流行的Windows系列产品Windows 98、Windows me、Windows 2000和Windows xp等都具备多媒体功能。

2.多媒体创作工具软件

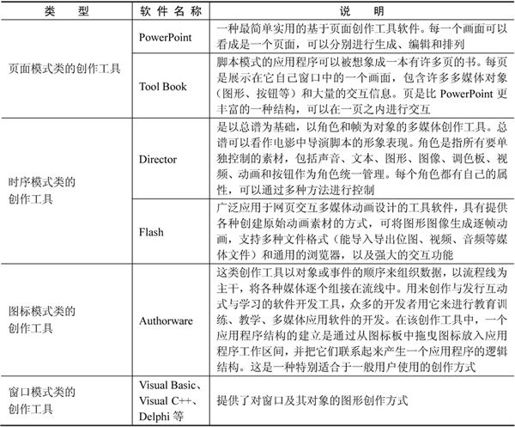

多媒体创作工具是在多媒体操作系统之上的系统软件,它提供了建立多媒体节目的构件和框架的功能,可以实现媒体的组接和交互跳转功能。通常,多媒体创作工具软件是用于开发多媒体应用程序的应用工具软件,帮助应用开发人员提高开发工作效率。它们大体上都是一些应用程序生成器,将各种媒体素材按照超文本节点和链结构的形式进行组织,形成多媒体应用系统。

多媒体创作工具软件按照组织方式与数据管理大致上可分为表6-5所示的4类。

表6-5 多媒体创作工具软件分类

3.多媒体素材编辑软件

在多媒体应用中,很重要的一个环节是制作所需要的各种媒体素材。多媒体素材编辑软件用于采集、整理和编辑各种媒体数据。多媒体编辑软件主要包括如下部分。

(1)文本工具。其功能主要是文字处理(编辑、排版和识别等),常用的字处理工具有WPS、Notebook(记事本)、Writer(写字板)、Word和OCR(光学字符识别)等。

(2)图形/图像工具。主要功能包括显示图形/图像、图形/图像编辑、图像压缩、图像捕捉、图形/图像素材库,常用的图形/图像处理工具有PhotoShop、Illustrator、PhotoDeluxe、PageMaker(中文版)、CorelDraw、AutoCAD(中文版)和3DS Max等。

(3)动画工具。主要包括动画显示、动画编辑和动画素材库等功能,常用的动画工具软件有GIF Construction Set、Xara3D。

(4)视频工具有主要包括显示视频、视频编辑、视频压缩、视频捕捉和视频素材库等功能,常用的动画工具软件有Media Studio Pro(中文版)、Premiere。

(5)音频工具。主要包括音频播放、音频编辑、音频录制和声音素材库4个功能,常用的音频工具软件有CoolEditPro、GoldWave和Cake Walk Pro Audio。

(6)播放工具。主要用于显示、浏览或播放图像、音频、视频等多媒体数据,常用的播放工具软件有Media Player(媒体播放器)、ACDSee。

4.多媒体应用软件

多媒体应用软件是实现用户的应用程序及演示软件,它是直接面向用户或信息发送和接收的软件。这类直接与用户接口,用户只要根据应用软件所给出的操作命令,通过最简单的操作便可使用这些软件(根据多媒体系统终端用户要求而开发的应用软件)。例如,特定的专业信息管理系统;语音/Fax/数据传输调制管理应用系统;多媒体监控系统;CD-ROM光盘的播放软件;各种多媒体CAI软件;各种游戏软件等。在人们探讨应用多媒体技术解决自己面临的应用实际问题时,设计建造出各式各样的应用软件系统,使最终用户运用多媒体系统能够方便、易学、好用。除面向终端用户而制定的应用软件外,另一类是面向某一个领域的用户应用软件系统,这是面向大规模用户的系统产品,如多媒体会议系统、点播电视服务(VOD)医用、家用、军用和工业应用等。