第7章

Chapter 7

LTE网络——更扁平,更高效

当基于ADSL的宽带出来之后,曾经也有人对此不屑一顾,56kbit/s的拨号上网不是够了吗?上网的需求不就是看两个没有图片的文字新闻,发几个E-mail么,那么大的带宽用来做什么吗?然而,宽带和互联网的发展迅速击溃了这种质疑,当今4Mbit/s的宽带已经成为主流,电信和联通都在开始推广20Mbit/s的宽带了,回顾中国10年前互联网的状况,真可谓沧海桑田。当时用56kbit/s的猫在互联网上的速度用蜗牛来打比方绝不夸张,碰到有图片的网页还需要点击“停止”键,否则整个网页要很久之后才能出得来,经历过当年互联网状况的人,可曾展望过今天?

有线宽带的革命也会发生在无线上,3G虽然曾经备受质疑,但是随着以iPhone和Android为代表的智能机成为主流,数据业务必将取代话音成为未来网络的发展重心,这一点已经成为共识,2011年1季度NTT和KDDI的数据业务ARPU值超越了话音便是明证。

视频点播、电视直播等高流量的业务发展,预示着无线网络必须在下行峰值速率和小区吞吐量方面有所突破;而越来越多的人开始通过无线网络参与互动类对战网络游戏,这意味着我们需要一张扁平的网络,减少层级,减少时延,提高反应速度。

没错,这两方面都是UMTS网络的长期演进——LTE(Long Term Evolution)网络所关注的。对于3GPP组织而言,这也基本属于共识,问题在于,UMTS网络刚刚部署不久,应该采用怎样的方式来达到要求,又采用怎样的节奏来推动网络向前演进呢?

7.1 LTE动力——跟WiMAX争武林盟主

3G技术无疑是当今移动通信的主流技术,而在3G的3大标准之中,又以3GPP制定的WCDMA标准最具竞争力和影响力,占据了很大一块3G的份额。2004年那会,当3G系统在全世界逐步部署的时候,增强型的UMTS技术——高速下行分组接入(HSDPA)和高速上行分组接入(HSUPA)的标准化工作也已经基本完成。对于未来,3GPP的主要成员公司也是早有打算,它们在做精心的准备,预计于2008年左右启动IMT-Advanced(International Mobile Telecommunication-Advanced,先进国际移动通信)技术的标准制定。IMT-Advanced技术也就是俗称的B3G(Beyond 3G,超3G)技术或者4G技术。当时踌躇满志的3GPP的一干众兄弟都在唾沫横飞地讨论3G的大好形势和4G的美好前景,当此之时,谁曾想到这3G和4G之间还会硬插进来个LTE。我们不禁要问,这LTE是怎么来的呢?

天有不测风云,在3GPP过着烈火烹油、鲜花似锦的日子的时候,斜刺里杀出来个搅局者——WiMAX(World interoperability for Microwave Access,全球微波互联接入)。虽然WiMAX的名字取得生硬拗口,也没有挂个什么“Communication”的头衔,看起来不像是来挑战3GPP的江湖地位的,但是这个不速之客还是着着实实让3GPP吃了一惊。3GPP如此重视WiMAX是有道理的,因为WiMAX其背后的力量实在不容小觑——WiMAX是由IEEE组织开发的标准,这个组织的名声不用说大家也知道。WiMAX势力的盟主也绝非泛泛之辈——正是大名鼎鼎的Intel!加盟阵容也可谓豪华,在芯片领域,有Intel和TI执其牛耳;在设备领域,阿尔卡特朗讯、北电、NEC、西门子依次排开;在运营领域的阵容也蔚为壮观,AT&T、BT、France Telecom、Sprint、Telefonica、KDDI都是赫赫有名的运营商。

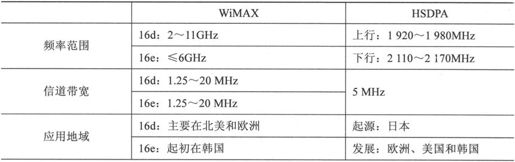

Intel曾是Wi-Fi的坚定支持者和主推者,现在它又开始力推WiMAX,既然Wi-Fi能如此成功,那么WiMAX的成功似乎也是顺理成章的事情。WiMAX其初衷在于“宽带的无线化”,IEEE希望为用户提供高速的、广覆盖的宽带无线接入,从这一点上而言,WiMAX可以理解为Wi-Fi的广覆盖版,Wi-Fi虽然很成功,但是其覆盖范围毕竟太有限了,而且用的是不需要授权的频段,不需要授权频段的特点就是方便,谁都可以拿来用,因此用得一多,干扰也就不可避免,这两个缺陷使得Wi-Fi注定只能去覆盖一些热点。而WiMAX可以实现对一个城市的广覆盖,这种定位就使得它不可避免地要和3GPP的UMTS及其增强型演进的标准来抢饭碗。抢饭碗就抢饭碗吧,开打靠的是实力,WiMAX各项性能指标怎么样呢?我们不妨和HSDPA进行一下对比,如表7-1所示。

表7-1 WiMAX与HSDPA性能比较

在这里,我们首先要区分一下WiMAX的两种主流标准,IEEE 802.16d和IEEE 802.16e,其中802.16d主要针对固定接收,也就是插个WiMAX网卡坐在星巴克边喝咖啡边上网的场景;而802.16e增加了移动性,这就和3GPP发生了正面冲突。我们可以从表7-1中看出,IEEE 802.16e在相等的带宽内下行峰值速率相对HSDPA并没有多大的优势,但是架不住人家带宽高啊,在10MHz频谱的带宽内,WiMAX能做到30Mbit/s。除此之外,WiMAX还支持动态带宽,可以在1.25~20MHz进行选择。对于有些带宽资源不那么富裕的国家,比如说美国,能动态调节带宽显然很有吸引力。

3GPP开始坐不住了,无论是WiMAX论坛还是WiMAX技术本身的性能指标,都让3GPP感到了一种潜在的威胁,如果WiMAX也像Wi-Fi一样遍地开花。那么HSDPA显然会受到不小的挑战,形势非常严峻。想这些年来3GPP及其之前的标准化组织在无线通信领域里从来都是纵横天下无敌手,WCDMA以及其前身GSM一直牢牢霸占着手机通信这一块最大的份额,这武林盟主之位,岂能轻易让人!

在这种局面下,3GPP旗下的通信厂商不得不团结起来快速跟进,为了使3GPP相对其他标准保持长期的优势,它们在HSDPA和IMT-Advanced之间横插进去一个标准,也即LTE,并不遗余力地投入了LTE的标准化工作。

为了能和可以支持20MHz的WiMAX技术相抗衡,LTE也必须将最大系统带宽从5MHz扩展到20MHz。为此,3GPP不得不放弃长期采用的CDMA技术(CDMA技术在实现5MHz以上大带宽时复杂度过高),而是采用了新的核心复用技术,即OFDM技术,这跟WiMAX采用了相同的方式。选取OFDM而放弃CDMA还有一个原因,就是因为高通在CDMA上收取的专利费用过于高昂,厂家希望有更便宜的技术。

同时,为了在RAN侧降低用户面的延时,LTE取消了一个重要的网元——无线网络控制器RNC,从模拟系统到2G、3G一直都扮演着重要角色的基站控制器就此退出了历史舞台。另外,在整体系统架构方面,核心网侧也在同步演进,推出了崭新的演进型分组系统(EPS, Evolved Packet System),这称之为系统框架演进(SAE, System Architecture Evolution)。无线网和核心网都有这样大的动作,这使得LTE不可避免地丧失了大部分与3G系统的后向兼容性。

自2004年11月启动LTE项目以来,3GPP以频繁的会议全力推动LTE的研究工作,仅半年时间就完成了需求的制定,可谓进展神速。在2006年9月完成了研究阶段(SI, Study Item)的工作,2008年底基本完成工作阶段(WI, Work Item),从2009年开始,已经陆续有一些运营商开始进行试商用。

7.2 LTE方向——移动通信的宽带化

应当说无论有没有WiMAX,移动通信标准都会走向今天的模样,也即“宽带化”、“数据化”、“分组化”。区别只是在于,WiMAX的出现大大加速了这一进程,并导致了横亘在HSDPA和IMT-Advanced之间的LTE的出现。LTE的本质和方向性的变革,还在于移动通信与宽带无线接入(BWA, Broadband Wireless Access)技术的融合。

宽带无线接入技术早期定位于有线宽带技术(如ADSL)的延伸,目的就是希望能够摆脱网线的束缚,实现自由自在的无线上网。最早实现这一目标的是IEEE 802.11x,也就是我们俗称的Wi-Fi。试想一下,假如没有Wi-Fi,你在星巴克上网的时候便会出现下面这样的场景,你微笑着跟服务员说:“请帮我牵根网线,要结实一点,你看这里人来人往,不要随便就被踩断,也不能太结实,免得成了绊马索”。试想随着人的增多,星巴克里牵着密密麻麻的网线,如同蜘蛛网一样,走路都要小心翼翼,多煞风景,哪里还优雅得起来。正因为如此,Wi-Fi一推出,即大受欢迎,现在的多数笔记本电脑和智能手机都含有Wi-Fi模块,其规模不可谓不大,应用不可谓不广泛。

然而Wi-Fi的缺点也是明显的,那就是覆盖距离太短,于是就推出了WiMAX的固定版,IEEE 802.16d,可以实现最大50千米的超远覆盖。在此基础上发展的IEEE 802.16e加入了寻呼和漫游等功能,体现了明显的“宽带接入移动化”的特点。这是信息技术(IT, Information Technology)产业向通信技术(CT, Communication Technology)产业的一次渗透,实际上,ICT技术的融合也是近年来非常热门的话题。

与此同时,移动通信技术也在向提供更高的数据速率而努力前行,3GPP和3GPP2组织分别向HSPA和EV-DV方向演进,这标志着3GPP和3GPP2在坚持蜂窝通信标准移动性的同时,也在日益重视低速行走、局部场景下的高速下载能力。这实际上也可以理解为CT向IT的一次渗透,通信产业从传统的话音业务在不断向宽带数据业务进行拓展。

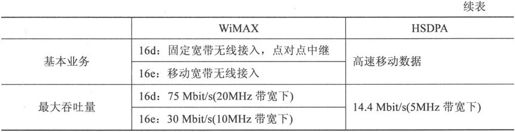

传统的通信产业和传统的IT产业不约而同地注意到了它们之间交汇点的巨大潜力——移动互联网(Mobile Internet)正在兴起,人们希望可以随时随地接入因特网,浏览新闻,观看视频,并通过微博随时分享他们的所见所闻(如图7.1所示)。移动互联网用户的增长是如此迅速,以至于摩根斯坦利在它的一份著名的报告“Internet Trends Outline”中用了史无前例一词来形容移动互联网发展的迅速。

而移动互联网的接入技术是可以多元化的,你可以通过HSDPA来上互联网,也可以通过Wi-Fi、WiMAX或者是EV-DO、LTE。只要你能满足无线宽带对于速率和延时等性能指标的要求,那么采用何种技术接入对于用户而言并不是那么关心。由于IEEE和3GPP、3GPP2从不同的方向朝着同一市场渗透,这也使得IT和CT在无线宽带领域的技术的界线变得越来越模糊,呈现出融合的趋势。

图7.1 移动通信和宽带无线接入的融合

“宽带接入移动化”的趋势表现为:由大带宽向可变带宽(在有的国家频谱资源比较紧张,为了部署方便,WiMAX可以支持小带宽);由固定接入向支持中低速移动演变,由孤立热点覆盖向支持切换的多小区组网演变(从802.16d向802.16e的演变趋势正是如此);由支持数据业务向同时支持话音业务演变;由支持以笔记本电脑为代表的便携终端,向同时支持以手机的移动终端演变。业务话音化、覆盖广域化、网络移动化、终端手机化,IEEE剑指何方,不言而喻。

而“移动通信宽带化”又表现为:由5MHz以下带宽向20MHz以上带宽演变(根据香农定理,没有更高的带宽就无法提供更高的速率,所以从2G到3G再到LTE其带宽都在不断提升);由注重高速移动向低速移动优化演变;由电路交换、分组交换并行向全分组域演变(无论是3GPP还是3GPP2都意识到了IP网络的迅猛发展,都在标准里增加了支持IP的选项);终端形态由以移动终端为主向便携、移动终端并重演变(大家可以看到数据卡的发货量是越来越大)。

正是因为对移动通信未来必然宽带化的共识和应对WiMAX挑战的需要,3GPP从2005年开始就将绝大部分力量投入了LTE的研发。但这样的决策并非没有争议,因为LTE相对UMTS而言变化太大,根本就是一次革命性的改变,而非LTE(Long Term Evolution)字面上来得那么平滑。为了保护在UMTS上的既有投资,也为了已有的UMTS网络相对WiMAX而言能够保持足够的竞争力,从2006年年初开始,又启动了HSPA演进(又称为HSPA+)的工作,到目前为止,HSPA+已经能够提供接近WiMAX和LTE的无线宽带接入能力。

7.3 先有的,后放矢——LTE需求

开公司,要先定战略,所谓战略,就是回答公司未来要往何处去。起草通信标准,首先要解决目标问题,技术细节敲定之前,先要对这个系统要达到的要求做一个整体的概述。我们都知道,目标越清晰,实现的可能性也就越大。3GPP会对LTE有一个整体的目标,然后向各个成员征集方案,所以这个目标往往也称作需求。我们就来看看LTE的需求都是什么,在这里,我们只挑选在本书将展开论述的最重要的几条。

(1)显著提高峰值数据率,达到上行50Mbit/s,下行100Mbit/s。我们知道,LTE追求的是“无线的宽带化”,想象一下,对于宽带而言,100Mbit/s,还是共享的,就相当于一个网吧的带宽只有100Mbit/s,这个要求高吗?当然,对于无线通信,这很不容易,相比有线通信而言,付出的代价要大得多。

(2)显著提高频谱效率,达到3GPP R6的2~4倍。速率在不断地提升,如果所需要的频谱带宽也随之同比例地提升,那就太不划算了。频谱是无线通信中最宝贵的资源,提高频谱资源效率,是通信中永恒的命题。

(3)尽可能将无线接入网的环回延时降低到10ms以内。现在我们是要做“无线宽带”,那么宽带要不要玩魔兽世界呢,宽带要不要玩反恐精英呢?对于每一个玩过对战类游戏的人而言,都知道延时高是一件多么痛苦的事情。

(4)可扩展带宽,需要支持1.4MHz、3.0MHz、5MHz、10MHz、15MHz、20MHz等系统带宽。我们可以看到,WiMAX和LTE都不约而同地提出了希望支持可变带宽,而且希望能够支持5MHz以下的小带宽。这是因为全球的频谱资源都很紧张,有些国家或者运营商可能拿不出20MHz这样完整的一块频谱资源出来用于LTE,那么让它们在更少的频谱带宽下也能运营LTE相当重要,能促进LTE在全球的开花结果。

下面我们就来看看LTE是如何实现以上目标的。

7.4 绕开高通的壁垒——LTE关键技术之OFDM

我们知道,无线宽带接入有多种技术,这些不同的技术标准可能都有不同的性能指标,但是一定有一条是最关键的,那就是下载速率。这一点在固定宽带里都不例外,大家去电信联通的营业厅都可以看到,2Mbit/s、4Mbit/s、8Mbit/s、20Mbit/s的宽带都有不同的价格,其差别在哪,无非就是带宽,卖的就是上网的速率。

下载速率要提升其关键点在哪里呢?在这里我们不妨又把香农公式翻出来,信噪比S/N能提升的空间总是很小的。要想提升宽带的容量C(也即下载速率),其关键还是在于B,即有多少频谱资源。为了提升上行下载速率,从GSM到WCDMA之时,带宽已经由200kHz拓宽到了5MHz。这次从WCDMA到LTE,也不能免俗,带宽最大值由5MHz提升到了20MHz(之所以提最大值,是因为LTE还支持小带宽,比如1.4Mbit/s之类,我们在后面会提到)。

频谱带宽提到了20Mbit/s,也带来了新的问题,那就是在这么高的带宽下CDMA技术实现起来非常复杂,必须寻找新的多址技术。这一点虽然会带来不少麻烦,但是3GPP的成员们还是比较愿意接受的,因为如此一来也可以绕开高通在CDMA上的专利了,可以少交不少专利费,可谓失之东隅,收之桑榆。

至于新的多址技术,也有WiMAX在前面铺路搭桥了,省了不少事情,这种新的多址技术就是OFDM(Orthogonal Frequency Division Multiplexing,正交频分复用)技术。

其实,OFDM并不是如今发展起来的新技术,OFDM技术的应用已有近40年的历史,主要用于军用的无线高频通信系统。但是,OFDM系统的结构非常复杂,从而限制了其进一步推广。直到20世纪70年代,人们采用离散傅里叶变换来实现多个载波的调制,从而简化了系统结构,使得OFDM技术更趋于实用化。20世纪80年代,人们研究如何将OFDM技术应用于高速MODEM。进入90年代以来,OFDM技术的研究深入到无线调频信道上的宽带数据传输。目前OFDM技术已经被广泛应用于广播式的音频、视频领域和民用通信系统,主要的应用包括:非对称的数字用户环路(ADSL)、ETSI标准的数字音频广播(DAB)、数字视频广播(DVB)、高清晰度电视(HDTV)、无线局域网(WLAN)等。

在正式介绍OFDM之前,必须先强调一下它的重要性。OFDM之于LTE和IMT-Advanced,就像CDMA之于3G的3大标准,都是最根本、最核心的东西。不理解码分多址,就很难读懂3G,而不了解OFDM,想搞清楚LTE也是件困难的事情。所以,希望读者在这一部分多花点时间,后面才会更顺畅一点。

在介绍TD-SCDMA的时候,我们把这个词拆成了“TD”、“S”、“CDMA”这3部分,分别阐述了这3部分的来历。其实对于OFDM而言,我们也可以采取相同的办法,因为OFDM也是由两部分组成的,即“O”和“FDM”。回想一下“WCDMA”、“cdma2000”,字母和数字之间都蕴涵有某种意思在里面,看来通信标准的取名都不是那么随便的。

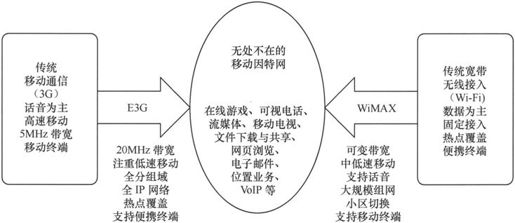

7.4.1 这该死的码间串扰——谈谈OFDM中的“FDM”

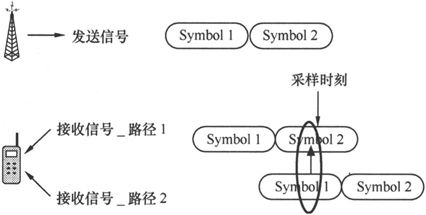

我们知道,在移动通信中有种现象叫做多径效应。所谓多径效应,指的是手机处于建筑群与障碍物之间,其接收信号的强度,将由各直射波和反射波叠加合成。信号发射之后,由不同的路径到达手机,然后会对信号造成一定的影响,这个就叫做多径效应。

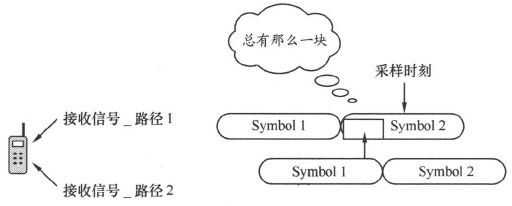

多径传播与视距传播有什么差别呢?差别就在于多径传播这多条信号到达终端的距离长短不一样,因此到达的时间也会不一样,会有一个时间差。(大家看看图7.2,显然路径1和路径2的距离不一样)

图7.2 多径效应

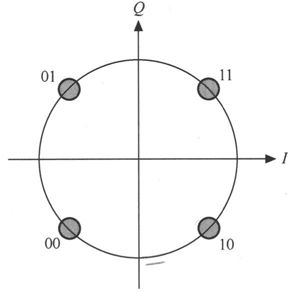

这个因多径效应造成的时间差会带来一件很麻烦的事情,即所谓的码间干扰(ISI, Inter Symbol Interference)。所谓码元,指的是一段有一定幅度或相位的载波,是数字信号的载体,有时候,也叫它码片。我们以QPSK调制方式为例,来看看什么叫码元,什么又叫做码元周期,码元周期的时间长短会带来什么问题。

图7.3 QPSK调制

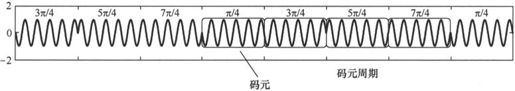

我们从图7.3中可以看到,QPSK调制实质上就是幅度不变,通过相位的变化来映射不同的比特数据。比如11映射到π/4相位,01映射到3π/4相位,00映射到5π/4,10映射到7π/4。如果我们用一段余弦波来表示调制后的结果,那么就如图7.4所示。我们可以对图7.4进行解调,它的码元是(3π/4,5π/4,7π/4,π/4,3π/4,5π/4,7π/4,π/4),用图7.3的方式进行解调得出的比特流就是(01,00,10,11,01,00,10,11),我们可以看到,调制其本质就是一个映射。

图7.4 QPSK中的码元与码元周期

图7.4中的每一个方框中的那一段余弦波就代表了一个码元,而一个码元的长度就是码元周期。对于QPSK而言,它只有π/4、3π/4、5π/4、7π/4四种变化方式,因此也就只有4种类型的码元,在图7.4中均有体现。为了简单起见,接下来我们都用 来指代码元,毕竟余弦波画起来要更困难。

来指代码元,毕竟余弦波画起来要更困难。

解释清楚了码元的概念,接下来我们可以看看在一个存在多径传播的无线环境中,码元周期的长短会带来什么影响。

图7.5 码间串扰

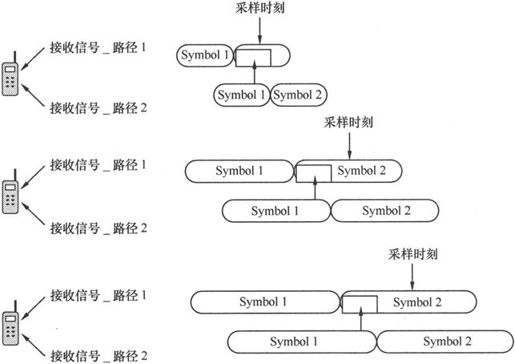

信号在通过多条路径到达接收端后,前一个码元的后端部分会干扰后一个码元的前端部分,这种干扰被称为码间串扰,如图7.5所示。

由于路径2的时延比路径1的要大,因此由路径2接收的码元1对路径1传播的码元2造成了干扰,这就是码间串扰的由来,码间串扰很可能造成采样判决出错。

虽然码间串扰可能造成采样判决出错,但是码元时间的长短与此又有什么关系呢。我们不妨来看看图7.6。不妨假设图7.6中最上方的码元周期为1,那么中间的图码元周期就为2,最下方的码元周期就为3。假设3张小图传播路径不变,都是从图中的基站到汽车,由于电磁波在空中的速率是既定的,那么传输时延也就是一定的。也就是说,这3张图唯一的差别就是码元周期不同。

我们看到,图7.6中,最上面的图码元周期最短,被干扰得也最厉害,采样判决很可能出错;中间的图的码元虽然也受干扰,但由于被干扰的部分离采样时刻还有一段时间,所以采样时刻采得的数据一般不会出错;最下面的图其干扰部分离采样时间最远,所以采样得来的数据出错的概率最小。

图7.6 不同码元周期受到的多径干扰的影响

这就是LTE的痛苦之所在了,在相等的带宽、相同的调制方式下,想要传输更多的数据,就需要更高的码片速率,也即更短的码元周期。打个比方,现在有20Mbit/s的带宽,假如码片速率为5Mchip/s,调制方式为QPSK,那么传输速率就为5Mchip/s×2=10Mbit/s,而码元周期就为 M=0.2μs,如果现在把码片速率提升至10Mchip/s,那么在同样为QPSK的调制方式下,其传输速率可以达到10Mchip/s×2=20Mbit/s,与此同时其码元周期就为

M=0.2μs,如果现在把码片速率提升至10Mchip/s,那么在同样为QPSK的调制方式下,其传输速率可以达到10Mchip/s×2=20Mbit/s,与此同时其码元周期就为 M=0.1μs。为了更高的速率其码元周期只有原来的一半了,这样的变化会带来怎样的影响图7.6中展示得已经很清楚了。在带宽和调制方式不变化的情况下,越高速率就会带来越低的码元周期、越严重的码间串扰,这显然不是我们想看到的。

M=0.1μs。为了更高的速率其码元周期只有原来的一半了,这样的变化会带来怎样的影响图7.6中展示得已经很清楚了。在带宽和调制方式不变化的情况下,越高速率就会带来越低的码元周期、越严重的码间串扰,这显然不是我们想看到的。

速率上不去,3GPP要被成员批评,因为WiMAX的威胁近在眼前,谁也不愿意将无线宽带的大好河山拱手让给IEEE;速率上去了,码间串扰干扰得一塌糊涂,比上不去还糟糕。3GPP可谓两难啊,怎样解决这个问题呢?

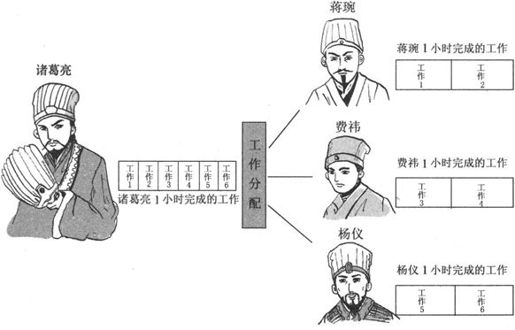

相传3GPP的几位专家对此也一筹莫展,郁闷之余,就开始阅读一些中国的古典名著聊以休息,也试图从东方的智慧中寻找若干启迪,这次他们看的著作叫做《三国演义》。三国演义中有一个著名的人物叫诸葛亮,此人上知天文,下晓地理,奇门遁甲,无一不通,相貌仪表也非常不俗,只可惜寿命短了点,未能完成统一大业就先走了一步。专家们经过研究,觉得诸葛亮未能长寿的主要原因是太能干了,同样的条件下完成的活是人家的3倍(速率是普通人的3倍),也就是说干同样一件事情只需要人家1/3的时间(码元周期只有普通人的1/3),这种高强度的工作损害了他的健康(码间串扰太严重了),以至于留下了千古遗憾。

面对诸葛亮的这种情况,几位专家除了唏嘘长叹之外也没有想出什么好的主意,直到他们有一天突然看到了一句话:“3个臭皮匠,顶一个诸葛亮”,这才觉得眼前一亮。虽然诸葛亮非常能干,没有人能及得上他的才干,但是蜀国还有很多大臣呢,把诸葛亮的工作分给蒋琬、费祎、杨仪,3个顶一个总行了吧,那3个人效率只有诸葛亮的1/3,但是工作是3个人分担,不会特别劳累的(码间串扰)。

图7.7 怎样减轻诸葛亮的工作压力

我们看到,在同等的时间里,蒋琬、费祎、杨仪的“码元速率”只有诸葛亮的1/3,也就是“码元周期”他们是诸葛亮的3倍。但是通过工作的合理分配,诸葛亮一个小时内“串行”的工作变成了蒋琬、费祎、杨仪“并行”的工作。虽然3个人的能力要差一些,但是通过一起努力也能顶上诸葛亮。如果诸葛亮不是事必躬亲,而是给这3个人多派点活,最后蜀魏相争的结局会不会有所改变呢。

经过品读三国和对诸葛亮积劳成疾的原因进行深入的分析,3GPP的专家们似乎也找到了码间串扰的终极解决途径。传统的无线数据业务总是采用了高带宽、高码元速率的方式(比如WCDMA5MHz带宽,3.84chip/s的码元速率;cdma2000 1.25MHz带宽,1.228 8chip/s的码元速率;TD-SCDMA 1.6MHz带宽,1.28chip/s的码元速率)。我们知道,码元周期就是码片速率的倒数,按原来的趋势发展下去,20MHz的带宽码元速率势必更高,码元周期势必更短,这样就会带来严重的码间串扰问题。

可是,为什么我们的思路要沿着高带宽、高码元速率的方式上走呢?为什么我们不能考虑低带宽、低码元速率呢?

有人可能要说,比特速率跟码元速率是一一对应的,QPSK就是2个比特映射1个码元,16QAM就是4个比特映射1个码元,码元速率降下来最后的结果势必是单载波的速率也会降下来。这的确没错,不过我们为什么要采用单载波,为什么不把带宽均匀地分成N份,然后采用多个载波呢。通过把一个载波分成N个子载波,将码元速率降为原来的1/N,这样虽然单个子载波的速率变成了原来的1/N,但是总速率是这N个子载波的总和N×1/N=1,并没有下降。总速率没有下降,但是每个子载波的码元周期却扩展了N倍,从而大大提高了抗码间干扰的能力,这实在是很划算。

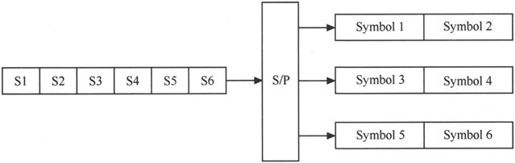

将带宽分成N份分配给N个子载波,每个子载波码元速率是原来的1/N,码元周期是原来的N倍,最后的总速率保持不变,这就是正交频分复用OFDM中的“FDM”,也即频分复用。频分复用的概念并不新鲜,我们在第2章里面就提到过,不过其思考的出发点不一样,在OFDM中,主要是为了解决高带宽带来的码元速率提升、码元周期下降、码间串扰加剧的问题。我们从图7.8中看看具体是怎么做的,其实这个问题和图7.7中处理诸葛亮过度疲劳的问题有异曲同工之妙。

图7.8 通过串并转换降低码元速率

我们从图7.8中看到,为了降低多径效应带来的码间串扰问题,OFDM采用了将串行的高速率业务通过串并转换(S/P,Serial/Parallel),变成N列低速的并行数据(为了画图简单起见,图中只画了3列)。这样一来码元速率就下降了,码元周期就大大扩展了,从而可以有效对抗码间串扰。最后,把这N列并行数据调制到N个低带宽的子载波上去,就完成了OFDM中“FDM”的过程。

我们在上文中已经多次提到了OFDM的子载波,这个子载波到底长什么样,我们不妨来看看。

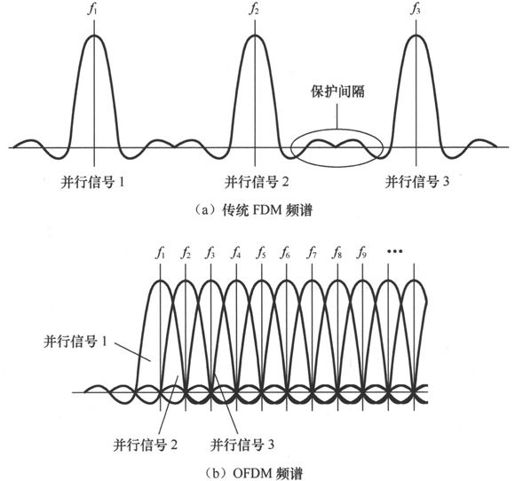

7.4.2 这正交的子载波——谈谈OFDM的“O”

完成图7.8所示的串并转换后,每一行数据都应该调制到一个子载波上去了。这个子载波有什么特点呢,我们先来看看“FDM”的情况,然后再看看“OFDM”的情况。对于FDM,我们并不陌生,如果是调制到FDM的子载波上,就会出现图7.9(a)所示的情况。

图7.9 FDM与OFDM的频谱

传统的FDM载波和载波之间还需要有一定的保护间隔,而OFDM却足够强悍,子载波之间不仅不需要保护带宽,频谱之间还可以重叠。这样一来,图7.8所示的3路并行信号调制到OFDM上就比FDM上节约了不少频谱资源,从图7.9中可以很容易地看出来。这些子载波的频谱之所以可以重叠就是因为它们之间是正交的,问题是,怎样的子载波才可以正交呢?

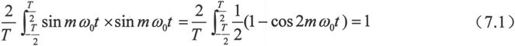

的确存在这么一个载波系列彼此之间是正交的,那就是著名的正弦函数及其倍数系列,其实对于余弦函数而言也是一样。

假设f1载波的频率为ω0,f2载波的频率为2ω0,后面的载波频率依次为ω0的倍数。那么这些调制载波就形成了一个正弦函数的序列{sinω0t,sin2ω0t,sin3ω0t,…},这个序列看起来也很普通,好像没有特别的道道,不过大家拿起来一算,马上就会发现其中的奥妙之所在了。

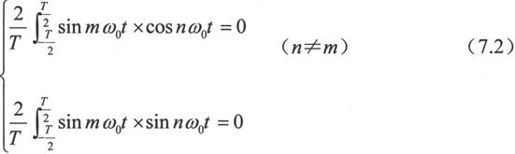

上式说明了,对于用sinmω0t(m等于任一自然数)进行调制的子载波的信号而言,用sinmω0t的子载波就可以顺利地完成解调。那么我们用一个频率不相等的子载波sinmω0t(n≠m)来解调会发生怎样的结果呢?

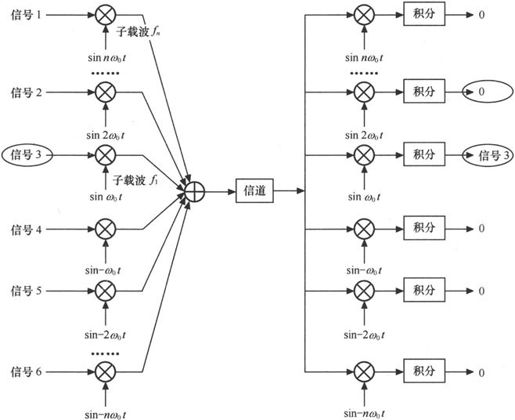

好家伙,只有自己这个载波能够解调出信号,别的载波一解调就变成了0,完全正交,这个性质太棒了。这也就是OFDM中“O”的由来,即“FDM”后切成的一小块一小块的子载波是完全正交的。我们可以把余弦函数套入式(7.1)和式(7.2)中取代正弦函数,很容易得出一模一样的计算结果,也即余弦函数和正弦函数在这方面的性质相同。

我们看到,在图7.10中,信号3(即高速串行信号转变为并行信号的第3个,图7.8、图7.9有说明)经过sinmω0t调制后除了sinmω0t够解调出来以外,在其他子载波上的解调信号都是0。这就是OFDM调制和解调的本质,实际上,在子载波上传输的是两路信号,一路是cosmω0t,一路是sinmω0t,两路相位相差了90°,恰好是正交的。也可以把两路实信号理解为一路复信号。为了简单起见,本节中只提了sinmω0t,但无论传输一路信号还是两路信号,其本质和基本的方法没有变化,所以读者当前只需要按图7.10的方式来理解就好了,以后读到OFDM相关材料的时候可以以复信号的方式再推演一遍。

图7.10 正交调制示意图

7.4.3 为了完美的信号而努力——保护间隔和循环前缀

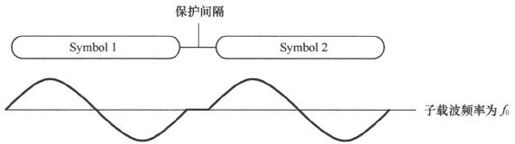

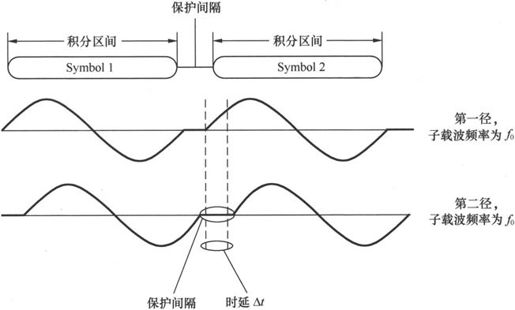

我们把高速的串行信号通过串并转换变成了低速的并行信号,然后将这N列并行信号调制到N个正交的子载波中,就完成了OFDM的基本过程。然而,事情到这里并不算完,如果这样就结束了,那OFDM也就太简单了。我们从图7.6中摘出中间那一段,如图7.11所示,我们会发现,通过将串行数据变成N路并行数据的方法能够扩大码元周期,降低码间串扰,但是降低并不意味着消除。码元周期再宽,由于多径效应造成的阴影总有那么一块横亘在那里,挥之不去。

图7.11 码间串扰依然存在

虽然图7.11中,接收路径2对接收路径1的码间干扰并不严重,只有一小块,但是毕竟还是存在的。能不能要求更高一点,把这一部分干扰也消除?办法一定是有的,而且并不新鲜,在GSM和TD-SCDMA中都挺常见,那就是在符号之间加入“保护间隔”,在保护间隔这段时间,啥信号也不传,通过空出一段资源不用来降低干扰,如图7.12所示。频谱的效率和通信的质量常常是一个两难的命题,由此可见一二。

图7.12 保护间隔

保护间隔真能解决由于多径效应造成的码间串扰吗?要对抗多径效应,又以多长的保护间隔为宜呢?

大家可以看到,在图7.13有两个径的接收信号,其中第一径信号没有延时,第二径信号的时延为∆t,我们从图中不难看出,只要时延∆t不超过保护间隔,那么就不会有码间串扰的问题;换句话说,只要保护间隔足够大,大于现网可能的最大传播时延,那么就不会有码间串扰。听起来似乎需要很大的保护间隔,其实不然,大家看看图7.2就知道,不同信号的路程差大也大不到哪里去,实在过大的路程差,由于信号太弱,也体现不出来。实际上,现网设置保护间隔就是按最大传播时延来设计的。

图7.13 时延与保护间隔

通过设置保护间隔,困扰我们已久的码间串扰问题终于解决了。然而,保护间隔刚刚把一个老的问题解决,却又冒出来了一个新的问题,是什么问题呢?

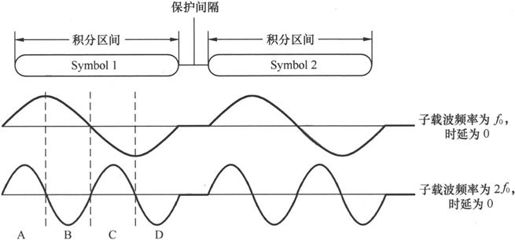

假设此时频率为f0的子载波和频率为2f0的子载波上的信号都没有时延,我们不难由式(7.2)得出这两个信号相乘为0,这两个子载波是正交的。其实我们也可以感性一点,从图7.14得出一个直观的认识,这两个信号相乘的时候由于子载波1的A区域大小相等,方向也相等;而子载波2的A区域和B区域大小相等,方向相反,因此在这一区域内子载波1的信号和子载波2的信号相乘求和必然为0。同理C、D区域也是如此,那么两个子载波相乘之后信号就为0,从而实现了正交。这是没有时延的情况,有时延后还能实现正交吗?我们来看图7.15。

图7.14 没有时延的子载波正交性

图7.15 有时延的子载波正交性

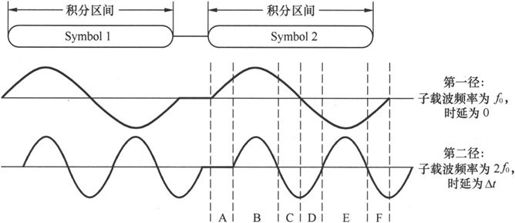

要看图7.15中的子载波的正交性,我们不妨再来一次“看图说话”。就A段区域,子载波2的值为0,那么乘积不用了,也是0;对于B和E区域,子载波1的信号大小相等、方向相反,子载波2的信号大小相等、方向相同,那么相乘然后两个区域相加,结果自然也是0;对于C和F区域,子载波1的信号大小相等、方向相反,子载波2的信号大小相等、方向相同,那么相乘然后两个区域相加,结果还是0;现在只剩下D区域了,D区域相乘积分的结果肯定大于0,那么整个信号相乘积分的结果也就大于0,这两个子载波存在干扰,这也叫做子载波间干扰(ICI,Inter-Carrier Interference)。

怎么样来解决这个问题呢?我们可以在A区域和D区域动动脑筋,其他地方都是成对抵消,就这两个区域不能成对抵消,破坏了和谐。其实在这两个区域成对抵消的基础也是有的,因为子载波1在A区域和D区域存在一对大小相等、方向相反的波形,我们只需要在子载波2的A和D区域生成一对大小相等、方向相同的波形即可,也即在A这个为0区域加一段波形。这一段波形从哪里来呢?无数跟OFDM相关的书籍告诉我们,可以把尾巴上那一段波形复制到前面的A区域这个“保护间隔”上来,这也叫做“循环前缀”。“循环前缀”的生成过程如图7.16所示。

这样一来,每段波形在保护间隔的位置上不再是为0的一段直线,而是一段连续的波形,这段波形来自信号的尾部,从而形成了一段“循环前缀”加上“符号时长”的连续波形。循环前缀(CP,Cyclic Prefix)是OFDM中的一个很关键的元素,通常拿它来当保护间隔,防止码间串扰。

我们看到,LTE最根本的一个任务就是大大提升数据速率。要提升数据速率,码元的速率必然也会大大提升(比特和码元就是等比例的映射关系);码元速率一提升则必然会带来码间串扰问题。

为了解决码间串扰问题,LTE引进了OFDM技术,OFDM技术其核心思想就是首先通过串并转换将高速的串行信号变成低速的多路并行信号。然后将这多路信号调制到多个正交的子载波上去,为了彻底消除码间干扰,OFDM又在码元之间引进了空白的完全不发送任何信号的保护间隔,如此一来,同一个子载波之间码间串扰(ISI)的问题是解决了,但是不同子载波之间就会存在干扰(ICI)。为了解决这个问题,OFDM通过将后部分的波形前置,形成“循环前缀”的方法来消除这个干扰,其实也就相当于用循环前缀顶替了原来的保护间隔。

图7.16 循环前缀的来历

值得注意的是,LTE只是在下行使用的OFDMA多址方式,因为OFDM信号的峰均比PAPR(Peak to Average Power Ratio)比较高,这就需要有一个线性度较高的射频功率放大器。而这种放大器需要比较高的成本,对于基站而言,这不是太大的问题,因为基站的数量相对手机而言毕竟不多,这点成本负担得起,但对于手机而言,就很成问题了。

因此LTE在上行链路采用的SC-FDMA,SC-FDMA是基于OFDMA针对上行链路的改良版,主要的改良点在于降低发射信号的峰均比PAPR。

OFDM的内容我们就介绍到这里,接下来我们来看看LTE另一项提升下行速率的关键项,也就是MIMO技术。

7.5 条条大路通罗马——关键技术之MIMO

在前期我们不断围绕多址方式、调制方式做了大量工作,一步步提升上下行的峰值速率,并使得频谱效率也得到了提高。不过,要进一步提升速率,光靠多址方式、调制方式的变化其潜力已经越来越有限了。如果一直按照当前的方式走下去,那么速率的提升就只能靠不断地提升带宽了,而频谱资源又是如此宝贵,用频谱换速率的做法就像是坐吃山空,显然是难以为继的。

真的就没有别的路可走了吗?谚语告诉我们,条条大路通罗马,放到通信的语境里,就会发现一些有意思的事情。首先这句话是告诉我们车到山前必有路,当传统方式的潜力挖尽的时候,我们很有可能通过我们的智慧寻找到别的解决路径,事实上这种途径我们也找到了,那就是多输入多输出(MIMO,Multi Input Multi Output)技术。这种方式在LTE及LTE-Advanced里面越来越重要。再者,把这句话放到MIMO技术里,就更有意思了,MIMO技术的物理实体就是发送端和接收端的N根天线,这些天线对应了N个通道,相比原来一根筋的单通道而言,真可谓是“条条大路通罗马”啊。

我们知道,对于单条链路而言,其容量受制于香农公式。不过Foschini等人将针对单条链路的香农容量公式推广到存在多个并行链路的系统中,给出了多天线系统的容量公式。正是在这一理论的指导下,BLAST(Bell Labs Layer Space Time,贝尔实验室分层时空编码)技术应运而生。

流行的观点认为每一个无线传输都要占用一段不同的频带,就像调频无线电台一样,在某一地理范围以内要分配不同的频段,否则干扰太大而无法进行通信。

但是BLAST的工作人员从理论上证明了利用同一个频段传输多个信号也是可能的,只要每个信号采取不同的发射天线进行发送,另外在接收端也要用多个天线以及独特的信号处理技术把这些互相干扰的信号分离出来。这样的话,在给定的信道频段上的容量将随天线数量的增加而成比例增加。

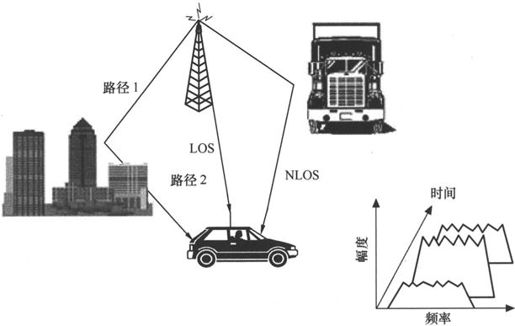

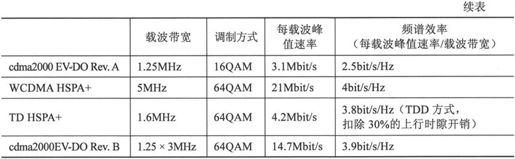

BLAST是一种无线通信新技术,利用信道的散射来得到大的增益,利用信号的多径传播来提高系统的性能。贝尔实验室的研究人员已经在实验室里对BLAST进行了改进和验证,显示的结果令人感到惊喜,其频谱效率达到了20~40bit/s/Hz,而使用传统无线调制技术仅为1~5bit/s/Hz(蜂窝系统,大家可以看看表7-2给出的各个蜂窝系统的频谱效率,就会知道20~40bit//Hz这个数据是多么的恐怖)。

表7-2 各制式峰值速率与频谱效率比较

贝尔实验室利用30kHz的带宽进行了测试,使用BLAST技术,传输速率可以达到0.5~1Mbit/s,而使用传统的典型方法只能达到50kbit/s。BLAST是一种极具竞争力和技术优势的技术,可以显著提高无线系统的效率。

在BLAST系统中,输入数据被解复用到多个发射天线上,每个天线发射不同的数据流。如果不标识这些数据流,那么相互之间的干扰将减少容量增益。使用一些方法来标识这些数据流就非常必要,比如可以像WCDMA中一样使用Walsh码,但是Walsh码使用之后,扩频了,信号所占的频谱宽度却增加了N倍,这显然会降低频谱效率,很不划算。所以寻找一种不降低系统增益的标识方法就尤为重要。

如果有足够多的散射,信道本身就可以通过散射来标识,这要求在所有的天线单元之间有一定程度的相关散射。另外接收机必须知道信道的散射特性,接收机可以使用发射机的导频和训练序列来测量信道,这样接收机就可以区分它们,这并不需要增加系统带宽,只是增加了导频开销。

所谓导频和训练序列,其作用有点像正式足球比赛开始之前的“适应性训练”,球员通过适应性训练,对一个场地的各种性能都有了个估计和判断,正式比赛的时候就可以根据这些估计和判断对触球点、力度、出球方位做一个修正。同样,导频和训练序列的工作就是在发送正式的通信信号之前,先发送一串收发双方都知道的固定的序列,接收方根据接收信号与固定序列的误差,就可以估计出信道的特性,接下来传正式数据的时候就知道该怎么样对接收信号进行修正了。在CDMA系统里(包括3G),导频的作用无非就是估计信道特性然后进行修正了,在MIMO里,还据此给信道打上标签,用以区分不同的信道。

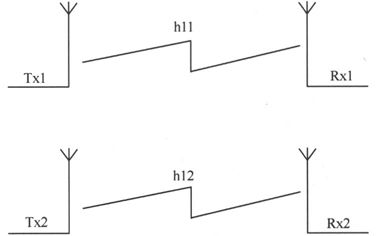

图7.17 2×2多天线系统中的信道标识

图7.17所示为一个多天线系统,h是一对特定发射和接收之间的信道传播相关因子,为了简化,图7.17只给出一个2×2的BLAST系统。原来的数据流被分为两个半速率的独立子数据流,一个在发射机Tx1上发射,接收机Rx1通过传播信道h11(根据导频信道判断出来的,然后打上了这么一个标签)接收到这个信号,接收机Rx2通过传播信道h12接收到这个信号,对于发射机Tx2也是同样的情况。当传播环境中有足够多的散射时,增加频谱效率的关键在于这些相关因子之间是独立的,没有什么关联的。在室内环境中,四面都是墙,会存在多条反射路径,因此这种前提是显然成立的。在一个典型的宏蜂窝中,也有足够多的散射。

在解调所有的数据流之后,总的数据速率等于子数据流速率乘以天线个数,这样可以N倍地增加容量,而没有增加任何发射功率,无论多少个天线,这种增加都是线性的。随着天线个数的增加,各子数据流的功率减少,但是如果接收天线的个数也增加,那么同样可以保证接收功率,而没有任何代价。如果没有足够多的散射来标识这些子数据流,由于干扰,系统容量将减少。所以BLAST尤其适合于繁华和热点地区,因为那儿有足够多的散射,同时也有较高的容量和高速数据应用需求。如果在一望无际的平原农村地区,MIMO的收益恐怕就不那么明显了,因为散射信道太少。

其实多根天线的系统我们之前并不是没有见过,从GSM开始就有发射分集,WCDMA、cdma2000也不例外。而TD-SCDMA由于使用的是智能天线,跟普通的天线分集还不一样。

目前天线发射分集在GSM里面用的最多,也就是在相邻10m左右的地方竖起两根不同的天线,朝着同一个方向发射,这样可以改善下行信号的质量,多路信号并行,这就好比在歌剧院里在几个不同的方向都装上音响,你的耳朵能接收多个方向的信号,自然要听得更清楚。在上行方向,也可以得到增益,虽然手机的发射信号只有一路,但是天线可以多路接收,相当于给基站安装了多个耳朵,耳朵越多,自然听觉越灵敏,听得越真切。

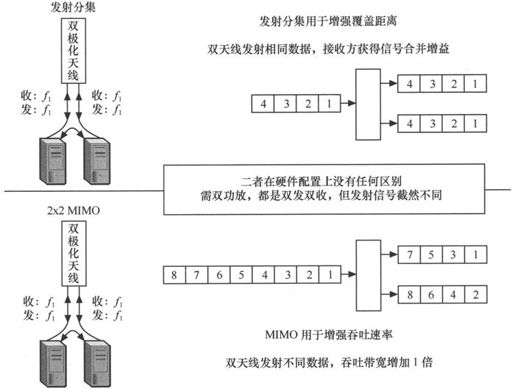

我们知道,天线发射分集也好,MIMO也罢,其关键点都在于使用了多根天线,物理实体是一样的,肉眼好像看不出很多区别,那么其关键区别在哪呢?其在网络中所起的作用又有什么不同呢?我们来看看图7.18。

就基站侧而言,发射分集与MIMO都是需要两根天线,而对于一个2×2的MIMO而言,这意味着手机也需要两根天线。我们在上面主要介绍的2×2的MIMO,其实对于MIMO而言,是可以做到M×N的,前面的M,代表的是基站的天线数目,后面的N,代表的是手机的天线数目。

M×N的MIMO对于系统能带来多大的增益呢,理论上而言最多可以提升M×N倍速率。我们不妨来看看一些实例。

日本的NTT DoCoMo公司于2003年5月在外场试验中采用了OFDM技术,在100MHz带宽中实现了100Mbit/s的数据速率,并在其后通过MIMO技术不断打破其创造的“峰值速率”的世界纪录,分别于2005年5月,2005年12月和2006年12月在外场试验中实现了1Gbit/s(采用4×4天线)、2.5Gbit/s(采用6×6天线)、5Gbit/s(采用12×12天线),向世界验证了OFDM/MIMO系统的硬件可实现性,展示了OFDM/MIMO技术在提供大宽带传输和高峰值速率方面的惊人能力,为业界采用OFDM/MIMO技术树立了信心。

图7.18 发射分集与MIMO在基站侧的区别

OFDM和MIMO可谓是LTE中最核心的技术,两种技术其关键点都在于提升上下行的速率。不过我们在LTE需求那一节中就已经提到了,LTE除了上下行速率以外,还有频谱效率、用户面时延、可变带宽等多种要求,我们来看看LTE在这些方面又做了哪些工作。

7.6 纵向删减,横向拉通——LTE的卓越之道

传统的企业是金字塔式的,金字塔状的企业结构由高层、中层、基层管理者和操作层组成,董事长和总裁位于金字塔顶,他们的指令通过一级一级的管理层,最终传达到操作层;操作层的信息通过一层一层的筛选,最后到达塔顶。这样一来,反应的速度势必变慢,据说国内某大型钢铁集团公司曾经失去大客户上海汽车一事,顶层管理者3个月后才知道。

针对这种情况,美国管理学家德鲁克一针见血地指出:“组织不良最常见的病症,也就是最严重的病症,便是管理层次太多。组织结构上一项基本原则是,尽量减少管理层次,尽量形成一条最短的指挥链”。这也就是现在俗称的企业扁平化。

扁平化带来的另一个结果就是分权。对于金字塔状的企业而言,由于层级多,传递过程和时间长,信息易失真,因此实行的是绝对集权管理,要求下属绝对地服从上级的命令、听从指挥。同时一个上级指挥的下级也少,有精力对每个下级进行有效的管理。

而企业扁平化之后,原来一个上司只管7个下属,现在可能要管30个,覆盖面一广,从精力上而言不可能做到面面俱到,因此一般是以分权管理为主,权力中心下移,各基层组织之间相对独立,尽量减少决策在时间和空间上的延迟过程,这将提高决策民主化和决策的效率。

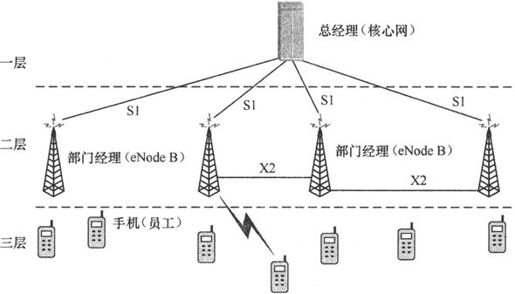

有时候不得不说人类的智慧是相通的,在企业由金字塔转向扁平化之时,移动通信网络几乎也发生了类似的变化。为了降低延迟,LTE将从2G到3G都一直很重要的基站控制器去掉了,无线网络由“核心网—基站控制器—基站”3级结构变成了“核心网—基站”2级结构。在网络扁平化的同时,也不可避免地遇到了企业扁平化的问题,那就是一个上级(核心网)管的下属(基站)太多了,因此必须分权,所以,基站控制器的功能,大部分被下移到了基站,由基站自行进行决策。

在无线接入网发现变革的同时,核心网也在悄然兴起一场革命,其中心思想就是全IP化。有这样的思路并不奇怪,互联网蓬勃发展,而且互联网也被证明了可以有效承接话音业务(比如Skype),作为一张以数据业务为中心的网络,LTE有什么理由在核心网再保持电路域加分组域这种传统的模式呢。

比方说以往的蜂窝系统,往往是采取电路交换模式(比如GSM),有的移动通信制式既有电路交换,又有分组交换(比如WCDMA,它有Iu-CS口和Iu-PS口分别与核心网的电路域和分组域相连),而LTE仅仅支持分组业务,它旨在在用户终端和分组数据网络间建立无缝的IP连接,以后无论是话音也好,数据也罢,全部走全IP网络,这跟传统网络大大不同。

LTE这个词的含义是Long Term Evolution,长期演进的意思。演进包含两方面,一方面是核心网的演进,叫做系统架构演进(System Architecture Evolution),也就是那个全IP的分组交换核心网(EPC, Evolved Packet Core);另一方面是无线接入网的演进,两者相加就构成了演进分组系统(EPS, Evolved Packet System)。上面专业术语比较多,读者可能看得比较头晕,作者之所以把它们都列出来是因为平时相关的资料或者文献里面经常提到这几个词汇。其实对于做无线的人来说,我们除了要记住LTE以外,其他几个名词比如EPC、SAE、EPS之类的可以暂且放在一边,不记得了就查书。接下来我们就从无线接入网和核心网两方面来阐述LTE相对GSM和WCDMA的变化。

7.6.1 世界是平的——扁平化的LTE无线网

《世界是平的》是普利策奖获得者托马斯·弗里德曼最畅销也是影响最大的书籍,在全世界都享有盛誉。如果弗里德曼也搞通信,我想他还会写一本书,叫做《LTE是平的》。如果问LTE的无线网相对以前的蜂窝系统变革最大的部分在哪里,那么就在于网络的扁平化。

在这里,我们首先来介绍一下LTE的无线接入网。LTE在砍掉基站控制器RNC后,它的无线接入网(E-UTRAN, Evolved-UTRAN)就只剩下基站这么一个网元了,界面倒是清爽了许多。大家很容易发现一点,以前无线接入网叫做UTRAN,这里叫做E-UTRAN,基站以前叫做Node B,这里叫做eNode B,这里的e,就是evolved(演进)的意思,因为在LTE里面基站eNodeB承接了很多原来RNC的功能,所谓权力越大,派头越大,既然原来的上级RNC的部分功能都有了,那么名片就要修改一下了,从头衔上一定要能看出来和以前那些基站的区别,于是就加了一个“e”,有这么一个前缀大家一看到就能心领神会,哦,这就是LTE网络的基站,那个强大的特殊的具有RNC功能的基站!

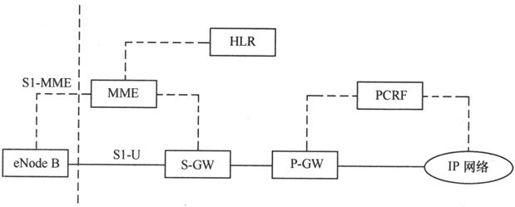

我们看到,在UMTS中的Iub接口、Iu-CS接口和Iu-PS接口不见了,取而代之的是eNode B和核心网之间的S1接口。如果将S1接口分得更细一点,又包括和MME相连的S1-MME接口以及和SGW相连的S1-U接口,如图7.19所示。关于MME和S-GW的功能我们暂且放到后面再说,大家在这里先把这两个设备笼统地理解为核心网。

图7.19 E-UTRAN总体架构

由于RNC的功能大部分都转移到了eNode B上,假如你把eNode B看作是RNC的话,那么你很容易就能理解S1-MME和S1-U接口是做什么用的。S1-U就相当于WCDMA中的Iu-CS接口和Iu-PS接口的用户面部分,也就是纯粹走话音和数据的,在LTE中话音和数据都是走的分组域的IP包,没有什么差别了,所以不再有Iu-CS接口和Iu-PS接口之分。S1-U中的这个U也就是User,用户数据的意思。

S1-U就相当于WCDMA中的Iu-CS接口和Iu-PS接口的控制面部分,走的都是信令。这个MME的全称叫做移动性管理实体(MME,Mobility Management Entity)。所谓移动性管理,就是管管位置更新、鉴权加密之类的工作,因为无线资源管理(切换、功控等)这个本来是RNC的活已经由eNode B承包了,所以只剩下了这部分功能。

除了S1接口以外,eNode B还有一个很有意思的接口,叫做X2接口。这个接口很特殊,特殊就特殊在于从GSM到WCDMA,从cdma2000到TD-SCDMA,基站与基站之间都不存在任何接口。但是在LTE时代,RNC消失了,所以RNC的有些功能eNode B就不得不承接下来,比如说基站的负载和干扰消息,以及切换信息,以前是由RNC来进行交互的。现在没有RNC了,就需要通过eNode B的X2接口来进行交互。如果是以前,基站是不需要知道另一个基站的负荷情况的,因为它不需要操心切换,RNC会来统计每个基站的信息,并作为切换和负载均衡的依据。这个X2接口就部分相当于以前WCDMA和TD-SCDMA中的Iur接口,以及cdma2000中的A3/A7接口。

我们不妨拿一个公司的例子来打比方,说明LTE的组织架构及接口情况,如图7.20所示。

图7.20 传统的3G网络结构

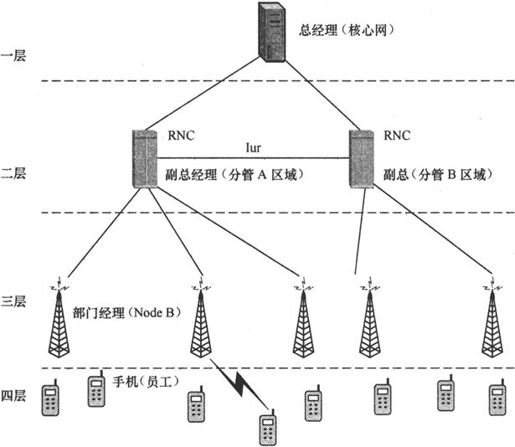

3G网络结构是一个典型的金字塔结构,假如把核心网理解为总经理,总揽全局的话;那么RNC就是副总经理,分管某一个大的区域;基站就相当于部门经理,直接管理着一堆员工(手机)。

作为一个称职的副总,RNC需要时时关注部门经理的Node B的负荷情况,比如是不是手下管了太多员工(太多手机在交互信息),或者说业务量太大(话务、数据流量高),如果是的话,就需要对不同部门经理的工作量进行调整,这个就叫做“负荷分担”。

在企业待过的人都知道,一个员工想跨部门调动,从来就不是两个部门的部门经理就能说了算的,一定要到主管副总这一级。在无线网络中,也是如此,如果一个手机因为所在区域的变化要从一个基站的切换到另一个基站,这两个基站是没有发言权的,它们只能把手机的测量报告(调动原因)上报给RNC,由RNC来进行决策,看到底该切换到哪个基站下。这个也是RNC副总的活——“切换”。

除此之外副总还要负责一个重要的事情,叫做“功控”。什么叫做“功控”呢,那就相当于员工的出差补助。如果离家比较远(距离比较远),一般补助会高一点(提高发射功率)。如果出差的地方条件比较差,环境比较艰苦(干扰严重,或者衰落比较厉害),通常也会多发钱来补偿(提高发射功率)。“功率控制”是移动通信中一个很重要的动作,在CDMA网络里尤其如此(需要用它来克服远近效应)。

这么多信息副总之间怎么交互呢,嗯,就是那个Iur接口,当然有的信息是先通过核心网,然后由核心网来和各个RNC互相交互,这也很正常,如果都是在下面就交互完了,不就把老大(核心网)架空了么。

应当说图7.20所示的结构运转得挺正常的,但是随着无线宽带化的趋势,未来势必有越来越多的像魔兽世界这样对时延要求很高的交互类游戏或者其他应用要跑在无线网络上,LTE未雨绸缪,提出了无线网络10ms往返时延的要求,这不能不说是一个挺大的挑战。为了降低时延,LTE公司把副总这一层砍掉了,由总经理直接管部门经理,减少层级,加快事情的处理,如图7.21所示。

图7.21 LTE的3层网络结构

我们看到,为了提高反应速率,LTE公司一狠心就精简机构了,裁掉的还不是普通员工,是副总经理!问题是,副总经理的这些活还得干,于是这些活就大部分下移到了eNode B。eNode B主要通过X2口交互各种信令消息。请注意,我们在图7.21中每个eNode B只与另外一两个eNode B相连,实际上,是可以跟若干个相邻的eNode B相连的。更强大的是,eNode B可以自动发现自己的相邻基站,并与它相连,这个是怎么实现的呢?

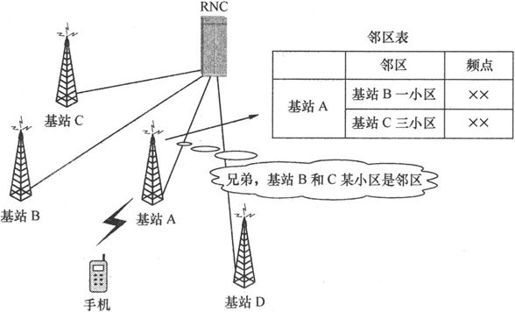

LTE中有一个自动邻居关联功能(ANRF, Automatic Neighbour Relation Function),这个功能就是利用手机来鉴别有用的相邻的eNode B节点,即eNode B可以允许手机从另一个eNode B的广播信息中读取新小区的小区身份标识,然后把这个信息上报给eNode B,这样eNode B就可以认为手机读到的小区信息就是它相邻的基站发的。这与传统的无线网络的邻区的鉴别方法有着本质的不同,甚至可以说完全相反。传统的邻区都是通过人工在仿真地图上比划的方式敲定的,然后在网络里进行配置,配置好的邻区信息是通过基站小区的系统消息的方式下发给手机的,手机对邻区既没有选择权,也没有建议权。如果某个邻区配置得不对或者配的是单向的,那么很容易就造成掉话,事实上现网很多掉话都是因为邻区配置不当引起的。传统邻区判别方法示意图如图7.22所示。

到了LTE时代,在这方面要大大迈进了一步,3GPP的设计者们估计征集了很多运营商的意见。我们知道,在空闲状态或者信号传输的压缩状态之时,手机会对其他基站的信号进行测量,如果发现信号的强度比较高,那么自然说明这个就是邻区了,因为一般意义上信号强说明手机和该基站离得也近,信号差说明手机和该基站离得也远。我们不难理解,通过手机的测量情况来发现邻区的方案自然要比人工看地图然后对邻区情况进行拍脑袋的工作有效得多。说起邻区的检查和优化,估计做GSM网络优化的人最有感触,他们几乎每天都需要查找邻区的漏配、多配、错配情况,这些工作是如此之多以至于他们总是过着面朝电脑背朝墙壁的生活,看到LTE对邻区的自动查找,估计要泪流满面:“啥年代才能上LTE啊,俺实在是不想优化邻区了”。

图7.22 传统邻区判别方法

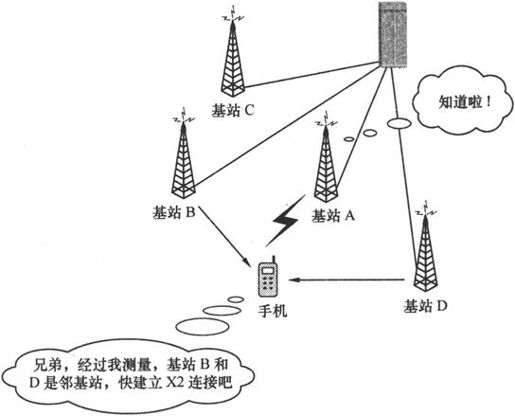

自动邻区管理功能(ANRF)是LTE引进自优化网络(SON)的非常关键的一步,另外一步靠的是X2接口自动的数据交换,如图7.23所示。只有有足够的负载、干扰、切换等信息,LTE网络的自动优化才能运转得起来,因为没有数据就只能靠拍脑袋,这可不是电脑的长项。

图7.23 LTE中的自动网络关联

7.6.2 车同轴,路同轨——全IP化的LTE核心网

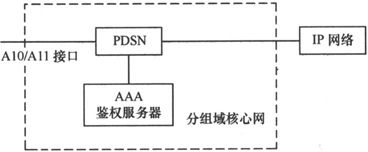

“天下大势,分久必合,合久必分”,这是《三国演义》中的经典台词,放到移动通信核心网的发展历程中来看也挺合适。最早的移动通信网是只有电路域的,GSM也好,IS-95也罢,都是这样,更不要提那个砖头般的大哥大了,整个核心网都是电路域的,这叫做“合”;到后来,数据业务的需求日益显现,于是在核心网侧除了电路域以外还有了分组域,比如GPRS中的SGSN和GGSN,以及CDMA 1X中的PDSN和AAA鉴权服务器,核心网被分成了电路域和分组域两部分,这叫做“分”;LTE设计之初就把满足数据业务放在了首位,加之Skype的成功,也说明了话音可以在IP网络上有效承载,所以一狠心就把电路域砍掉了,核心网又归一到分组域上,这叫做“合”。

所以我们看到移动通信的核心网也如三国一样经历了“合—分—合”的过程。三国的第一个合,合于“汉”,后一个合,合于“晋”;核心网的第一个合,合于“电路域”,后一个合,合于“分组域”。LTE的核心网号称是EPC网络,如同eNode B一样,这里也用E(演进)来标注自己的身份,我们看看有E的LTE的核心网和没E的WCDMA、cdma2000的分组域核心网有什么区别。

图7.24 cdma2000网络分组域

1.cdma2000网络的核心网(如图7.24所示)

AAA鉴权服务器的功能很简单,包含了鉴权、授权、计费功能。这个服务器的功能很重要,没有它运营商的网络就敞开让人用了,收不到费了。就好像健身房的前台一样,验证了你的会员卡才让你进(鉴权),然后每次运动完毕再进行收费(计费)。

PDSN的主要工作是给手机分配IP地址,建立、维护和终止与手机的PPP连接,并将数据转发到外部的公共数据网络。我们看到,这个设备除了要维护一条无线连接以外(没有办法,谁让无线的链路比有线的复杂那么多),其他功能跟路由器很相似。

2.GPRS/WCDMA/TD—SCDMA的核心网

3GPP出于平滑演进的考虑,继承了GPRS的原有分组域核心网,如此一来,GPRS、WCDMA、TD-SCDMA的分组域核心网基本上都是一致的,我们可以合到一起来看,如图7.25所示。

图7.25 GPRS/WCDMA/TD-SCDMA分组域核心网

SGSN的功能有点类似于GSM电路域中的MSC/VLR,其主要作用就是对移动台进行鉴权、移动性管理和路由选择。而GGSN的功能比较简单,那就是IP地址的分配和数据转发功能,然后生成计费信息,就相当于一台路由器。如果和cdma2000进行一下比较,我们就可以发现PDSN就相当于剥离了鉴权功能的SGSN和GGSN的合体。

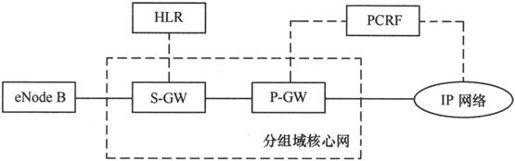

3.LTE的核心网(EPC网络)

LTE是3GPP发起的,由于思维惯性UMTS核心网的那些思路也会在LTE里有所体现。于是,我们想,一定会有和SGSN及GGSN相似的实体出现,如图7.26所示。

图7.26 LTE核心网(雏形1)

其中,S-GW是服务网关(Serving Gateway)的意思,它的功能和SGSN比较相似,但还不完全一样。它不仅要负责移动性管理,还要负责数据的转发,等于说把GGSN的一部分活都抢过来了。所以继承了SGSN的P-GW的PDN网关(PDN Gateway)就只剩下一个可怜的IP地址分配功能了。

我们知道,LTE时代,下行的带宽大大提高了,可以达到100Mbit/s甚至更高,可以拿“无线宽带”作为卖点来吸引用户了。但是大家知道,现在的有线宽带有一个特点,就是付费金额不同的用户可以得到不同的服务,比如说720元2M包年,1300元4M包年,等等。现在在LTE时代,带宽是共享的,那么运营商自然希望也设置不同的QoS等级,让付费更高的用户享受更好的保证带宽(GBR, Guranteed Bit Rate),这样运营商也可以赚到更多的钱。为了达到这个目标,LTE又在核心网里增加了一个叫做PCRF(Policy and Charging Rules Funciton,策略与计费规则功能)的设备,由这个设备来确定应该给用户怎样的QoS并通知P-GW执行,因此P-GW拜这个新政策所赐,又增加了一个新功能。那么分组域核心网需要做一点小小的调整,如图7.27所示。

图7.27 增加了PCRF的LTE核心网

大家看到,图7.24中cdma2000的核心网结构,没有包含HLR;图7.25中的GPRS/UMTS核心网的结构中,也没有HLR。莫非分组域核心网中,不需要HLR吗?

答案显然是否定的,开户信息、用户鉴权信息,以及用户现在所处的位置等重要信息都存储在HLR里,移动通信网里怎么可能少得了这个设备呢?图7.24中之所以没有HLR,是因为cdma2000中的AAA服务器已经包含了类似的功能,在cdma2000中,电路域使用HLR,分组域使用AAA服务器,这个我们在6.3.2节中已经讲过;图7.25中之所以没有HLR,是因为我们为了简单起见,没有画出来而已,在GPRS/WCDMA/TD-SCDMA中,分组域和电路域都是共用一个HLR的,SGSN都有到HLR的接口,叫做Gc接口。所以,很显然LTE里面也不可能没有HLR,于是,我们在图7.27的基础上略微进行修改,就成了图7.28。

图7.28 增加了HLR的LTE核心网

到图7.28,应当说LTE的核心网已经很完备了,有人分配IP,有人负责信息转发,有人记录用户信息,还有人控制QoS来赚增值服务费。但是LTE还是觉得不满足,它觉得S-GW的信令的流量是比较少的,业务数据流量是比较多的,两种流量应该分开由不同的设备来承载,比如信令由MME来承载,数据由S-GW来承载,这样才更有效率、更经济。因为S-GW可能在一个地市放一台,MME在省里放一台就够了。这也是继承了从WCDMA R4以来一贯的控制与承载分离的思想。我们对图7.28再进行一些修改,就成了LTE现网所采用的结构,如图7.29所示。

MME(Mobility Management Entity,移动性管理实体)是处理手机和核心网络间信令交互的控制节点,这个设备继承了一部分RNC的功能,比如位置更新、承载的建立和释放等。当然,RNC的大部分功能都下移到eNode B中去了。

图7.29 LTE现网结构

到这里,我们就介绍完了LTE的无线接入网和核心网,以及LTE的两个关键技术OFDM和MIMO,这几项构成了LTE的骨架。接下来我们想加一点细节的内容,将骨架填充一下,显得更有血有肉,要填充的内容是LTE的空中接口,毕竟,提到空中接口我们只讲到了OFDM和MIMO技术,这不过是LTE物理层所采用的多址技术,而我们介绍其他标准的时候都介绍到了帧结构和信道这一级,那么LTE也介绍到这一级的话也好比对。

7.7 万变不离其宗——LTE的物理层结构与流程

LTE对物理层资源的划分跟GSM极为相似,在单天线的情况下(不算MIMO),也是通过频率和时间两个维度来对资源进行划分。如果算上MIMO的情况,就还可以从空间的角度来进行区分,空间是通过多天线传输和接收技术来实现的,以“层”进行测量。为了简单起见,我们在这里只讨论单天线的情况,MIMO的情况过于复杂,暂不展开讨论。

7.7.1 “井田制”——GSM和LTE的资源划分之道

当人类从狩猎文明转向农耕文明之后,必然会遇到一个问题,那就是土地资源该如何分配。土地都是大自然形成的,大小不等,形状各异,宗族的族长给大家分配土地的时候,如果随手圈一块地就分给一个人,必然大小不均,显失公平。这个问题难不倒智慧的古人,土地天生大小不匀,我们可以后天给它划匀,一横一竖地画井字,长宽都固定,这土地不就划匀了么,如图7.30所示。

图7.30 井田划分资源

1.GSM与LTE的资源分配

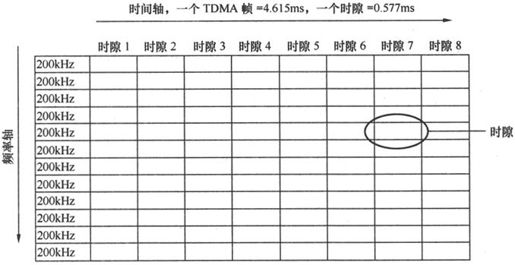

GSM也如法炮制,它以频率作为纵轴,时间作为横轴,也整出了这么一个围棋盘似的资源分配方案。从频率域上而言,GSM上行从890~915MHz,共有25MHz,按200kHz这样一刀刀切下去,可以切成75个频点,也可以理解为75个载波;从时间域上而言,GSM将一个TDMA帧切成8份,每个TDMA帧是4.615ms,那么每个时隙的时间长度就是0.577ms。频率上的200kHz和时间上的0.577ms组成了一个时隙,如图7.31所示。(下行的情况和上行完全对称,大家可以自行计算一下)

图7.31 GSM资源划分情况

大家应当仔细看一下图7.31对GSM频率与时间资源的划分,接下来再看LTE对频率与时间资源的划分,就会发现几乎长得一模一样,只是在参数和多址方式上略有差别,这些差别我们会在下面一一列举。

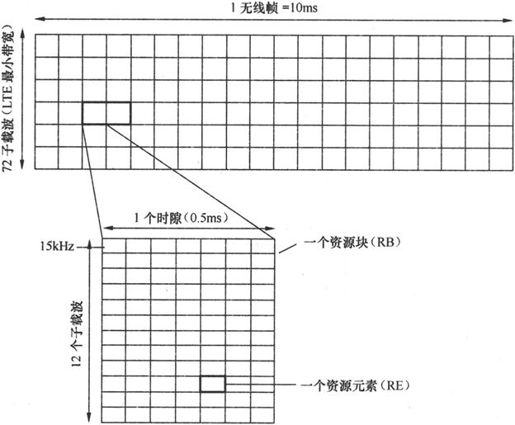

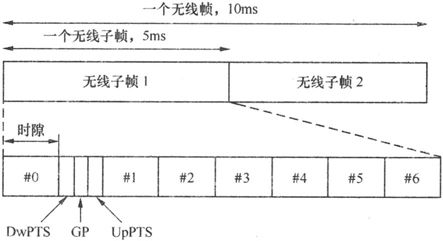

我们来看看LTE对资源的划分情况,首先看看时间域的划分情况。LTE最大的时间单元是一个10ms的无线帧,分为10个无线子帧,每个子帧1ms,这些子帧又分为2个时隙,每个时隙0.5ms,相当于一个LTE帧有20个时隙。这与GSM略有不同,GSM一个无线帧是4.615ms,不到LTE的一半,然后每个时隙是0.577ms,与LTE的0.5ms比较接近。另外,GSM里面没有无线子帧的概念。

在每个时隙里,LTE有7个OFDM的符号,至于一个符号对应多少比特,那要看调制方式。关于调制方式,在本书里已经说过多次,就不在这里赘述了。

在频率域上,LTE的一个子载波的宽度比GSM小得多,LTE的是15kHz,而GSM的是200kHz。LTE将频率切成这么细一条就是为了方便将资源进行灵活分配。大家可以从图7.32中看看资源分配的情况。LTE支持的最小带宽是72个子载波,也即1.08MHz。

图7.32 LTE资源划分情况(常规循环前缀方式)

接下来有两个非常重要的概念,在LTE里面用的很多。第一个是RE(Resource Element,资源元素),它由频率上的一个子载波和时间上的一个OFDM的符号持续时间组成,这是资源的最小单元;第二个是RB(Resource Block,资源块),资源块在频率域上占用了12个子载波(也即180kHz),在时间域上占用了一个时隙(也即0.5ms),图7.32的下半部分就是一个资源块。

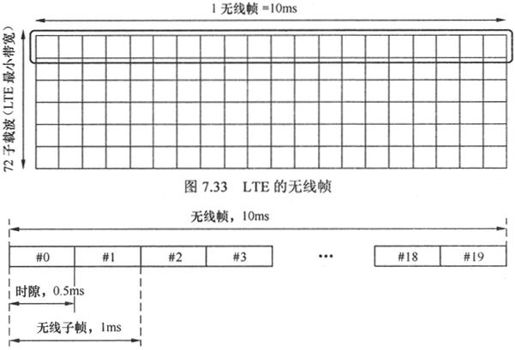

2.LTE的帧结构

我们随手摘出一个子载波在时间上的序列,如图7.33所示,就是所谓的一个无线帧了。现在这个无线帧是一片空白,我们按照协议规定的标准的格式填进去,即是所谓的无线帧结构了。帧结构有两种,其中一种用于FDD-LTE,另一种用于TDD-LTE,就是现在中国移动到处搞试点的TD-LTE。

(1)FDD帧结构。

适用于FDD帧结构的一个无线帧为10ms,一共10个子帧,每个子帧1ms,包含两个时隙,每个时隙0.5ms,如图7.34所示。

图7.34 FDD帧结构

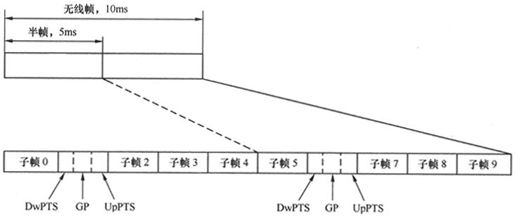

(2)TDD帧结构如图7.35所示。

图7.35 TDD帧结构

我们看到,TDD的帧结构与FDD的很相似,不过是把两个子帧单独拎出来用来做同步。这两个特殊子帧都包含3个特殊时隙——上行导频时隙(Uplink Pilot Time Slot)、下行导频时隙(Downlink Pilot Time Slot)和保护时隙(GP,Guard Period),这3个特殊时隙总长为一个子帧的时长1ms。这3个时隙似乎让我们想起了点什么,那就是TD-SCDMA的帧结构,如图7.36所示。

我们看到,TDD-LTE与TD-SCDMA的帧结构在某些方面非常相似,都是10ms的无线帧,都分成两个5ms的半帧。在这5ms时间里,TDD-LTE有4个常规子帧和1个特殊子帧,其中这个特殊子帧用来进行上下行的导频;而TD-SCDMA有7个常规时隙和1个特殊时隙,其中这个特殊时隙也是用来进行上下行的导频。

图7.36 TD-SCDMA的帧结构

在本章中,为了简单起见,讲述的都是FDD-LTE,如果读者对TDD-LTE感兴趣,请参考相关书籍。

关于LTE的下行链路的资源划分和帧结构就介绍到这里,上行由于采用的是SC-FDMA多址方式,与此略有不同,就不再加以详细的阐述。接下来让我们来了解一下LTE的基本工作流程。

7.7.2 “面经”是怎样总结出来的——LTE的物理层工作流程

作者没有当过“面霸”,但作者见过货真价实的“面霸120”,此人身经百战,面试过大大小小的无数公司。最后他总结出很凝练的几条经验,说HR的面试无非也就是那几个问题:“第一问你为啥放弃现在工作选择我司,看看你跳槽是有长远想法还是缺乏考虑,免得你很快又闪人;第二问你对我司的企业文化、工作强度、提供岗位有啥看法,看看两者之间合不合拍;第三对你的专业水平进行测试,看看你值多少钱”。现在网上流传的N多“面经”(面试经验),想必就是这样的“面霸120”总结出来的吧。

实际上,当你经历多了各种移动通信制式的通信流程之后,你会发现GSM、CDMA也好,WCDMA、TD-SCDMA或者LTE也罢,很多流程或者信令方面的东西都是相通的。比如说3G和LTE都需要先进行同步,只有同步之后才能进行其他的工作;同步之后需要导频,从而对信道进行估计;导频之后需要解读系统消息,只有解读了系统消息才能知道网络的一系列相关参数,然后进行下一步动作;都需要监听寻呼,否则没法当被叫。这样总结一圈下来,或许你也可以整个什么“流程经”、“信令经之类”的。

在本小节里,我们不妨拿WCDMA来和LTE进行一番工作流程上的比较,由于WCDMA的制定年代离LTE较近,因此相似之处要更多。

1.看电视,先校准时间

在当年手机和电子表还不是如此流行的时候,人们都习惯戴那种老式的上发条的手表。手表的作用是很重要的,要是你没有手表,搞不好你会上班迟到,赶火车晚点。所以那个年代的人结婚,手表和缝纫机、自行车一样,并列为结婚3大件。如果有了手表,但是时间不准,上面那些麻烦同样存在,所以当年晚上7点的新闻联播对于很多人还有一个特殊的意义,那就是校准手表。在7点新闻联播音乐响起的那一刹那,你也按下了手表的机芯,时间对准了,意味着你和这个世界同步了,工作可以正常开展了。

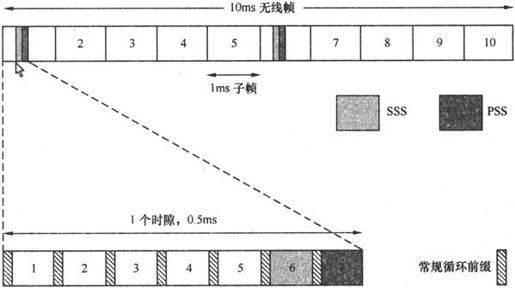

对于通信系统而言,这个同步来得要更重要,由于通信系统传递的都是一串串“0”,“1”的码流,如果在时间上没有统一标准,不同步,接下来的动作会很麻烦。所以LTE的第一步动作,也是进行同步。WCDMA的同步是在每个时隙的头256个码片,那么LTE的同步信号会是在哪个位置呢,由于每个子载波的信号都需要同步,因此每个10ms的无线帧都会有同步信号,我们来看看图7.37。

图7.37 LTE中的同步码(LTE概述——华为)

在WCDMA里面,分为主同步码(PSC)和从同步码(SSC),主同步码用来确定时隙的边界,从同步码用来确定帧的边界以及主扰码的组号,具体怎么实现的我们在4.3.2节中讲过,大家可以参考一下。在LTE里面也如法炮制,同步也分为两部分,即PSS(Primary Synchronizaiton Signal,主同步信号)和SSS(Secondary Synchronizaiton Signal,从同步信号)。

我们从图7.37中看到,PSS总是处在第1个时隙或者第11个时隙的最后一个OFDM符号上,而SSS总是和它挨着,一般位于倒数第二个OFDM符号上(图中显示的1和6指的是子帧号,一个子帧包含两个时隙)。

PSS和SSS的作用与WCDMA中的PSC和SSC很相似,也是PSS用来对时隙进行定界,而SSS用来对帧的边界位置进行敲定,SSS还可以得到小区识别号。

2.信号不好,调调天线

以前的电视机,黑白的也好,彩色的也罢,都是接收的无线电磁信号,而不像现在一样接收的是广电提供的有线闭路电视信号。既然是接收无线信号,那么电视机就像现在的一些收音机一样,机体还带着一根天线。如果看着觉得信号不好,就可以对天线进行调整,拉长缩短,调左调右。

我们可以拿电视机上的图像跟生活中所见到的图像进行对比,如果出现变形就意味着信号质量有问题,需要进行调整和校正。在这里,我们生活中见到的图像充当了“导频信号”,如果发现电视机上的图像与之反差很大,就知道信号不对了,需要校正。

在无线通信中,导频起的也是相同的作用,导频信号是一串收发双方都知道的固定的序列。导频信号通过信道发送之后可能会有失真,会有丢失,接收端根据已知的固定序列一比对就知道问题出在哪里,就可以对信道进行校正。

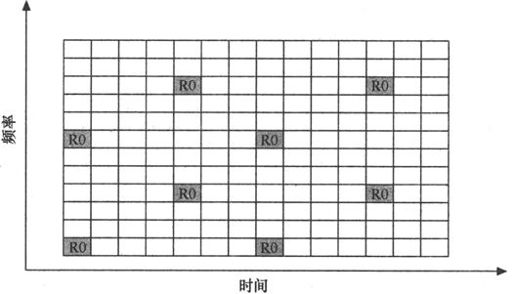

我们看到,在LTE里,同步信号是每个子载波上都有的,但是对于导频信号而言,这样做没有太多必要。因为LTE的子载波之间的频率相差也就15kHz,这是与其他制式完全不同的,在之前,GSM的信道带宽可以算很窄了,也有200kHz。子载波之间的频率差别如此之小,那么相邻的子载波之间信道差异也不会很大,所以没有必要那么奢侈,几个子载波共用一个导频信道就好,如图7.38所示。

图7.38 LTE的参考信号

图7.38中的阴影区域并标识了R0的格子说明那是参考导频信号。大家数一数图中的横轴和纵轴的格子。纵轴是12个格子,也就是12个子载波;横轴是14个格子,也就是14个OFDM符号。对数字敏感的人或许察觉了什么,12个子载波和7个OFDM就组成了一个RB资源块(见7.7.1节的图7.32)。这也就是说,图7.38中的8个导频OFDM符号存在于两个RB中,也即每3个子载波才有一个导频符号,比起每个子载波都放导频信号来说还是节约了不少资源。

3.欲看电视,先看导播信息

手表的时间对好了,发条拧上了,电视的天线位置也校准好了,接下来该干什么呢?毋庸置疑,肯定应该先看导播信息,电视台总会隔段时间就播放导播信息,好让你知道有些什么节目,都分布在什么时间,这些导播信息跟移动通信网中的系统信息非常相似。LTE在前两个步骤里进行了信号的同步,又给出了导频参考信号用于信道估计,接下来的事情就是收听系统消息了,这在WCDMA和LTE中均无例外。WCDMA在用P-SCH和S-SCH完成同步,用CPICH导频信道进行校正之后,接下来做的工作也是收听系统消息。其实不止WCDMA,GSM、CDMA、TD-SCDMA莫不如此。

在LTE中,是利用PBCH(Physical Broadcast CHannel,物理广播信道)来传输系统消息的。PBCH很有意思,不管LTE采用的带宽是多少,它永远都是只占用中间那72个子载波来传输数据(72×15kHz=1.08MHz),这下大家可以理解LTE的最低带宽为什么是72个子载波了吧,低于72个子载波系统广播消息都没法发送全,接下来的工作不好开展啊。

我们可以看到,图7.39上半部分表示的是有N个子载波,PBCH占了中间的72个子载波用于发射信号。图中所示的是6个RB,一个RB在频率轴上占12个子载波,因此6个RB就是72个子载波。我们从中截取一个无线子帧,即两个RB,放大来看,如图7.39的下半部分所示。

图7.39 PBCH结构

下半部分的前3列,也就是前3个OFDM符号除了导频参考信号以外没有填充其他信号,其实这部分是用来走信令的,我们在这里不展开详述。由于图7.39取的是第一个时隙,所以符号6和符号7都是用来做同步的信息,至于其他部分,就可以用来传送PBCH信息了,PBCH的空余地方,还可以用来传送PDSCH信息,那么什么是PDSCH信息呢?

4.PDSCH,LTE的正餐

如同吃饭一样,开餐前的小点心凉菜只是用来开胃的,后面的才是正餐。前面的同步、导频和播放系统消息,目的无非是一个,为了传送话音和数据,以及伴随话音和数据的信令,那么这些信息承载在哪呢?答案就是PDSCH(Physical Downlink Shared CHannel,物理下行共享信道)。

物理下行共享信道(PDSCH)是LTE承载主要数据的下行链路信道,所有的用户数据都能使用,还包括没有在PBCH上传播的系统广播消息,以及寻呼信息——LTE系统中没有特定的物理层寻呼信道。PDSCH通常以资源块为单位进行调度。

由于PDSCH没有特殊的位置,所以在本节中也就不再就PDSCH画框图。

到这里为止LTE的基本内容就介绍完了,我们在本章中介绍了LTE的来历,所期望达到的目标,以及两大关键技术——OFDM和MIMO。除此之外,我们还描述了LTE在无线接入网侧和核心网侧发生的变革。最后,我们介绍了LTE资源的划分方法以及使用得最多的信道。

应当说,LTE离4G技术还有相当一段距离,为了更高的速率、更低的延时、更优的架构、更低的成本,人们还在不断努力,将LTE继续向前演进,这就是LTE-Advanced。