5.1.2 使用Eclipse开发Spark程序

下面介绍如何使用Eclipse配置和开发Spark的环境,用户可以在Windows或者Linux环境下使用Eclipse进行开发。

1.环境配置

与Intellij配置环境一样,需要用户下载安装JDK和Scala。前文已详细介绍,这里不再赘述。

1)下载Eclipse Scala IDE插件,官网地址为http://scala-ide.org/download/sdk.html,可在官网中自行下载安装。

2)下载Eclipse[1],官网地址为http://www.eclipse.org/downloads/。

2.安装Scala插件

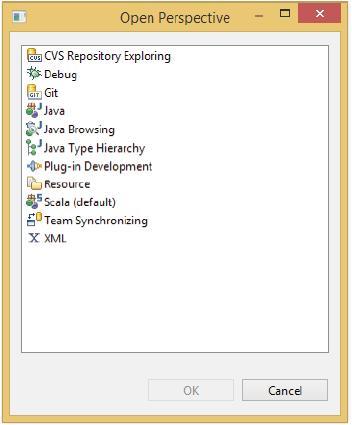

1)将Eclipse Scala IDE插件中的features和plugins两个目录下的所有文件复制到Eclipse解压后对应的根目录中。重启Eclipse,单击Eclipse右上角方框按钮,如图5-7所示,在弹出的Open Perspective对话框中查看是否有“Scala”一项,如果有则直接单击打开。

图5-7 安装插件

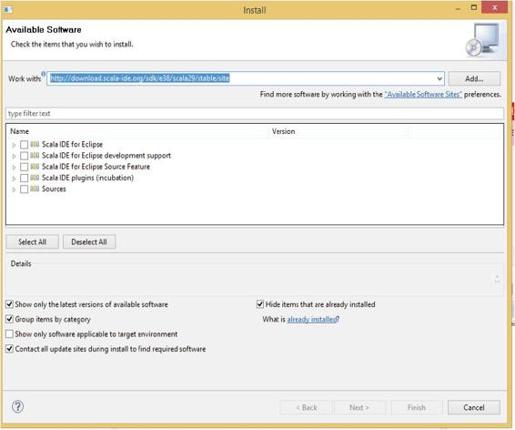

2)在Eclipse中,选择Help按钮,然后点击Install New Software命令,在打开的输入框里填入http://download.scala-ide.org/sdk/e38/scala29/stable/site,并按回车键,可看到以下内容(见图5-8中加框突出部分),选择Scala IDE for Eclipse和Scala IDE for Eclipse development support两项进行安装即可,如图5-8所示。

图5-8 设置安装选项

3)直接下载Scala IDE,可以在官网http://scala-ide.org/下载。现在的ScalaIDE中默认自带了Eclipse,用户可以直接使用。

3.开发Spark程序

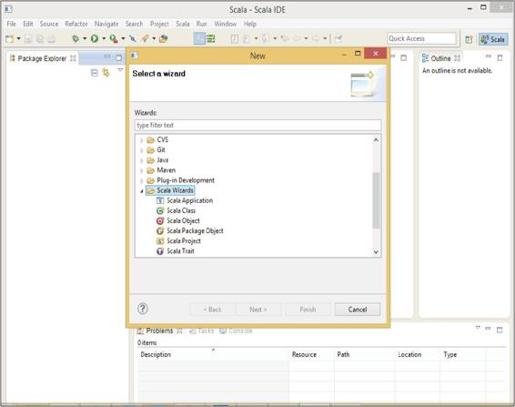

1)在安装好Scala插件的Eclipse中,选择File→New→Other命令,在弹出的New窗口中选择Scala Wizard→Scala Project命令,创建Scala项目,如图5-9所示。

图5-9 创建Scala项目

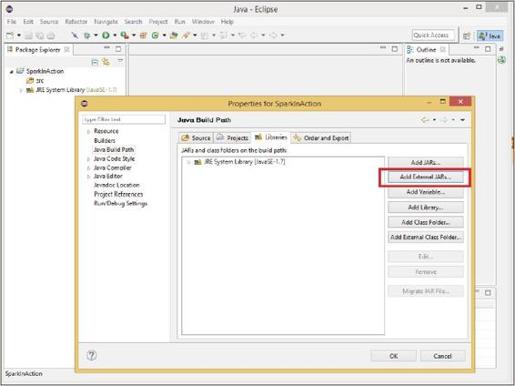

2)右击新建工程,在快捷菜单中选择Properties命令,在弹出的窗口(见图5-10)中依次选择Java Build Path→Libraties→Add External JARs即可,导入assembly/target/scala-2.9.3/目录下的spark-assembly-1.0.0-incubating-hadoop2.2.0.jar(这个包可以通过sbt/sbt assembly生成,也可以在预编译版本的Spark中找到)。

图5-10 增加外部Jar

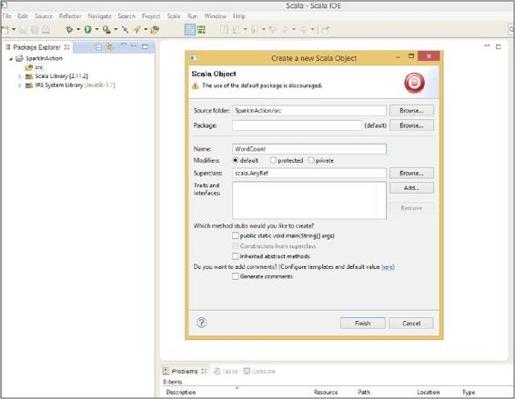

3)在工程中创建一个Scala对象(Object),命名为WordCount,在Name后的输入框填入WordCount,如图5-11所示。

图5-11 创建Scala类

WordCount是一个测试程序,统计输入的词频,读者可以参考第6章来了解。

在SparkTest工程中,右击WordCount.scala,在弹出的快捷菜单中选择Export命令,然后在弹出的窗口中选择Java→JAR File命令,将文件命名为WordCount。最后生成WordCound.jar的可执行Jar包。

或者直接在SparkContext中将第一个参数配置为local,然后直接在Eclipse点击run按钮,本地运行程序。

提示 Java语言开发Spark程序。

提示 Java语言开发Spark程序。

将Spark开发程序包spark-assembly-1.0.0-incubating-hadoop2.2.0.jar作为第三方依赖库。由于Scala也是运行在JVM之上,并且可以和Java合编程,所以可以按原有方式开发Java程序并调用Spark中的API。

[1] 下载的Eclipse版本一定要与Eclipse Scala IDE插件版本一致。