2.6.6 FCoE与I/O整合

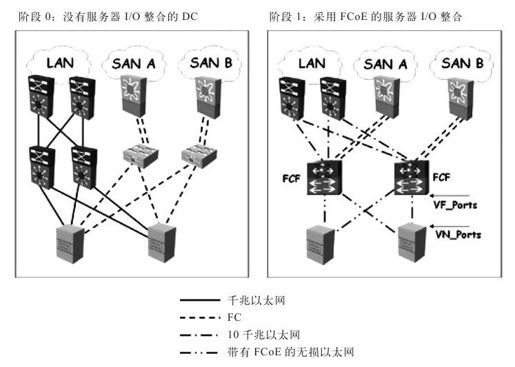

如果读者认为前述FCoE内部工作机制过于复杂,希望本小节对你来说更容易理解一些,我们将在本小节讨论各类FCoE支持的I/O整合的过程和方案。当下的DC看起来与图2-23左边部分类似,存在以下局限:

图 2-23 FCoE阶段1部署

·并行以太网LAN以及FC SAN基础设施均基于各种互连媒介和协议。以太网比FC更具“全球化”,而FC更具战略意义,因为它涉及了服务器I/O以及存储访问问题。

·服务器多重连接存在很多问题,包括:

·增加了适配器及线缆开销。

·每个连接都会增加光纤的故障点。

·增加了电力及冷却成本。

·增加了服务器开通的引导时间。

·管理复杂度,包括:

·需要不同的以太网以及FC接入层或架顶式(Top-of-Rack,ToR)交换机。

·以太网及FC的组合带来了多个容错管理域,增加了故障处理及诊断的复杂性。

·使用完全不同的以太网与FC设备,增加了固件升级、驱动补丁及版本配置的复杂性。

统一DC光纤实施的第1阶段(也是最实用的阶段)为服务器集群与接入层整合,如图2-23右边所示。我们已经了解了大部分利用服务器虚拟化技术(更多细节请参考2.3节)进行服务器整合的方法,接下来的本小节将对多适配器整合进行探讨。读者可以参照图2-23两部分进行“整合前后效果”比较。在阶段1未实施之前,每个服务器都配备了两块以太网NIC以及两块FC HBA。进行阶段1整合后,将4块服务器适配器缩减到2块CNA。而DC LAN以及SAN网络流传输也可以在同一10GE线缆上完成,不再需要使用不同线缆(1根用于以太网,1根用于本地FC)。因此原来需要8根线缆,经过整合缩减成4根,提高了高速带宽(10GE)链路的有效共享效率。

在接入层交换机这端,原来需要两个ToR以太网交换机以及两个ToR FC交换机,整合后被缩减到一对ToR交换机——一对FCF(FCoE交换机),由此简化了接入层及线缆,降低了系统总体拥有成本(Total Cost of Ownership,TCO)。同样因为从汇聚层角度(或上层)看,现有已安装好的LAN及SAN基础设施并未受到影响,保护了投资。现在由于所有服务器I/O已经整合至FCoE,并直接连接到FCoE接入层的交换机,使得接入层获得了操作一致性。来自接入层FCF到汇聚层以太网交换机的上行链路也已经升级成10GE链路。尽管阶段1仍然缺乏云IaaS所需的快速部署基础设施(统一DC光纤),但人们依然期望它成为最常见的FCoE部署起步。

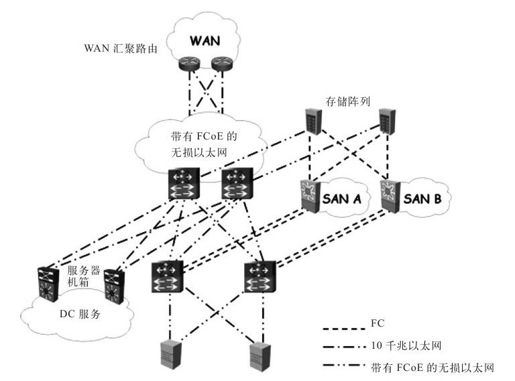

图2-24展示了阶段2部署。此时,焦点已经转移到DC LAN的分布或汇聚层。原来的汇聚层交换机被迁移到服务汇聚层,被当做外部服务机箱,提供DC服务(例如,防火墙以及服务器负载平衡)。两个汇聚层FCF被安排在原来汇聚层交换机的位置,负责将遗留的DC以太网LAN改造成具备FCoE能力的无损以太网。阶段2实施为访问存储阵列提供了一定的自由及冗余,既可以通过本地FC也可以借助无损以太网,使得我们离阶段3废除并行网络基础设施又近了一步。鉴于在阶段2DC光纤已经实现了某种程度的统一,因此基础设施部署会变得更加敏捷,其TCO成本也更低廉,而这也恰好是建立一个成功云计算所需要的。按需求基本快速部署非常接近自适应SOI,能够响应渐变商务需求,因而推荐在云IaaS的光纤模块(参见图2-2)完成阶段2。为了完成整个布局,服务机箱以及WAN汇聚路由都通过10GE链路连接到这个“半统一”DC光纤上,更多有关DC服务汇聚以及未来WAN的内容,请参考本书第3章。

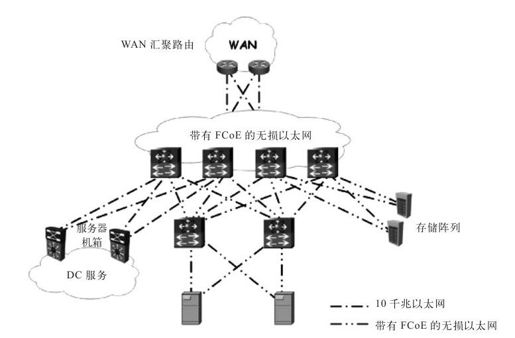

图2-25展示了FCoE部署的第3个阶段,此时DC LAN以及SAN已经实现了网络范围统一光纤,本地FC交换机与FC存储阵列都被转换成了FCoE I/O接入。完全的统一光纤实现了一致的DC网络协议,又进一步降低了TCO。

图 2-24 FCoE阶段2部署

图 2-25 FCoE阶段3部署

尽管阶段3是云计算的理想场景,但某些技术仍然停留在测试阶段,在短期和中期内无论是基于感情因素还是节约投资的原因,都不可能完全废除现有的本地FC基础设施,因此阶段3也缺乏实际意义,但阶段3依然是云的理想目标,因为它代表了某些未来的目标。我们采取递增式方法,首先完成第1阶段的部署,紧接着完成第2阶段部署,最后是阶段3部署,实现最终目标。

从长远发展看,人们期望云IaaS供应商能够以他们自己的节奏从阶段2发展进入到阶段3,统一DC光纤最终有可能是阶段1及阶段2的混合,这将依赖于云IaaS服务对SOI的迫切需求究竟有几分。另一方面,新的企业DC建设可以直接进入第3阶段,实现统一的光纤网络基础以便迅速推动私有云计算服务发挥效用。更多有关FCoE的设计方案探讨请参考9.4节。

关于线缆的探讨

I/O整合对DC机架这一级带来了怎样的影响呢?适配器、交换机端口以及线缆需求的显著缩减,大大降低了电力消耗、冷却成本甚至设备占用空间,契合了绿色IT的初衷。在线缆接口这方面,已经从原来的小封装可插拔(Small Form-Factor Pluggable,SFP)技术升级到能够支持10Gbps数据速率的SFP+收发器。SFP+面板密度与SFP面板密度兼容,但能耗更低,更重要的是SFP+能够向下兼容SFP的光模块。

为了使DC机架能够适用于FCoE方案,推荐采用SFP+以及copper(CX-1)Twinax型线缆,该类线缆体积小(直径大约为6mm),能够灵活地放置在机架内,从而简化了线缆部署工作,缩短了部署时间。此外,线缆能耗更低,错误率基本可以忽略不计(10-15),更重要的是线缆成本较低。尽管线缆的距离限制为10米(33英尺),但已经足够将服务器的几个机架(大约1~5个)连接到通用ToR交换机上。

说明:尽管SFP+CU Twinax线缆规范允许的连接距离为10米,但线缆连接距离的可选范围通常为1米、3米或5米。

机架技术

一个接入层构件被称为一个pod(机柜组),每个pod规定了连接到该网络汇聚模块的服务器数量,为了便于模块式组建,DC接入层被划分成多个pod。pod内部服务器连接由ToR接入层交换机在机架层完成,交换机再连接到网络汇聚层,这种方式有利于机架滚动式(rack-and-roll)部署,实现DC内快速服务器服务。Pod由服务器机架构成,与下述具体机架技术无关:

·列末(End-of-the-row)拓扑:列末拓扑将大型直接交换机设备放置在每列服务器机柜的末端,因而需要大量线缆绑定在一起将服务器机架连接到网络机架。列末拓扑的主要优势在于只要配置少数连接点(交换机)就能控制很多服务器端口。

·架顶(Top-of-the-rack)拓扑:架顶拓扑在每个服务器机架顶部放置1个或2个机架单元(Rack-Unit,RU)接入层交换机设备,实现每个机架之间服务器的连通。因为减少了机架到末端交换机之间的线缆,所以架顶拓扑的线缆利用率要优于列末拓扑,但由于架顶拓扑需要占用更多的ToR交换机,因此其管理负载要大于列末拓扑。

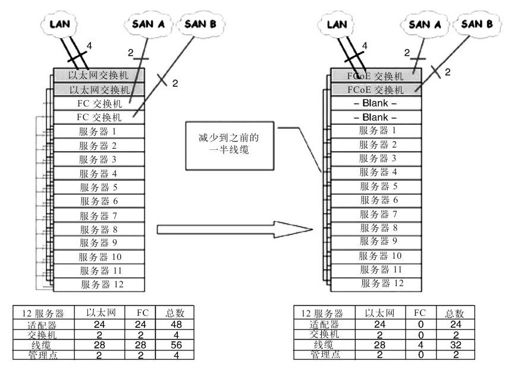

使用FCoE进行I/O整合缩减了服务器所需的适配器数量,也减少了服务器所需线缆数目,从而简化了列末拓扑中对线缆的管理。由于FCoE已经将本地FC扩展到了以太网,不再需要单独的ToR FC交换机,换句话说,也就是只采用一组同构的ToR FCoE交换机即可,因此这也减少了架顶拓扑中对ToR交换机的需求量。

图2-26展示了一个经过简化了的FCoE1阶段(参见图2-23)部署中采用的架顶拓扑,样例中使用了12个服务器,通过FCoE对I/O的整合,将总体线缆数从原来的56根缩减到现在的32根(缩减率大约为43%),单口适配器也从原来的48块缩减到现在的24块(50%的精简),ToR交换机从原来的4个减少到2个(50%的精简)——从DC整合观点来看不算坏,但如果放在私有云计算环境下显然很有优势。

图 2-26 FCoE带来的线缆精简

滚动式部署。更多有关ToR架构及设计的内容,请参考9.5节的内容。

说明:如果使用双口适配器,在进行FCoE阶段1改造前,总共需要24个单元,而经过整合,所需单元数减少到12个。