8.2 统一计算系统

现有服务器部署模式通常分成两类:scale-up(纵向扩展)模式以增加更多的处理器、内存、I/O设备等资源对单个服务器的计算能力进行扩充;scale-out模式(横向扩展)模式则以增加服务器个数为基础。大多数企业DC更倾向于后者,因为它可以使用标准的计算组件,而这种更受欢迎的scale-out模式也催生了另外一种DC现象——服务蔓延。

服务器虚拟化对减少服务蔓延起着关键作用,被全球性机构广泛采用。通过虚拟化,一个物理服务器可以同时包含多个虚拟服务器,虚拟化软件更可以配备与物理交换机等同的虚拟接入层交换机(例如,NX1KV交换机)。该选择scale-up还是scale-out呢?或者同时选择两种模式,或者更好的,逆向思维转换?其实,我们更应该关注如何解决当前部署中遇到的局限而非辩论哪种模式更好,本章将以Cisco统一计算系统(Unified Computing System,UCS)作为样例平台进行深入探讨。

随着私有云计算应用越来越广泛,能够迅速转换职能的“匿名”服务器也快速成为企业用户的常见需求,这些新服务器必须能够支持大量的VM,能够灵活处理VM在不同服务器之间的转移,具备由协议驱动的管理系统,并能够向云软件提供丰富的接口API。

由于需要支持多租户,而每个租户又拥有自己的VM,所以物理服务器的RAM很可能在CPU资源枯竭之前就不够用了,因而许多企业DC在考虑云IaaS服务时一个关键需求是能够向服务器增加足够多的RAM。为此,UCS刀片服务器,使用了下一代CPU,内存扩展技术以及I/O技术,能够支持最多可扩展至384GB的大容量RAM。

为了简化服务器在DC间移动的配置工作,UCS没有把各类组件的标识信息(MAC地址、UUID等)固化到硬件中,而是放在配置文件里面,这也意味着:在某个DR站点重新建立一个相同的UCS,就和拷贝一个配置文件一样简单。

通常都是产品开发生命周期后期才加上管理工具,因此它们与整个受控单元并不是紧密集成在一起。UCS拥有一个嵌入管理处理器,能够对所有组成UCS的管理单元(元素)进行全局化管理,从而强化了控制,也提供了集成的管理和分析。

此外,UCS是按照ToR模式(更多细节请参考第2章的“支架拓扑”内容)设计的,所有属于UCS的服务器都连接到两个fabri上,被安放在某个或少数机架的顶端,服务器之间的通信按照统一架构(集中网络)方式(更多细节请参考第2章的“数据中心互连阵列”的相关内容),这种方法能够显著减少布线信道。

总而言之,UCS能够很好地克服当前企业DC中服务器部署局限,可以为私有云计算以及云IaaS服务提供理想的计算平台。

说明:本章探讨了UCS对私有云计算的可用性,这一节仅为临时性探讨,并不属于权威性引导,建议读者在进行与UCS相关的产品评估、方案设计或商务咨询时参阅合适的官方文档,本书作者对内容正确性概不负责,对任何错误或歧义也不承担法律责任。

8.2.1 UCS使能技术

UCS为一个系统而不仅仅只是一个服务器机架,UCS在DC中的汇聚端点在网络层,换句话说,也就是,UCS以网络作为关键平台,UCS的部分使能技术包括:

·FCoE(更多细节请参考2.6节)

·虚拟NIC标签(Virtual NIC Tag,VNTag)

·内存扩展

·统一管理

这些使能技术有效地去掉多余的交换机、适配器、电缆以及管理模块,为私有云计算环境带来了一个更好的流线型服务器部署方式。

VNTag

VNTag是一个6字节的以太网标签,添加在以太网帧的目的及源MAC地址对(MAC-DA和MAC-SA)之后。传统的以太网交换机不支持对源及目标MAC地址都在同一端口的帧的转发,所以也不支持对位于同一交换机端口的两个VM之间的帧的转发,VNTag为交换机上的每个VM创建了一个虚拟以太网(Virtual Ethernet,VEth)接口,解决了这个问题。

说明:IEEE MACsec(认证和封装)标签可以放在VNTag标签前面。

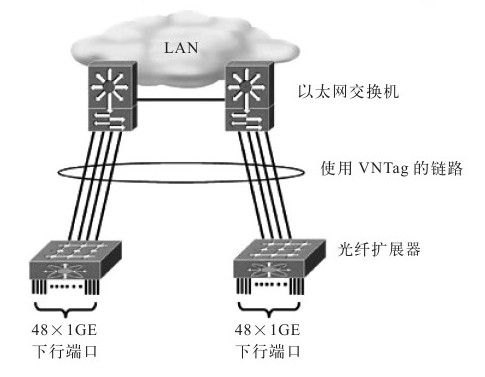

换句话说,VNTag将每个vEth接口与一个vNIC绑定,逆向操作也是一样。具备“VNTag感知”能力的交换机能够完成不同vEth接口的转发,实现位于同一物理端口上的VM之间的帧转发。系统通过VNTag标签中的目标虚拟接口标识(dst_vif,14位)和源虚拟接口标识(src_vif,12位)对这些VM进行区分。可以在带有VNTag标签功能的NIC或hypervisor的内置软件实现VNTag标签,也可以作为单独的盒子,当做光纤扩展器实现,承担面向以太网交换机的远程多路转换器责任。图8-3展示了两个连接到以太网交换机的光纤扩展器的样例,每一个光纤扩展器都拥有4×10GE上行以太网交换机以及48×1GE的连接服务器的下行端口,从光纤扩展器到以太网交换机的上行链路使用VNTag标签头部,48个下行1GE端口分别分配了一个虚拟接口(Virtual Interface,vif)标识。

图 8-3 光纤扩展器

说明:Palo由Cisco开发的CNA,支持VNTag标签。

内存扩展

虚拟软件要求能够支持多个OS实例同时运行,因此需要占用大量内存空间,为了得到更大的内存容量,大多数IT机构都不得不选择扩充到拥有4个socket的四路服务器,这样的服务器通常不但造价昂贵,能源消耗和监测成本都相应更高。

Cisco扩展内存技术选用标准的双倍速率同步动态随机存储器3(double-data-rate three,DDR3)型内存,通过逻辑上改变主存结构,实现CPU中的内存控制器能力扩展。采用这一技术后,能够将扩展内存刀片服务器上的每4个双列直插式存储模块(Dual In-line Memory Module,DIMM)映射为在CPU内存控制器眼中的单一逻辑DIMM,且存储能力是之前单个DIMM的4倍。例如,使用扩展内存技术后,原来4个标准的8G容量的DDR 3 DIMM,将变成一个单独的32GB DIMM。这种独特的内存扩展技术支持在2端口服务器上也能实现内存增量扩充,而不是一下子就必须叉车式升级到4路服务器。

对于需要大量内存的虚拟环境而言,选用更小容量的DIMM来代替8GB的DIMM,尽管不一定达到384GB容量,仍然可以节省很多成本,至少8个1GB的DIMM肯定要比1个8GB的DIMM要便宜。

统一管理

UCS管理器(UCS Manager,UCSM)属于嵌入式设备管理软件,通过直观的图形用户界面(GUI)、命令行界面(CLI)或基于XML的应用编程接口(XML API),以单一逻辑实体对UCS系统进行管理,它创建了一个统一的管理域,具备集中管理能力,使用服务配置文件和模板实现了基于策略和基于角色的管理。

可以将UCS的资源当成抽象资源,因为资源标识、I/O配置、MAC地址、WWN、固件版本号、BIOS启动顺序、网络属性(包括QoS配置、ACL、pin组、阈值策略)等信息都可以通过实时部署模型编程得到,UCSM将标识、连接信息、配置信息都放在服务配置文件中,可以在服务配置文件中根据特定软件堆栈需要提取资源属性信息。借助配置文件,可以实现管理域内从服务器到网络的移动,使得系统资源的使用变得非常灵活。可以在服务配置文件模板中对资源进行分级定义,并根据预定义池的内容给它们分配相应的资源标识。

说明:UCSM驻留在fabirc阵列(相关内容请参见8.2.2节)上,属于NX-OS模块(插件型),由运行在光纤阵列上的NX-OS对它进行管理、监测以及控制。

此外,UCSM支持多租户环境,对内部客户端、终端用户处理也与单独商务实体相同。可以将系统逻辑划分后分配到不同的客户端或用户及管理者,看起来就像为这些用户建立了一个专属环境一样。